Alberto entra al salón una tarde cualquiera y descubre que su hija de 12 años está hablando con la IA de Google. Le ha pedido un resumen de un cuento de Óscar Wilde, la lista de personajes y posibles preguntas de examen para Lengua de 1º de ESO. No hay profesor cerca, ni libro, ni padre revisando. Solo una niña, un portátil y una inteligencia artificial que responde sin pestañear.

La niña asegura que ya leyó el cuento un mes antes y que solo quiere repasar porque se ha dejado el libro en el instituto. El padre, que conoce sus buenas notas, acepta la explicación, pero algo se le queda clavado. Intuye que no está ante una simple chuleta digital.

Cuando María Sánchez, presidenta de la confederación de familias de la escuela pública Ceapa, escucha historias como la de Alberto, no se sorprende. Explica que escenas parecidas se repiten en miles de hogares españoles, desde los últimos cursos de Primaria hasta la ESO. Muchos chavales ya piden a la inteligencia artificial que les resuma libros, les prepare esquemas y les sugiera preguntas de examen, casi siempre solos en su habitación.

Ceapa agrupa a más de 12.000 asociaciones de madres y padres de alumnos de colegios e institutos públicos, así que lo que ve María no es una anécdota, es una tendencia. La mayoría de familias no sabe muy bien cómo reaccionar cuando descubre este nuevo uso de la IA para estudiar. Algunos progenitores ni siquiera son conscientes de que estas herramientas pueden equivocarse, inventar datos o dar respuestas engañosas con un tono muy seguro.

También te puede interesar:La IA Golpea Primero al Junior: Consultoras Congelan Salarios y Temen un Efecto DominóEsta entrada directa en las casas recuerda mucho a lo que pasó con las redes sociales. Primero llegaron a los móviles de los adolescentes y solo después reaccionaron familias, escuelas y administraciones. Para María Sánchez, con la inteligencia artificial está ocurriendo algo muy parecido: la tecnología entra en los hogares y en los deberes sin regulación previa, sin que exista aún un marco claro ni un plan público bien definido.

Desde Cataluña, Lidón Gasull, directora de Affac, la principal entidad de familias catalanas con 2.400 Ampas, comparte el diagnóstico. Afirma que la inteligencia artificial genera preocupación y controversia entre las familias, pero defiende que no se trata de ponerse en contra por sistema. Su mensaje es otro: hay que poner límites, regular y ser muy cautelosos porque hablamos de una población especialmente vulnerable que está construyendo su forma de pensar.

Gasull admite algo que incomoda pero es real: todavía no se dispone de información suficiente ni de un control sólido sobre el impacto de la IA en cómo aprenden los menores. La administración educativa, dice, va muy por detrás de lo que ya está pasando en las casas y en muchos centros. Hasta diciembre pasado el Gobierno no publicó un informe de recomendaciones sobre pantallas en colegios y redes sociales en menores, y de momento no existe una regulación específica para el uso educativo de la inteligencia artificial.

Solo Galicia prepara una normativa centrada sobre todo en lo que ocurre dentro del aula, mientras el Ministerio de Educación promete abordar “más adelante” la cuestión de la IA junto al Ministerio de Transformación Digital. El problema es que los adolescentes no están esperando esa conversación. Ya la tienen abierta en su móvil, con cada búsqueda, cada resumen y cada trabajo que le piden a un chatbot.

También te puede interesar:La IA Golpea Primero al Junior: Consultoras Congelan Salarios y Temen un Efecto DominóNo todo uso de la inteligencia artificial para estudiar es igual ni tiene por qué ser dañino. Los expertos suelen trazar una línea clara entre dos formas de uso: por un lado, un uso pasivo, en el que pides que haga el trabajo por ti; por otro, un uso activo, en el que la IA te ayuda a estudiar mejor pero no sustituye tu esfuerzo. La diferencia parece sutil, pero cambia por completo el efecto sobre tu aprendizaje.

En el uso pasivo, el alumno pide a la IA que redacte su trabajo, que “le lea” el libro con un resumen completo o que resuelva los ejercicios paso a paso sin que él se implique. Comandos típicos son “haz mi tarea”, “escribe mi redacción” o “resuelve este problema”. A corto plazo puede parecer cómodo, incluso “listo”, pero las consecuencias cognitivas pueden ser muy negativas. Pierdes práctica, entrenas menos la memoria y, al final, entiendes peor la materia.

En etapas como Primaria y Secundaria, todo esto pesa aún más. Allí las tareas están pensadas precisamente para que aprendas mientras las haces. No son solo “trabajo” que sobra, son parte del propio proceso para que adquieras conocimientos y habilidades. Si la inteligencia artificial hace ese tramo por ti, el famoso “ahorro de tiempo” deja de tener sentido, porque lo que estás ahorrando no es tiempo muerto, es tiempo de aprendizaje.

En educación superior, donde las tareas son más complejas y autónomas, tiene algo más de lógica delegar pequeñas partes mecánicas a la IA para centrarse en lo que aporta más valor. Pero en la ESO, el balance cambia. Si un adolescente deja que la IA resuelva ejercicios de Matemáticas o haga las comprensiones de lectura, probablemente sacará adelante la ficha de hoy, pero se le atragantará el examen de mañana. Y, con el tiempo, los centros tienden a reaccionar.

También te puede interesar:La IA Golpea Primero al Junior: Consultoras Congelan Salarios y Temen un Efecto DominóMuchos expertos coinciden en que, a medida que la inteligencia artificial se haga más común, las evaluaciones se volverán más presenciales y prácticas. Más exámenes en papel, más tareas en clase, más trabajos orales. El objetivo será limitar las trampas y la dependencia de estas herramientas. El alumno que se haya acostumbrado a pedir “soluciones mágicas” a la IA tendrá entonces un problema: en el aula no habrá asistente automático que le rescate.

En el otro extremo aparece el uso activo y positivo de la inteligencia artificial para estudiar. Aquí el enfoque cambia por completo: la IA no hace la tarea por el alumno, sino que ayuda a aplicar técnicas de estudio que la investigación ya ha demostrado eficaces. La máquina se convierte en un apoyo para repasar, organizar ideas y entrenar la memoria, y no en un atajo para esquivar el esfuerzo.

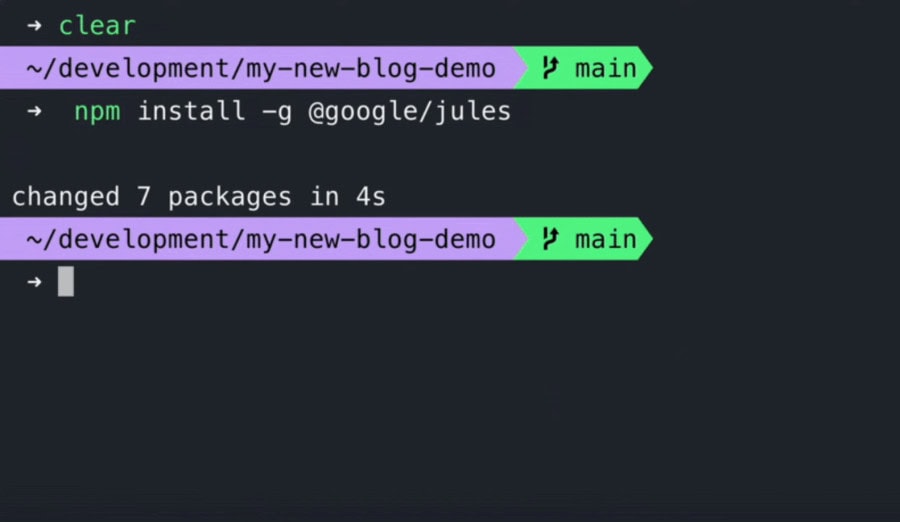

Ben Gomes, director de Aprendizaje y Sostenibilidad de Google, insiste justo en este potencial cuando se usa bien. Propone, por ejemplo, que introduzcas en una aplicación de IA un tema de Historia y le pidas que genere tarjetas de pregunta-respuesta, las llamadas flashcards, o pequeños cuestionarios. Estas tarjetas se usan luego para autoexaminarte y practicar la evocación, es decir, recuperar de tu memoria lo que has estudiado sin mirar el libro.

La evocación es una de las técnicas de estudio mejor valoradas por la investigación educativa. En varios estudios se ha observado que los estudiantes que se autoevalúan con frecuencia recuerdan más y durante más tiempo. Como resume una revisión reciente, “practicar la recuperación de la información mejora el rendimiento más que releer el contenido una y otra vez”. Aquí la inteligencia artificial puede ser un aliado ágil y, sobre todo, muy personalizable.

Gomes sugiere también otras aplicaciones útiles: pedir a la IA que genere mapas mentales para organizar los conceptos de un tema o que prepare un pequeño guion de podcast con los puntos clave para escucharlos mientras caminas o haces deporte. Así conviertes parte del repaso en algo más flexible, que se adapta mejor a tu día a día, sin dejar de exigir que prestes atención y compruebes si realmente entiendes lo que escuchas.

Aplicaciones como NotebookLM, ChatGPT o Le Chat ya permiten crear estas tarjetas, cuestionarios, mapas mentales o audios a partir de tus apuntes, un libro escaneado o un documento digital. Si tú sigues siendo quien toma decisiones, pregunta, corrige y compara con el material original, la inteligencia artificial puede reforzar tu estudio. El riesgo llega cuando pasas a aceptar cualquier respuesta sin verificarla o esperas que “piense” por ti sistemáticamente.

Cómo usar la inteligencia artificial para estudiar sin que haga el trabajo por ti

En esta línea se habla cada vez más de “aprendizaje guiado”. Son aplicaciones que se parecen más a un tutor socrático que a un solucionador automático. En lugar de soltar la respuesta final, te lanzan preguntas, muestran ejemplos y te dan pistas para que tú intentes resolver primero la tarea. La idea es que te esfuerces, falles, corrijas y, al hacerlo, consolides mejor lo aprendido.

Varias grandes compañías de tecnología educativa aseguran que priorizan este enfoque y buscan que la interacción sea más visual, con pasos intermedios, dibujos o esquemas. Incluso en estos sistemas aparece una tensión clara entre el diseño pedagógico ideal y los intereses comerciales. Google, por ejemplo, ha decidido no incluir en su sistema de aprendizaje guiado Gemini un control parental o docente que bloquee por completo la opción de dar la solución directa a un ejercicio.

Gomes argumenta que, si se ponen demasiadas trabas, muchos estudiantes podrían frustrarse y dejar de usar la aplicación. Y, en segundo plano, asoma otro temor: si una plataforma “pone pegas” para entregar respuestas completas, los alumnos pueden marcharse a otras apps de la competencia que sí lo hagan. Esta carrera por no perder usuarios puede empujar a los productos a ser más permisivos de lo que sería pedagógicamente deseable.

Ahí entra una voz incómoda pero muy realista, la de Dennis Mizne, director general de la Fundación Lemann, que trabaja con proyectos educativos que llegan a cientos de miles de alumnos en Brasil. Mizne cree que detrás de muchos discursos sobre “la IA como mentor personal sin necesidad de padres o profesores” hay un fallo de partida: se sobreestima cuánto quiere aprender de verdad la mayoría de estudiantes cuando están solos ante la pantalla.

Según Mizne, la mayoría de alumnos no entra en una app de inteligencia artificial buscando una explicación paciente paso a paso. Lo que quiere, casi siempre, es acelerar el proceso. Por eso las órdenes que más se repiten son del tipo “haz mi tarea”, “escribe mi redacción” o “resuelve este ejercicio”. En su opinión, ese uso no va a producir niños mejor educados ni mejor preparados para el futuro, sino más dependientes de soluciones externas.

Lo curioso es que, para este experto, parte del problema viene de los propios desarrolladores. Muchas de las personas que crean herramientas de inteligencia artificial educativa son muy apasionadas por el conocimiento, leen por placer y disfrutan aprendiendo. Están sobrerrepresentadas las personas extremadamente motivadas, y eso hace que proyecten su propia actitud sobre un alumnado que, en realidad, no suele funcionar así. Son más la excepción que la norma.

Frente a este choque entre diseño ideal y uso real, tanto Mizne como las presidentas de las grandes confederaciones de Ampas españolas coinciden en pedir algo muy concreto: regulación. Quieren que los gobiernos marquen normas claras para las aplicaciones de IA educativas y exijan que se desarrollen de la mano de expertos en educación, directores de centros, docentes y familias. No basta con lanzar productos al mercado escolar y esperar que se adapten solos.

La idea es sencilla pero ambiciosa: reducir riesgos y lograr que la inteligencia artificial se ajuste de verdad al funcionamiento real de la escuela. La experiencia histórica invita a la prudencia. La escuela ha demostrado una gran capacidad de resistencia a tecnologías que parecían destinadas a revolucionarlo todo. Pasó con los ordenadores personales, con el desembarco masivo de Internet y con la llegada de los móviles al aula.

Riesgos de la inteligencia artificial en la escuela: adoctrinamiento y nueva brecha educativa

Algunos investigadores avisan de que la IA puede traer un riesgo distinto, menos visible que las notas o las trampas. La politóloga Agustina Paglayán, profesora en la Universidad de California en San Diego, lo resume así en su trabajo sobre historia de la educación de masas: los sistemas educativos modernos no nacieron solo para difundir el conocimiento, sino también para formar ciudadanos obedientes y construir Estados fuertes.

Paglayán muestra cómo Prusia fue pionera en el siglo XVIII al crear un sistema de educación de masas con esa finalidad política, y cómo después otros países europeos, americanos, asiáticos y africanos siguieron caminos parecidos en el siglo XIX. Históricamente, los principales instrumentos de adoctrinamiento de los Estados han sido los libros de texto oficiales y el control sobre la formación y contratación del profesorado.

Incluso en contextos autoritarios, muchos docentes han conservado cierto margen de autonomía. Han cuestionado los libros, han introducido perspectivas alternativas y han fomentado, aunque fuera de forma limitada, el pensamiento crítico. Esa pequeña distancia entre el poder político, el texto oficial y lo que ocurre en el aula ha sido un espacio importante de libertad.

Con la inteligencia artificial, el escenario cambia. Un software educativo puede no solo exponer a un estudiante a un conjunto de ideas, sino también reiterarlas cada vez que pregunte algo relacionado. Y, si el sistema está configurado para responder siempre en la misma dirección, puede reforzar permanentemente una visión única del mundo. El riesgo de que se reduzca el pensamiento crítico del alumnado ya no viene solo de los Estados, sino también de grandes empresas privadas dueñas de las plataformas.

Por eso muchos expertos coinciden en que el alumnado debe recibir en la escuela formación específica sobre el uso adecuado y crítico de la IA. No se trata solo de aprender a pedir buenos resúmenes, sino de entender cómo se entrenan estos sistemas, por qué pueden equivocarse y qué sesgos arrastran. Si la escuela decide ignorar esta realidad, se abrirá una nueva brecha: quienes tengan familias capaces de acompañarles en este proceso partirán con ventaja; quienes no, quedarán expuestos y desorientados.

Mientras llegan regulaciones más sólidas, algunas voces proponen una especie de “freno de mano” responsable. Rebecca Winthrop, directora del Centro de Educación Universal de la Institución Brookings, habla de un “uso minimalista de la IA” en educación. Su enfoque es claro: priorizar soluciones no digitales cuando no haya pruebas firmes de que la tecnología mejora los resultados de aprendizaje.

Cuando sí existan evidencias de que una herramienta concreta ayuda, Winthrop recomienda elegir siempre las opciones menos invasivas. Entre varias alternativas tecnológicas, sugiere seleccionar las que tengan menor coste económico y menor impacto ambiental. Recuerda que el consumo energético de la inteligencia artificial es muy alto y que este campo tiene aún mucho margen de mejora para ser compatible con los objetivos climáticos que estos mismos alumnos escuchan en clase.

Ceapa, por su parte, ha elaborado una guía para familias y chavales sobre riesgos y oportunidades educativas de la IA, que presentará en diciembre. Su objetivo es ofrecer ejemplos prácticos de buen uso, advertir de los peligros de delegar todo en la máquina y explicar de forma sencilla qué pueden hacer madres y padres que no dominan la tecnología. Esa guía llega a un escenario que ya está en marcha, no a una hoja en blanco.

Te encuentras, por tanto, ante una inteligencia artificial que ya forma parte del estudio de muchos adolescentes, pero cuyo funcionamiento educativo todavía no está bien encajado ni en la escuela ni en las normas públicas. La clave estará en cómo la uses tú, en la formación que recibas y en si las futuras regulaciones priorizan de verdad el bienestar de los menores y el cuidado del planeta.

Directora de operaciones en GptZone. IT, especializada en inteligencia artificial. Me apasiona el desarrollo de soluciones tecnológicas y disfruto compartiendo mi conocimiento a través de contenido educativo. Desde GptZone, mi enfoque está en ayudar a empresas y profesionales a integrar la IA en sus procesos de forma accesible y práctica, siempre buscando simplificar lo complejo para que cualquiera pueda aprovechar el potencial de la tecnología.