Un cerebro humano funciona a tiempo completo con unos 20 vatios, el consumo de una bombilla tenue. Para que una gran plataforma de inteligencia artificial haga algo parecido, necesita un centro de datos que traga electricidad como una ciudad entera. La Agencia Internacional de la Energía (IEA) ya pone fecha a este choque entre algoritmos y redes eléctricas.

Según la IEA, el consumo eléctrico de los data centers podría más que duplicarse de aquí a 2026 y acercarse o superar los 1.000 TWh anuales, un nivel similar al consumo de todo Japón. Ese salto no se reparte de forma abstracta por “la nube”, sino en instalaciones concretas en Estados Unidos, Europa o Asia que pelean por megavatios muy reales. Algunas de estas granjas consumen lo mismo que decenas de miles de hogares.

En 2024, los centros de datos usaron ya alrededor del 1,5 % de la electricidad global, y las proyecciones apuntan a que, hacia 2030, esa cifra puede rondar el doble. El impulso principal viene de la expansión de la inteligencia artificial generativa y otros sistemas de cómputo intensivo. El problema no es solo cuánta energía piden los servidores, sino cómo se organiza toda esa demanda y de dónde sale exactamente.

Cada vez que haces una consulta a un modelo de IA de última generación, el sistema ejecuta millones de operaciones en chips especializados, mueve datos por redes internas y activa sistemas de refrigeración que no descansan. Estimaciones recientes sitúan el consumo energético de una pregunta típica en torno a 0,3 Wh por interacción.

También te puede interesar:Kai-Fu Lee Describe el Futuro de la Educación Frente a la IA y su Diagnóstico es más Duro de lo que Muchos Esperaban

Cuando sumas millones de pequeñas consultas, el resultado deja de ser una anécdota. La combinación de consumos modestos por cada interacción con una escala masiva de uso acaba generando consumos totales de gigavatios-hora y, más pronto que tarde, teravatios-hora. Nature recoge el consenso de que el consumo eléctrico de los centros de datos podría duplicarse hacia 2030, y no se trata de un escenario extremo, sino del punto medio que muchas previsiones consideran razonable.

El MIT lleva meses avisando de lo que esto significa para el sistema eléctrico y el clima. Su advertencia es clara: la expansión acelerada de centros de datos para IA aumenta las emisiones y la presión sobre redes y recursos como la electricidad y el agua. Según los análisis del instituto, la situación obliga a repensar desde cero la arquitectura de los centros, su ubicación y las fuentes energéticas que los alimentan, para que no se conviertan en un cuello de botella permanente.

La revista Nature y la comunidad académica están en la misma línea y piden datos abiertos y verificables sobre uso de energía y agua. No basta con notas de prensa optimistas. “Si no sabemos cuánta energía usa la IA y dónde la usa, tampoco podemos gobernarla de forma responsable”, resume un investigador citado en ese debate. Los datos proceden de informes recientes de la IEA, análisis del MIT y artículos revisados por pares publicados en Nature, que cruzan cifras de consumo real con proyecciones de despliegue de hardware.

El dato que más choca con nuestra intuición no viene de un servidor, sino de nuestra propia cabeza. El cerebro humano opera con una potencia estable de unos 20 W y, con esa energía, entre 80.000 y 100.000 millones de neuronas realizan tareas de percepción, memoria y decisión que todavía exigen enormes granjas de servidores cuando las replica la inteligencia artificial. Esa comparación deja algo muy claro: la inteligencia biológica es órdenes de magnitud más eficiente energéticamente que los sistemas digitales actuales.

También te puede interesar:Kai-Fu Lee Describe el Futuro de la Educación Frente a la IA y su Diagnóstico es más Duro de lo que Muchos EsperabanLa consecuencia estratégica de este contraste es evidente. El reto de la inteligencia artificial no consiste solo en disponer de más cómputo y más centros de datos, sino en lograr un cómputo radicalmente más eficiente. Mientras la IA necesite lo que equivale a una ciudad entera para hacer tareas que tú haces con 20 W, el hambre de energía seguirá creciendo. La industria promete nuevas generaciones de chips más eficientes, compresión de modelos y técnicas de sparsity para activar solo partes del modelo cuando hagan falta.

Todo esto ayuda, y la eficiencia por consulta mejora con cada generación de hardware y software. El problema es que la historia energética muestra un efecto rebote muy persistente: cuando se reduce el coste energético de una tarea, el uso total tiende a dispararse. Aplicado a la inteligencia artificial, abaratar las consultas puede llevar a que se hagan muchas más, que aparezcan nuevos casos de uso y que se integren modelos en cualquier aplicación, desde el correo hasta el coche.

Si eso ocurre sin mecanismos de gestión de la demanda, el consumo global seguirá aumentando de forma difícil de controlar. Mecanismos de gestión de la demanda significa priorizar cargas críticas (por ejemplo, sanidad o emergencias), desplazar el cómputo menos urgente a horas valle de la red y acercar parte del procesamiento al edge, es decir, más cerca del usuario final, en vez de centralizarlo todo en un hipercentro de datos. Son decisiones técnicas, pero también políticas y de negocio.

Cómo el consumo eléctrico de los data centers de IA puede condicionar tu factura y el clima

La otra mitad del problema es el suministro eléctrico necesario para sostener esta expansión de la inteligencia artificial. La IEA y varios análisis sectoriales coinciden en que, sin un fuerte aumento de la inversión en renovables firmes, como eólica y solar apoyadas en almacenamiento, y nuclear avanzada donde sea viable, la demanda de la IA puede tensionar las redes eléctricas. Eso se traduce en riesgo de precios altos, retrasos en conexiones y más dificultad para cerrar centrales fósiles.

También te puede interesar:Kai-Fu Lee Describe el Futuro de la Educación Frente a la IA y su Diagnóstico es más Duro de lo que Muchos EsperabanUn crecimiento desordenado de la demanda de IA puede elevar los precios eléctricos regionales y retrasar el cumplimiento de objetivos climáticos. No basta con plantar más paneles solares en el tejado del data center y dar el tema por resuelto. Harán falta carteras energéticas coherentes con la criticidad de estos grandes parques digitales, con contratos a largo plazo, almacenamiento capaz de cubrir periodos sin sol ni viento y, en algunos casos, apoyo nuclear.

Por eso el debate que se abre no gira solo en torno a disponer de más megavatios, sino de “mejores megavatios”. Es decir, energía procedente de contratos renovables firmes, almacenamiento bien dimensionado y, cuando encaje, nuclear avanzada. Si los nuevos parques de IA se alimentan con electricidad sucia o inestable, el coste climático y económico se dispara. Si se atan a fuentes limpias y estables desde el diseño, se reduce bastante el riesgo de que la inteligencia artificial choque con los objetivos climáticos.

El artículo plantea que la política pública suele llegar tarde cuando intenta regular sin datos suficientes. Para evitar repetir el mismo patrón con la inteligencia artificial, se proponen tres necesidades inmediatas. La primera es la transparencia: hacer obligatoria la publicación de la intensidad eléctrica e hídrica de cada centro de datos y de cada servicio de IA. Esa información podría expresarse, por ejemplo, en kWh y litros por cada 1.000 consultas a un modelo.

Sin métricas comparables, no hay forma de que exista una competencia sana ni una rendición de cuentas real en el sector de la IA y de los data centers. Por eso Nature y buena parte de la comunidad académica reclaman datos energéticos y de uso de agua que sean abiertos y verificables, de forma parecida a lo que ya pasa con otras industrias intensivas en recursos. Con esas métricas, tú podrías saber qué servicio de inteligencia artificial ofrece más valor por kWh y tomar decisiones informadas, y los reguladores podrían fijar límites claros.

La segunda necesidad que se plantea es la condicionalidad energética para autorizar nuevos “parques de IA”. La idea es que ningún proyecto de gran centro de datos salga adelante sin demostrar que tiene acceso a potencia firme que no va a desplazar la demanda residencial o industrial existente. Eso implicaría exigir contratos PPA de largo plazo con renovables y, cuando proceda, respaldo nuclear, antes de conceder permisos y conexiones prioritarias.

La propia IEA ya proyecta un gran salto en consumo, y corresponde a reguladores y empresas eléctricas evitar que ese salto derive en picos tarifarios o cuellos de botella en la red. Sin esa condicionalidad, el riesgo es que muchos parques de IA se conecten a redes ya tensas y acaben forzando inversiones de emergencia o subidas de tarifas para cubrir el nuevo pico de carga. El tejido industrial y los hogares serían los primeros en sentirlo.

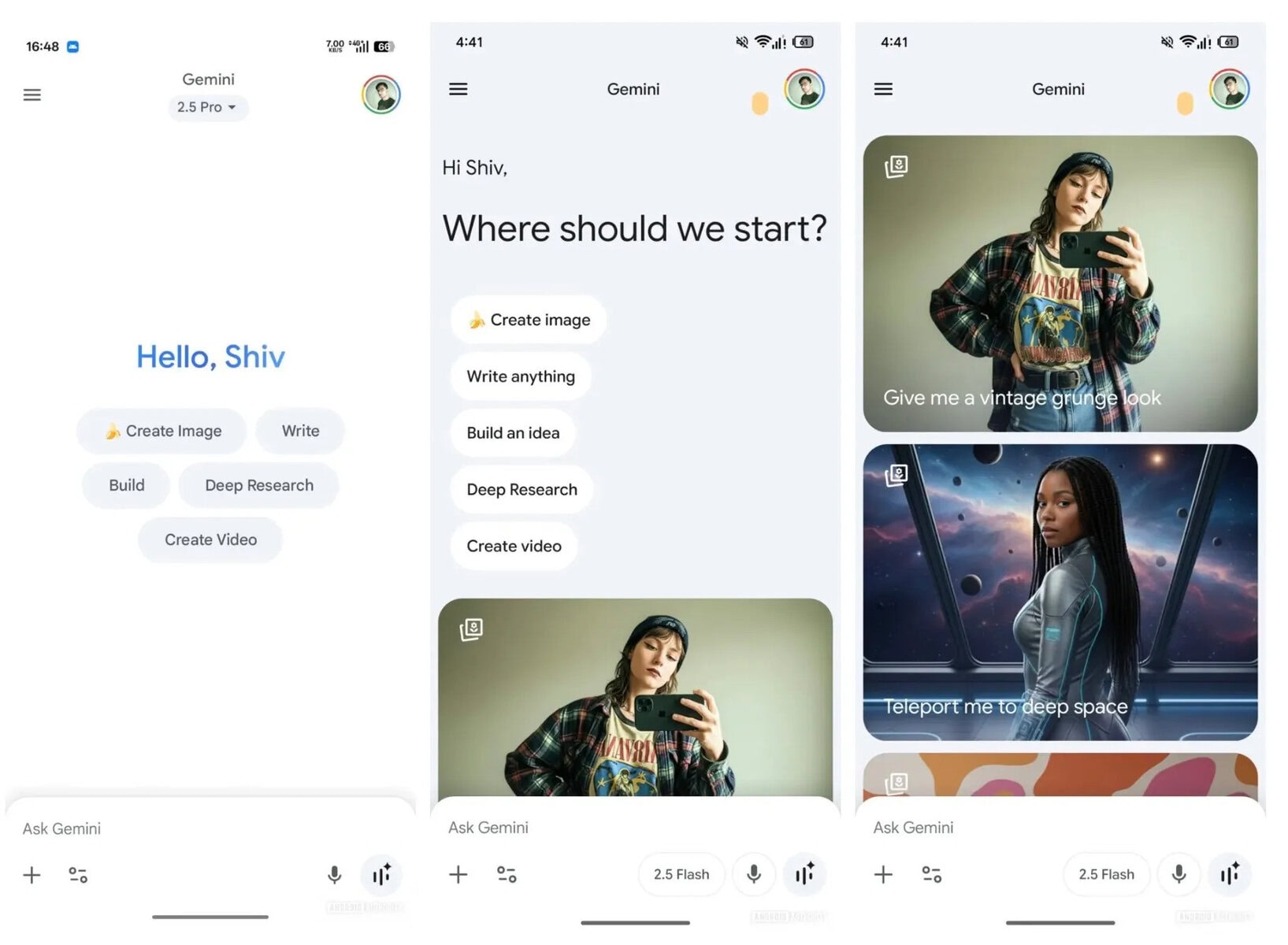

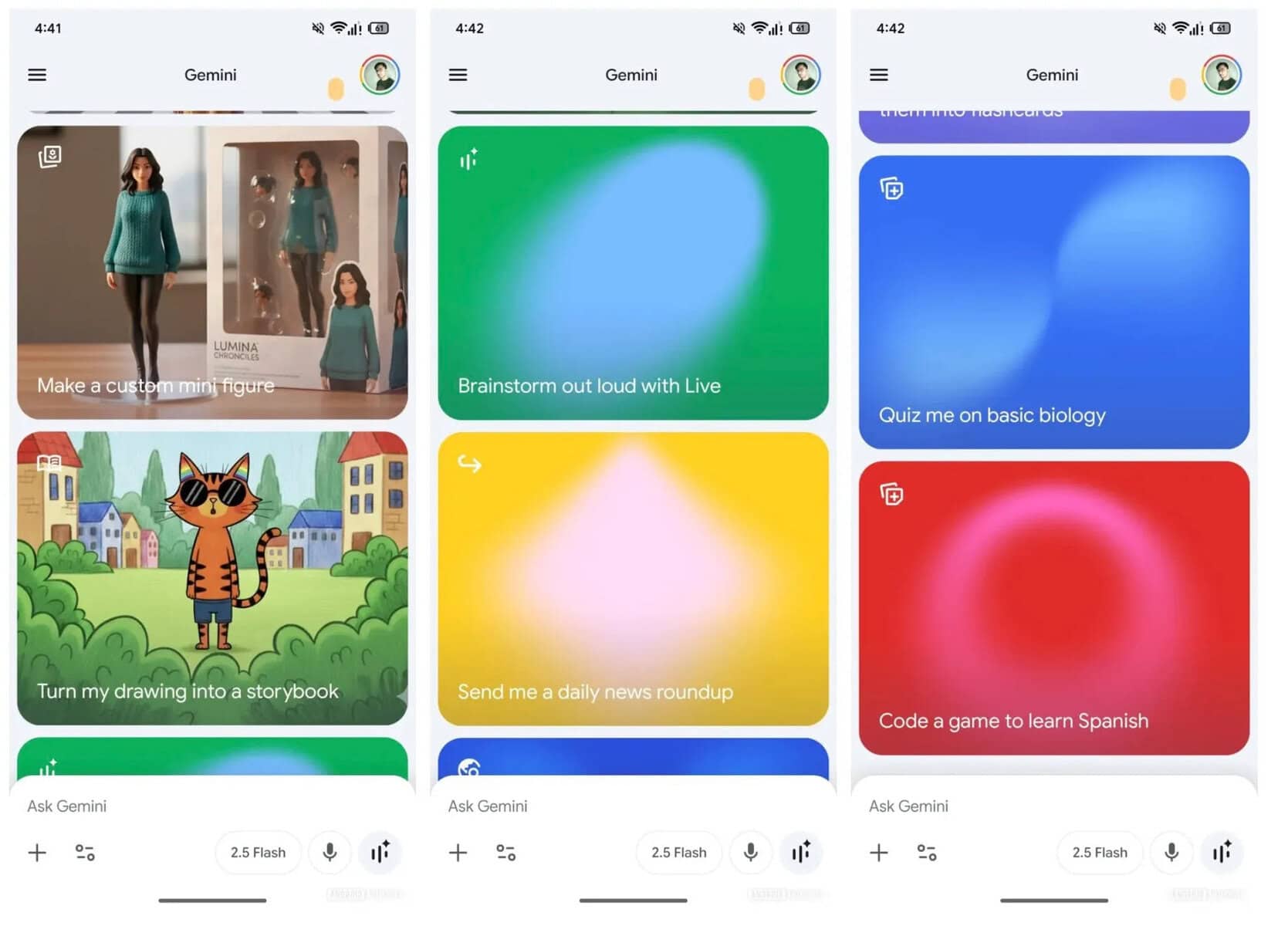

Cómo hacer que la eficiencia energética de la inteligencia artificial sea un requisito real y no solo marketing

La tercera palanca que se propone es convertir la eficiencia energética en un requisito explícito de los productos de IA. No basta con promesas generales sobre sostenibilidad en presentaciones comerciales. Los modelos y stacks de inteligencia artificial deberían publicar su intensidad energética por tipo de tarea: traducción, resumen, búsqueda, inferencia multimodal y cualquier otro uso relevante. Así podrías comparar, por ejemplo, cuánta energía gasta un asistente al resumir mil palabras frente a otro.

El MIT está impulsando marcos de “IA sostenible” que van justo en esa dirección. Incluyen planificación del uso de recursos con conciencia de carbono, sistemas de refrigeración inteligentes que ajustan su funcionamiento a la carga real y diseños de workload que minimizan el traslado innecesario de datos entre centros. Todo ese trabajo pretende que el estándar competitivo deje de ser solo “más parámetros” y pase a ser algo más exigente: ofrecer más valor por cada kWh gastado.

Creer que las futuras ganancias de eficiencia resolverán por sí solas el dilema energético de la inteligencia artificial se considera una postura de tecno-optimismo vacío. La escala de la IA generativa es tan grande que, incluso si cada consulta consume menos energía, el volumen total puede dispararse igual por la multiplicación de usos y usuarios. Por eso Nature insiste en que en la IA coexisten beneficios, riesgos y zonas de incertidumbre, y que la única salida responsable es medir, publicar y gobernar el fenómeno con calma pero sin esperar demasiado.

Si miramos hacia delante, el liderazgo en IA ya no se definirá solamente por quién tenga el modelo más grande o el chip más rápido. También contará quién gestione mejor la combinación de datos, algoritmos y energía. La primera palanca de ese liderazgo sería avanzar hacia una eficiencia inspirada en la biología, con neuroarquitecturas y cómputo neuromórfico que imiten parte del modo de trabajar del cerebro y acerquen a la industria a esos 20 W de referencia.

La segunda palanca sería disponer de carteras energéticas firmes y bien diseñadas para alimentar los centros de datos de IA, sin desplazar otros usos esenciales ni disparar emisiones. La tercera, una gobernanza de la demanda de cómputo basada en métricas públicas y verificables, que permita priorizar tareas, desplazar cargas en el tiempo y repartir de forma justa el acceso a la inteligencia artificial cuando haya límites físicos.

En cualquier caso, conviene no olvidar algo muy básico: la IA no “flota” en una nube abstracta. Depende de cables, redes, turbinas y, en algunos casos, reactores. Mientras sigamos persiguiendo inteligencias artificiales avanzadas, tiene sentido recordar que la inteligencia humana logra capacidades extraordinarias con solo 20 W de consumo continuo. Ese es el listón de eficiencia que marca tu propio cerebro, y el gran desafío de la industria de la inteligencia artificial será acercarse todo lo posible a ese nivel sin desbordar la red eléctrica ni el clima.

Directora de operaciones en GptZone. IT, especializada en inteligencia artificial. Me apasiona el desarrollo de soluciones tecnológicas y disfruto compartiendo mi conocimiento a través de contenido educativo. Desde GptZone, mi enfoque está en ayudar a empresas y profesionales a integrar la IA en sus procesos de forma accesible y práctica, siempre buscando simplificar lo complejo para que cualquiera pueda aprovechar el potencial de la tecnología.