El auge de los modelos de lenguaje ha revolucionado sectores enteros, desde la automatización empresarial hasta la investigación científica. DeepSeek-V3, un modelo de lenguaje abierto y accesible, no solo rivaliza con gigantes como GPT-4, sino que los supera en rendimiento, eficiencia y accesibilidad tecnológica. En este artículo, exploraremos cómo su diseño innovador y su arquitectura avanzada están redefiniendo los estándares de la inteligencia artificial.

DeepSeek-V3 es un modelo de lenguaje desarrollado con un enfoque en la accesibilidad, eficiencia y rendimiento. Su diseño utiliza una arquitectura basada en Mixture-of-Experts (MoE), una técnica que distribuye las cargas de procesamiento entre expertos especializados. Esto permite activar solo un subconjunto de parámetros para cada tarea, logrando así un uso eficiente de los recursos.

El modelo cuenta con:

Una de las características más destacadas de DeepSeek-V3 es su implementación de atención Multi-head Latent Attention (MLA), que mejora la capacidad del modelo para procesar secuencias largas y contextos complejos. Esto lo hace especialmente eficaz en:

El uso de la arquitectura MoE elimina la necesidad de pérdidas auxiliares, algo que suele ser común en otros modelos. Este diseño simplificado contribuye a una mejor asignación de recursos y una mayor precisión en resultados finales.

El proceso de entrenamiento es otro factor diferenciador de DeepSeek-V3. Gracias al uso de la tecnología FP8 (floating-point 8-bit), se reducen significativamente los costos computacionales y energéticos. Esto se traduce en:

Con una longitud de contexto de hasta 128K tokens, DeepSeek-V3 sobresale en tareas de procesamiento de texto extenso, como la comprensión de documentos legales o la traducción de textos técnicos.

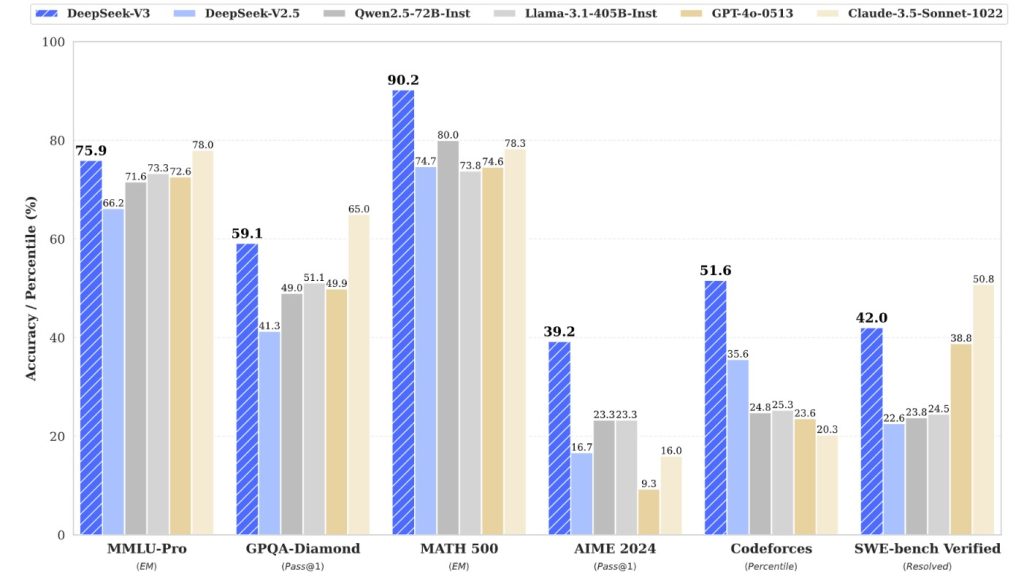

Los resultados de DeepSeek-V3 en benchmarks como MMLU (Massive Multitask Language Understanding) y HumanEval son sorprendentes. El modelo alcanza:

La capacidad del modelo para realizar predicción de múltiples tokens lo posiciona como una opción ideal para tareas donde la velocidad de inferencia es crítica, como sistemas de recomendación y asistentes virtuales.

DeepSeek-V3 está diseñado para ser una solución versátil en diversos sectores. Algunos de los casos de uso más relevantes incluyen:

La accesibilidad es un pilar fundamental de DeepSeek-V3. El modelo es compatible con:

Para quienes buscan explorar más sobre DeepSeek-V3, es posible visitar su repositorio en GitHub o descargarlo desde su perfil en Hugging Face.

El modelo DeepSeek-V3 no solo se destaca por sus avances tecnológicos, sino también por su compromiso con la comunidad de IA abierta. Con una licencia de uso comercial, promueve la innovación en sectores donde los costos y las barreras tecnológicas solían limitar el acceso.

Además, su colaboración con plataformas líderes asegura un ecosistema robusto de soporte, actualizaciones y herramientas complementarias, lo que beneficia tanto a desarrolladores como a empresas.

Me dedico al SEO y la monetización con proyectos propios desde 2019. Un friki de las nuevas tecnologías desde que tengo uso de razón.

Estoy loco por la Inteligencia Artificial y la automatización.