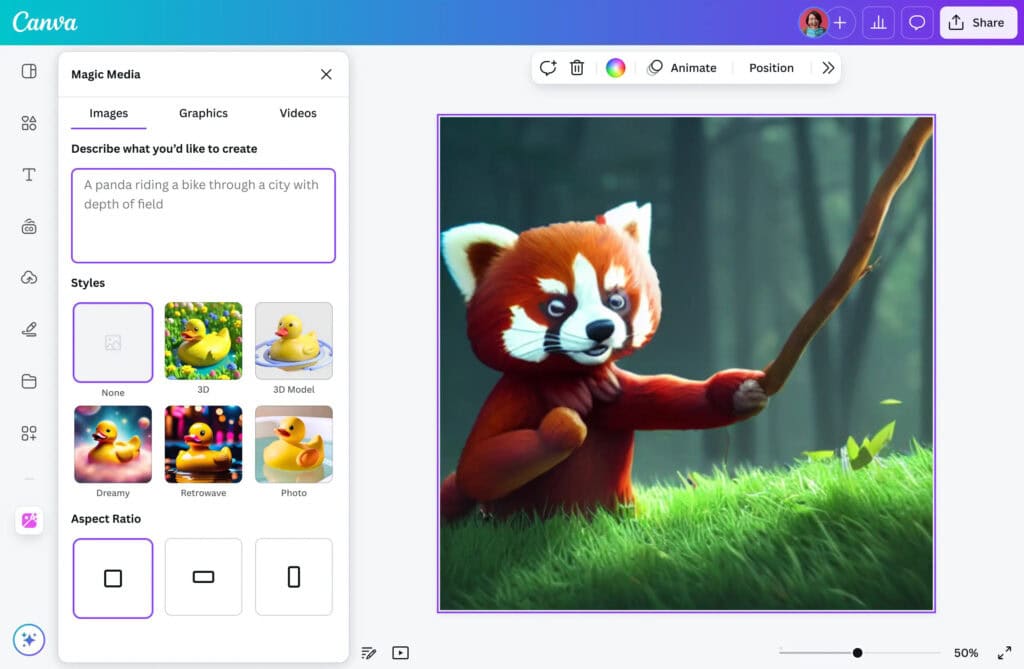

Las herramientas que usas para crear imágenes con IA, como DALL-E, Imagen o Stable Diffusion, funcionan con modelos de difusión. Están diseñados para copiar lo que vieron, y aun así producen imágenes nuevas y coherentes. Aquí está la parte importante: un equipo de Stanford dice que no es magia ni azar, y que hay un patrón técnico detrás. Falta un detalle clave que cambia cómo lo entendemos.

El físico Mason Kamb, junto con Surya Ganguli en la Universidad de Stanford, presentó en ICML 2025 una teoría matemática que explica esa “creatividad” inesperada.

Habla de cómo estos modelos de difusión eliminan ruido y reconstruyen imágenes, pero con un giro: ciertas reglas internas, consideradas limitaciones durante años, serían justo lo que dispara la novedad. Vamos paso a paso, porque el argumento tiene su trampa.

En las imágenes de entrenamiento, el sistema añade ruido hasta convertirlas en un borrón y luego intenta revertir el proceso. Ese ciclo se llama “eliminación de ruido”. Si todo fuera perfecto, memorizaría y ya está. Giulio Biroli lo resume con un dardo: si funcionaran “demasiado bien”, solo copiarían. Generan objetos inéditos y con sentido. ¿De dónde sale lo nuevo?

La pista vino de la biología. Kamb se inspiró en los patrones de Turing, que explican cómo las células se autoorganizan sin jefe central y a veces cometen rarezas, como dedos extra. Te suena, ¿verdad? Las primeras imágenes con IA mostraban manos con más dedos de la cuenta. Mismo tipo de error: ensamblajes locales que no “ven” el conjunto completo.

La “localidad” implica que el sistema trabaja por parches de píxeles, como si mirara la imagen con una lupa y trozos aislados. La “equivarianza traslacional” asegura que, si desplazas la entrada unos píxeles, la salida se desplaza igual, lo que mantiene cierta coherencia. Durante años se vieron como límites técnicos. Con todo, Kamb plantea que justo esas dos reglas son el motor de la novedad.

También te puede interesar:xAI Lanza una Nueva API de Generación de ImágenesPara ponerlo a prueba, diseñaron la “máquina de puntuación local equivariante” (ELS), no un generador entrenado, sino un sistema de ecuaciones que replica el comportamiento usando solo localidad y equivarianza.

ELS igualó los resultados de modelos de difusión reales con un 90 % de precisión media, algo muy raro en aprendizaje automático. “Lo potente es que ofrece predicciones cuantitativas sobre dónde y cuándo emerge la novedad”, destaca Luca Ambrogioni.

La clave está en la eliminación de ruido. Cada parche intenta “arreglar” su trozo sin conocer el todo. Las pequeñas imperfecciones técnicas en ese proceso mezclan texturas, bordes y patrones vecinos. La equivarianza hace que esos arreglos locales se propaguen con coherencia espacial.

Y de esa interacción, según Kamb y Ganguli, surge la novedad semántica que ves en las salidas de los modelos de difusión.

¿Cómo lo comprobaron sin salir del laboratorio? Compararon ELS con salidas de DALL-E, Imagen y Stable Diffusion en conjuntos de evaluación internos y públicos, reportados en la Conferencia Internacional sobre Aprendizaje Automático 2025. La comunidad, con voces como Biroli o Benjamin Hoover, revisó los argumentos y las curvas de ajuste. Piden prudencia: el 90 % es una media y hay casos límite que todavía se escapan.

Durante mucho tiempo se asumió que localidad y equivarianza eran peajes técnicos. Esta teoría les da la vuelta: serían el germen de la creatividad en imágenes. Los modelos de difusión no “inventan”, ensamblan piezas conocidas de forma nueva. Y eso conecta con nosotros.

También te puede interesar:ChatGPT Actualiza su Modelo de Generación de Imágenes en Gpt-4oHoover sugiere que tanto humanos como IA completamos huecos con una comprensión incompleta del mundo, y ahí aparece la novedad.

No lo extrapoles a todo. Los grandes modelos de lenguaje parecen lograr creatividad por caminos distintos, más ligados a predicción secuencial y memoria distribuida. Biroli lo remarca: esta es solo una parte de la historia. Si buscas explicaciones únicas para toda la IA, te vas a frustrar.

En cualquier caso, te quedas con una idea fuerte: en imagen, la creatividad de la IA no es un truco misterioso. Es lo que pasa cuando parche local y coherencia espacial tiran juntos del proceso de eliminación de ruido. Ese marco también abre una ventana para estudiar la creatividad humana con reglas medibles. Y eso, por fin, nos da un mapa para perderse menos y crear mejor.

Me dedico al SEO y la monetización con proyectos propios desde 2019. Un friki de las nuevas tecnologías desde que tengo uso de razón.

Estoy loco por la Inteligencia Artificial y la automatización.