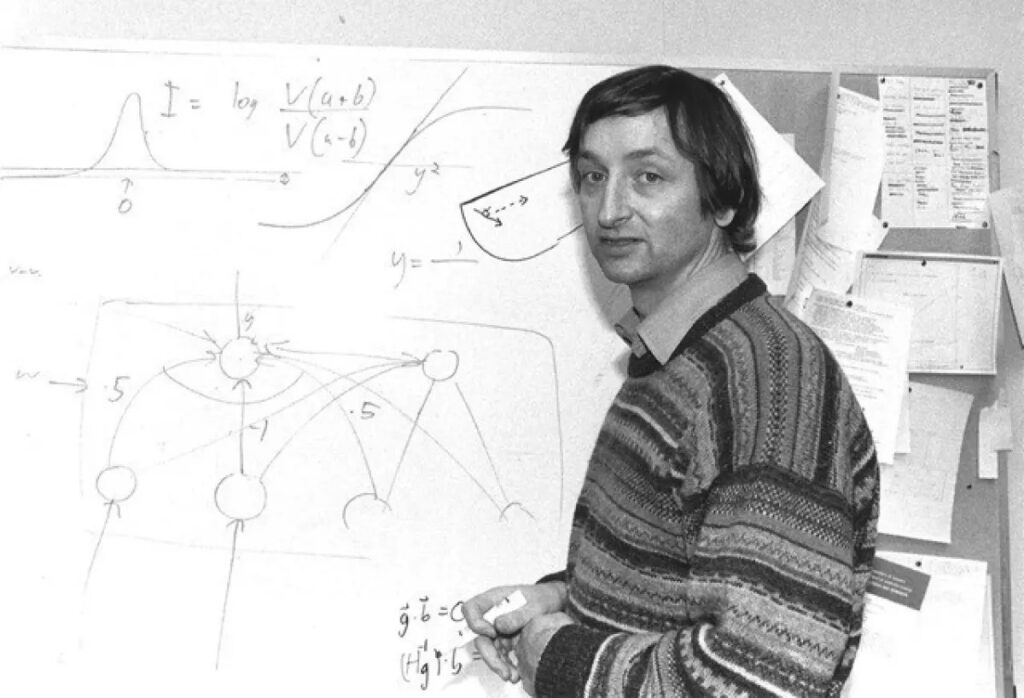

En Silicon Valley, una parte influyente habla de inteligencia artificial como si fuera una fe nueva, con promesas, temores y profetas propios. El “padrino” Geoffrey Hinton, que dejó Google en 2023, avisa de peligros reales si no hay reglas.

Hinton impulsó el aprendizaje profundo y las redes neuronales que hoy usa la inteligencia artificial moderna. Tras salir de Google, dice sentir “cierta responsabilidad” y ha empezado una campaña pública para pedir regulación, incluso admitiendo que la IA “realmente es como un dios”. Altman habla de “una inteligencia mágica en el cielo”, y Peter Thiel sugiere que podría traer al Anticristo.

Dario Amodei, CEO de Anthropic, imagina que, si sale bien, la inteligencia artificial pondrá fin a buena parte de las enfermedades, ampliará tu libertad biológica y cognitiva, y sacará a millones de la pobreza. Otros hablan de “apocalipsis tecnológico” o de una nueva etapa evolutiva. El término “apocalipsis”, por cierto, antes significaba revelación y esperanza, no fin del mundo.

Ray Kurzweil, referente del transhumanismo, pronostica que en 2045 nos fusionaremos con la tecnología y multiplicaremos la inteligencia humana un millón de veces, y admite que para él la inteligencia artificial funciona casi como una religión personal. Es una visión que inspira a algunos y preocupa a otros por su tono profético. Aquí vuelve la pregunta: ¿creencia útil o expectativa que distorsiona decisiones?

La verificación es sencilla en lo factual: la salida de Hinton de Google en 2023, sus entrevistas, la carta abierta de 2023 con 33.000 firmas y las declaraciones públicas de Altman, Thiel y Kurzweil son datos rastreables. El debate no es si lo dijeron, sino cómo interpretar su alcance y con qué garantías.

Cuando llamas “religión” a la inteligencia artificial, señalas tres cosas: promesas de salvación tecnológica, advertencias de castigo por “jugar a ser dioses”, y rituales de fe en plazos y gráficos. Tegmark resume el límite con una frase breve:

También te puede interesar:Hackers con IA: la Amenaza que Crece más Rápido de lo Que las Empresas pueden DetenerMax Tegmark: "El soporte científico para una IA ‘como dios’ no supera al de la vida después de la muerte."

Para ti, esto implica mirar con lupa qué es demostrable hoy y qué sigue siendo aspiración. Regular no es frenar por frenar: es orientar.

Hinton insiste en que una inteligencia artificial sin regulaciones puede volverse incontrolable, y Tegmark cree que la carta de 2023 normalizó hablar de seguridad aunque queda trabajo por hacer. Regular la inteligencia artificial no significa frenarla, sino hacerla útil para curar enfermedades, mejorar productividad y proteger derechos. El matiz está en el cómo y en quién rinde cuentas.

En cualquier caso, la pregunta que abre este debate sigue vigente: ¿es la inteligencia artificial una nueva religión de Silicon Valley o una herramienta potente que exige reglas claras? La respuesta práctica pasa por evaluar riesgos reales, frenar el lenguaje milagroso cuando toque y exigir pruebas medibles de utilidad social. Ahí es donde de verdad te juegas el valor de la inteligencia artificial que usas cada día.

También te puede interesar:Uruguay Firma con Europa el Primer Convenio Regional de Latinoamérica para Regular la IA

Directora de operaciones en GptZone. IT, especializada en inteligencia artificial. Me apasiona el desarrollo de soluciones tecnológicas y disfruto compartiendo mi conocimiento a través de contenido educativo. Desde GptZone, mi enfoque está en ayudar a empresas y profesionales a integrar la IA en sus procesos de forma accesible y práctica, siempre buscando simplificar lo complejo para que cualquiera pueda aprovechar el potencial de la tecnología.