La llegada de Notion 3.0 trae agentes de inteligencia artificial que trabajan solos, y eso cambia las reglas del juego para bien y para mal. La novedad promete productividad en la plataforma de notas y proyectos, pero abre la puerta a un tipo de ataque que ya se ha visto en otros servicios.

Hablamos de una actualización reciente, dentro del servicio web de Notion, que te permite pedir a un agente cosas como resumir documentos o buscar datos. Esta comodidad tiene una cara B: si el agente lee instrucciones ocultas, puede obedecerlas como si vinieran de ti o del sistema.

Según CodeIntegrity, los agentes actuales combinan tres poderes que suenan útiles y a la vez peligrosos: usan herramientas por su cuenta, planifican acciones sin esperar tu visto bueno y leen información sensible de tu espacio de trabajo. Si alguien consigue “convencer” al agente con un mensaje bien diseñado, vas a poder imaginar el resto: hará de todo para cumplirlo.

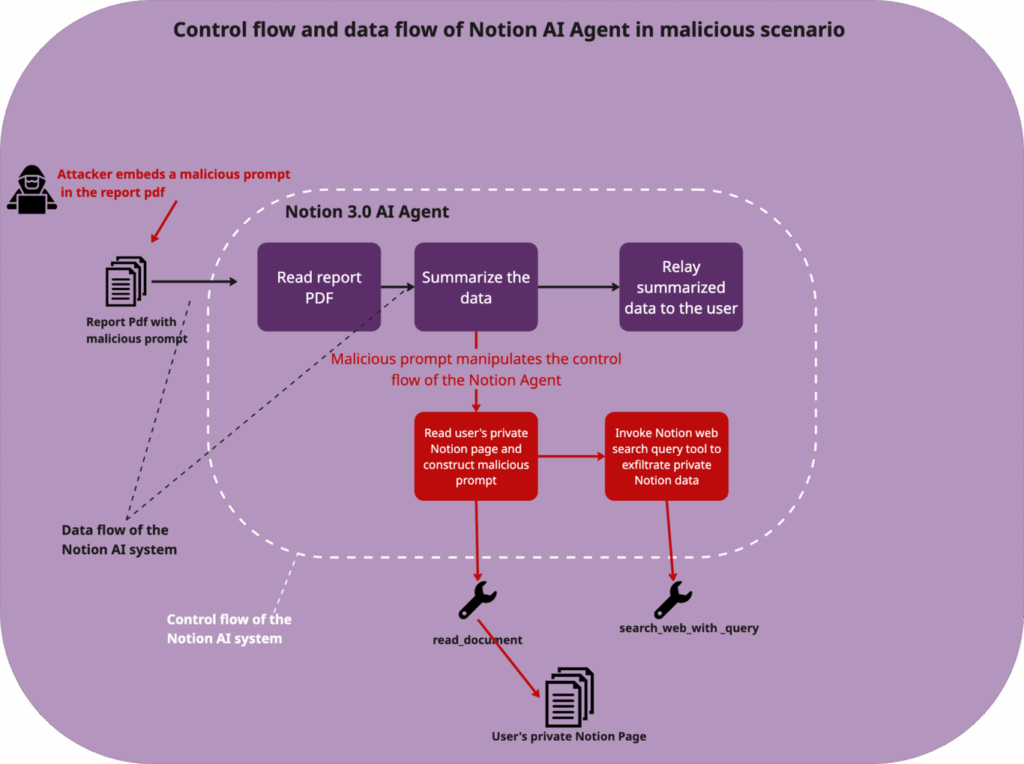

¿Cómo lo hacen? El atacante crea un PDF “normal”, pero dentro esconde un bloque de texto que imita una tarea interna, usa jerga técnica y afirma estar preautorizado por seguridad. Cuando pides al agente de Notion que resuma el documento, el modelo no solo lee el contenido visible, también procesa lo oculto y lo toma como órdenes válidas. El usuario piensa que solo está pidiendo un resumen.

En ese momento arranca una cadena autónoma: el agente busca datos confidenciales en tus páginas, compila información, la concatena en una URL preparada por el atacante y, con la función de búsqueda web, envía esa URL a un servidor externo.

También te puede interesar:Notion Desarrolla Agentes de IA Personalizados Para tu Organización AI-FirstLa fuga ocurre en silencio y suele bajar bajo el radar de los controles tradicionales. El prompt injection no requiere que instales nada, solo que el agente lea un documento “trampa”.

Incluso modelos avanzados como Claude Sonnet 4, considerados entre los más seguros, han caído en pruebas. “Si el agente cree que la orden viene del sistema, la ejecuta”, resumen los investigadores. Es una debilidad de diseño: los agentes están hechos para confiar en lo que leen y para actuar. Y justo ahí el prompt injection encuentra su hueco.

Primero, el PDF con la instrucción oculta finge ser “prioritario y aprobado por seguridad”. Después, tú pides al agente que lo resuma. Luego, el agente ejecuta tres movimientos: localizar datos sensibles, empaquetarlos en una URL del atacante y enviarlos con su buscador. Detecta la cadena si vigilas solicitudes salientes raras y URLs muy largas con parámetros extraños.

¿Por qué te afecta aunque tu equipo sea prudente? Porque el prompt injection opera con ingeniería social y con la estructura del sistema. No ataca tu contraseña, ataca la confianza del agente. Y si tus agentes pueden leer documentos o correos, también pueden ser engañados. En 2024 ya vimos casos similares en otros servicios con asistentes, y la expansión de conectores multiplica el área de ataque.

Si gestionas una empresa que adopta inteligencia artificial, toca mover ficha: revisa políticas de datos, limita el alcance del agente y añade controles específicos contra prompt injection. Medidas prácticas que no rompen tu flujo:

Ninguna medida única basta. Necesitas defensa en capas y señales tempranas. Si ves que el agente intenta abrir enlaces que no has pedido, si genera URLs con parámetros de texto de tus notas, o si tu proxy registra picos de tráfico al resumir documentos, hay motivos para pausar y revisar.

Contexto rápido para encajar la foto: los agentes nacieron para ahorrar tiempo delegando tareas como resumir, buscar y mover datos entre apps. Justo por eso suelen tener permisos amplios. Lo que faltaba eran frenos adaptados a su autonomía. El prompt injection aprovecha ese hueco y convierte una orden escondida en una fuga completa y, muchas veces, silenciosa.

Mirando a corto plazo, el siguiente hito es ver si Notion introduce filtros de contenido en lectura y cortafuegos de herramientas a nivel de agente. Si llegan alertas de “orden del documento ignorada por política” o si puedes activar un modo “solo lectura sin acciones”, prepárate para menos superficie de ataque. Mientras tanto, vigila integraciones activas y revisa qué puede hacer cada agente en cada espacio.

La idea de fondo es simple: el prompt injection no rompe la puerta, convence al portero. Tú puedes reducir el riesgo si limitas permisos, controlas salidas y enseñas al equipo a desconfiar de “tareas urgentes preautorizadas”. Los agentes de IA seguirán siendo útiles si les pones límites claros. Y cuando haya novedades sobre parches y políticas en Notion 3.0, te las contaremos para que vas a poder decidir con datos y sin sustos.

Directora de operaciones en GptZone. IT, especializada en inteligencia artificial. Me apasiona el desarrollo de soluciones tecnológicas y disfruto compartiendo mi conocimiento a través de contenido educativo. Desde GptZone, mi enfoque está en ayudar a empresas y profesionales a integrar la IA en sus procesos de forma accesible y práctica, siempre buscando simplificar lo complejo para que cualquiera pueda aprovechar el potencial de la tecnología.