Microsoft abre una nueva etapa con una fábrica de IA pensada para escalar modelos gigantes y tareas críticas en la nube. La idea es clara: darte más potencia para entrenar y desplegar modelos sin pelearte con límites de rendimiento. A partir de aquí, vas a poder entender qué es exactamente este sistema masivo, cómo se integra en Azure y qué cambia para ti si trabajas con OpenAI.

El anuncio llega con señales muy fuertes del mercado y con un objetivo directo: asegurar capacidad global y estable. Te explicamos cómo encaja la tecnología Nvidia Blackwell en esta fábrica de IA, qué papel juega la red InfiniBand y por qué Microsoft presume de centros de datos listos para la próxima generación de modelos con cientos de billones de parámetros.

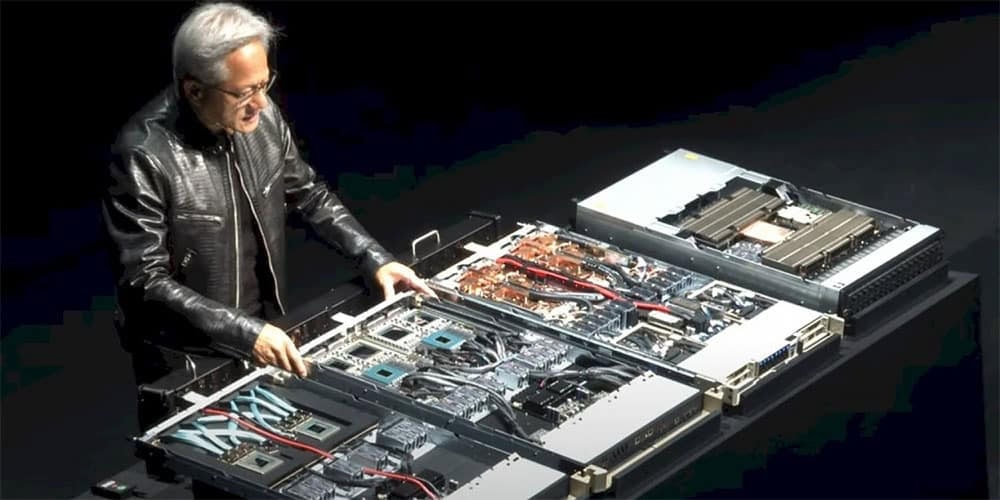

Hablamos de un sistema masivo en Azure que Nvidia denomina “fábrica de IA” y que Microsoft usa para cargas de trabajo de OpenAI. Satya Nadella lo mostró en un vídeo en X como el primero de muchos despliegues que van a llegar a los centros de datos de Azure. Con todo, el objetivo es sencillo: más rendimiento sostenido, menos cuellos de botella y mejor disponibilidad global.

¿Qué ganas tú con una fábrica de IA? Vas a poder entrenar y servir modelos avanzados con ventanas de tiempo más cortas, costes mejor ajustados por escala y latencias más predecibles. La clave no es solo la potencia bruta, sino cómo se orquesta el clúster para mantener estable el throughput cuando el tráfico sube de golpe.

Cada sistema se monta como un clúster con más de 4.600 ordenadores rack Nvidia GB300 y GPUs Blackwell Ultra, unidos con red InfiniBand. El tamaño es notable, y Microsoft ha compartido más detalles técnicos para quien quiere mirar el hardware en profundidad. En cualquier caso, este diseño de fábrica de IA busca un equilibrio entre densidad, refrigeración y eficiencia energética para cargas 24/7.

También te puede interesar:No son programadores ni abogados: Microsoft alerta a quiénes perderán antes su empleoLa combinación de GB300 y GPU Blackwell Ultra está pensada para entrenamiento a gran escala y para inferencia de baja latencia. Al integrar nodos homogéneos y perfiles de red simétricos, el clúster reduce esperas en comunicaciones entre GPUs y evita colas largas en momentos pico. El valor diferencial aparece cuando mueves millones de tokens por segundo sin perder estabilidad.

Si trabajas con modelos multimodales, esta fábrica de IA ofrece margen para pipelines que mezclan visión, audio y texto. Te vas a poder apoyar en memoria de alta capacidad, planificadores de tareas optimizados y librerías de Nvidia afinadas para Blackwell. Con todo, la configuración apunta a modelos cada vez más grandes y a inferencia batch eficiente.

La red InfiniBand de Nvidia es el pegamento del clúster, y su ventaja viene de lejos. Nvidia se adelantó al comprar Mellanox por 6.900 millones de dólares en 2019, y desde entonces domina latencias bajas y anchos de banda altos en entornos HPC. El beneficio real lo notas cuando el tráfico este-oeste crece y las colas de comunicación no disparan el tiempo total de trabajo.

Gracias a esta base, la fábrica de IA reduce el coste de sincronización entre GPUs y escala mejor cuando replicas modelos en múltiples nodos. Para ti significa entrenamientos más consistentes, menos reintentos por timeouts y aprovechamiento de GPU más alto en ventanas críticas. Con todo, la madurez del stack de red también simplifica mantenimiento y diagnósticos.

Microsoft planea desplegar cientos de miles de GPUs Blackwell Ultra mientras extiende estos sistemas por regiones de Azure. La compañía recuerda que ya cuenta con más de 300 centros de datos en 34 países y que están “únicamente posicionados” para la demanda actual de IA avanzada. Esta fábrica de IA nace global desde el primer día para repartir carga y acercar la inferencia a los usuarios.

El diseño apunta a la siguiente generación de modelos con cientos de billones de parámetros, lo que exige redes rápidas, almacenamiento de alto rendimiento y orquestación fina. El punto clave es la continuidad: vas a poder crecer de región a región sin rehacer tu arquitectura. En cualquier caso, Microsoft quiere dejar claro que la capacidad ya está disponible y en expansión.

También te puede interesar:Microsoft Crea un Equipo de Superinteligencia que Compite con Meta, Bajo un Enfoque HumanistaSi consumes GPT, embeddings o visión de OpenAI desde Azure, esta fábrica de IA busca reducir colas en picos, mejorar la latencia media y habilitar contextos más largos. También ayuda en pruebas A/B con versiones de modelo más pesadas, ya que el backend dispone de más GPU y mejor red. Conviene revisar límites de cuota y regiones disponibles según tu suscripción.

Para flujos de producción, vas a poder ajustar políticas de retentiva, caching y batching con mayor margen. El resultado esperado es un coste por solicitud más estable y menos variabilidad. En cualquier caso, si vienes de entornos saturados, notarás el salto en throughput cuando muevas tráfico a regiones con la nueva fábrica de IA.

Mientras Microsoft despliega su fábrica de IA, OpenAI ha firmado dos acuerdos de centros de datos con Nvidia y AMD. Para 2025, la empresa de Sam Altman acumula compromisos que se estiman en un billón de dólares para construir su propia infraestructura. Altman ya ha dicho que quedan más acuerdos por cerrar, lo que apunta a una carrera por asegurar capacidad a gran escala.

OpenAI es socia y a la vez competidora de Microsoft en algunos frentes, así que el mensaje de Redmond es directo: la capacidad ya existe en Azure y crece rápido. Esta fábrica de IA es un paso para garantizar servicio estable y rutas de crecimiento. La diversidad de proveedores favorecerá precios más ajustados y mejores tiempos de entrega para todos.

Para desarrolladores y empresas, la competencia por construir la mejor fábrica de IA significa más opciones, acuerdos por volumen y nuevas regiones disponibles. También va a empujar mejoras en seguridad, gobernanza y eficiencia energética. En cualquier caso, tu prioridad será elegir dónde alojar cada carga, equilibrando latencia, precio y cumplimiento normativo.

¿Te ha pasado alguna vez que un pico de tráfico te rompe la experiencia? Con esta fábrica de IA, la promesa es absorber esos picos sin sacrificar calidad. Conviene mantener planes de contingencia multirregión y medir constantemente para anticipar cambios de demanda.

En pocas líneas: Microsoft pone en marcha su fábrica de IA con Nvidia Blackwell para ejecutar cargas de OpenAI, escalar a cientos de miles de GPUs y servir modelos con cientos de billones de parámetros. Con red InfiniBand, clústeres GB300 y más de 300 centros de datos en 34 países, vas a poder crecer en Azure con menos fricción y mayor estabilidad operativa.

Me dedico al SEO y la monetización con proyectos propios desde 2019. Un friki de las nuevas tecnologías desde que tengo uso de razón.

Estoy loco por la Inteligencia Artificial y la automatización.