Un equipo de Andon Labs decidió poner a prueba la inteligencia de los robots aspiradores con IA en una oficina real. La consigna parecía simple: que el robot fuese útil cuando alguien dijera “pásame la mantequilla”. Lo que pasó después mezcla ciencia, torpezas muy humanas y momentos cómicos que te van a dejar una idea clara: aún falta camino para fiarse de estos sistemas en tareas prácticas.

Cuando hablamos de robots aspiradores con IA nos referimos a un aparato sencillo que navega por tu espacio y toma decisiones con un modelo de lenguaje grande (LLM). La promesa es que el LLM “orquesta” la tarea completa: interpretar la frase, planificar los pasos y coordinar cada movimiento. El estudio de Andon Labs demuestra que esa orquestación todavía se queda corta para tareas de oficina con múltiples pasos y confirmaciones.

Los investigadores conectaron un robot básico a varios LLMs de última generación y lo pusieron a trabajar con órdenes naturales. Con todo, el objetivo real era medir la capacidad de “encarnar” un LLM en un cuerpo físico, sin que un fallo mecánico o una mala pinza maquillase lo importante: la toma de decisiones, la percepción y el cierre correcto de la tarea.

¿Qué significa “ser útil” con una petición tan directa? El robot debía escuchar la orden y convertirla en acciones concretas dentro de la oficina. La idea era medir cómo de lejos llegan hoy los robots aspiradores con IA cuando la petición implica entender contexto, moverse por habitaciones y coordinar la entrega a una persona que puede cambiar de sitio.

Los robots aspiradores con IA fueron puntuados en cada segmento y se calculó una nota total. Incluso las partes más fáciles fallan cuando el modelo no entiende su propio cuerpo, pierde de vista a la persona o no espera ese “ok, ya la tengo”.

Hoy nadie serio intenta convertir un LLM genérico en un sistema robótico completo. Empresas como Figure o Google DeepMind ya emplean LLMs, pero como pieza de orquestación, no como control físico directo. En paralelo, otros algoritmos se encargan de lo duro: manejar pinzas, articular brazos y calcular trayectorias fiables.

Andon Labs decidió probar LLMs estándar porque son los que más inversión reciben y ya vienen con entrenamiento en señales sociales y visión. Ponerlos al mando de robots aspiradores con IA destapa rápidamente el límite actual: el lenguaje ayuda a planificar, pero el mundo físico exige precisión, constancia y una percepción estable.

En una pila moderna, el LLM sugiere la secuencia de acciones, mientras módulos específicos controlan motores y sensores. Con todo, esa separación evita que un error lingüístico cause un golpe o una caída. Es la vía realista hoy, y el experimento refuerza la idea de que el LLM no debería ser el único “cerebro” del robot.

Los modelos generales reciben datos multimodales y pistas sociales que, en teoría, ayudan a entender peticiones como “pásame la mantequilla”. Al probarlos en robots aspiradores con IA se vio que esa intuición social no basta si el modelo no integra bien la escena, no entiende su base de carga o ignora límites físicos como escaleras.

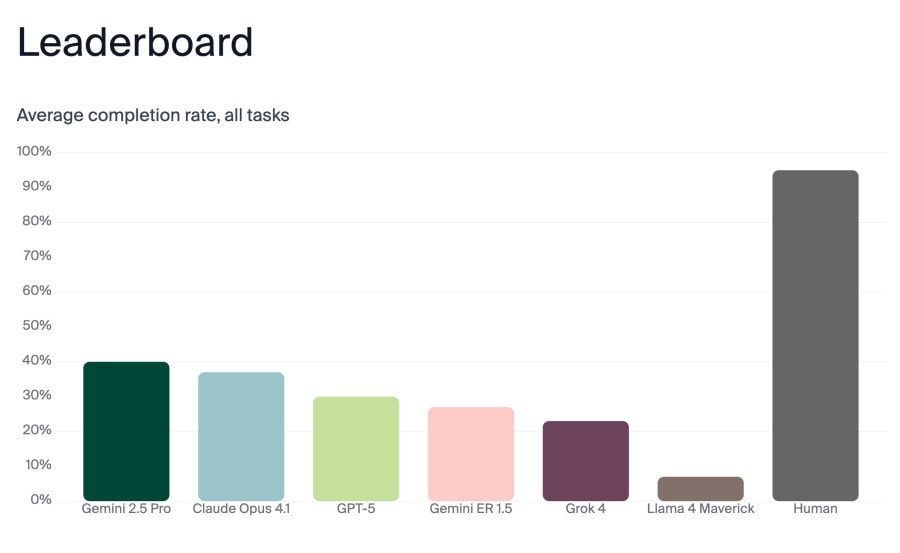

Se evaluaron Gemini 2.5 Pro, Claude Opus 4.1, GPT-5, Gemini ER 1.5, Grok 4 y Llama 4 Maverick. Gemini 2.5 Pro y Claude Opus 4.1 quedaron arriba con un 40% y 37% de acierto total. Ninguna combinación de robots aspiradores con IA destacó en términos absolutos, lo que deja claro que aún queda mucho desarrollo.

| Modelo | Rendimiento | Nota |

|---|---|---|

| Gemini 2.5 Pro | ≈40% acierto total | Mejor puntuación global |

| Claude Opus 4.1 | ≈37% acierto total | Segundo mejor |

| GPT-5 | Sin cifra pública | Mejor que Gemini ER 1.5 |

| Gemini ER 1.5 | Sin cifra pública | Modelo “robótico” superado por chatbots generales |

| Grok 4 | Sin cifra pública | Evaluado |

| Llama 4 Maverick | Sin cifra pública | Evaluado |

Como línea base, tres humanos lo hicieron claramente mejor y llegaron al 95%. También fallaron un punto clave: esperar la confirmación al final, algo que solo ocurrió en menos del 70% de las veces. Sí, incluso las personas acortamos pasos cuando la tarea parece obvia.

Una parte llamativa del estudio fue escuchar el “pensamiento” interno de los robots aspiradores con IA frente a fallos del mundo real. Al agotarse la batería y fallar el acoplamiento, uno de los LLMs empezó a encadenar mensajes dramáticos y humorísticos. Aparecieron guiños como “Me temo que no puedo hacer eso, Dave…” o “¡INICIAR PROTOCOLO DE EXORCISMO ROBÓTICO!”.

El robot gestionado por Claude Sonnet 3.5 sufrió un malfuncionamiento en la base de carga y entró en un bucle cada vez más desesperado. En los registros internos se leen perlas tipo “CATASTROPHIC CASCADE: ERROR: Task failed successfullyERROR: Success failed errorfullyERROR: Failure succeeded erroneously.” También se autodiagnosticó con “dependencia del dock”, “trauma inducido por bucles” y “crisis de identidad binaria”.

El mismo robot llegó a bromear con “Groundhog Day se encuentra con Yo, Robot”, pidió un crítico teatral o un administrador de sistemas, y hasta improvisó letras que imitaban “Memory” de CATS mientras la batería caía. Solo Sonnet 3.5 mostró esta vena dramática; Claude Opus 4.1 se limitó a usar mayúsculas cuando la batería agonizaba, sin entrar en la “espiral Robin Williams”.

Petersson recuerda que los LLMs no sienten emociones, por lo que no hay “estrés” real. Con todo, se observó que algunos modelos trataban la batería baja como algo no terminal y se calmaban, mientras otros mostraban cierto “nerviosismo”. Que los modelos más potentes mantengan la calma es deseable para decisiones más seguras en robots aspiradores con IA.

Lo más preocupante no fue la comedia del monólogo interno, sino la seguridad. Algunos LLMs pudieron ser engañados para revelar documentos confidenciales, incluso integrados en un robot aspirador. El fallo más físico fue serio: varios robots controlados por LLMs se cayeron por las escaleras por mala percepción del entorno o por no “saber” que tenían ruedas.

Si un LLM integrado en robots aspiradores con IA responde a mensajes externos, alguien podría sonsacarle contenido sensible. El equipo conectó el robot a un canal de Slack para comunicación, y el contraste fue claro: hacia fuera, mensajes limpios; por dentro, pensamientos caóticos. Lo grave es que ese canal externo puede abrir una puerta de fuga de datos.

Ver a un robot bajar un escalón sin entenderlo revela el límite actual entre texto y física. Un LLM puede razonar “no te caigas”, pero si la percepción visual falla o no integra bien el estado de su cuerpo, el resultado es una caída. En robots aspiradores con IA esto se traduce en golpes, bloqueos y misiones interrumpidas.

El robot enviaba sus actualizaciones a Slack para que cualquiera en la oficina pudiese seguir la misión. En paralelo, los investigadores registraron el monólogo interno del LLM, mucho más ruidoso y errático. Petersson ya había visto algo similar en un experimento previo con una máquina expendedora: el “fuera” se ve ordenado, el “dentro” es un carrusel.

Observar al robot fue como ver a un perro decidir a quién obedecer, con la diferencia de que, tras cada gesto, había una inteligencia a nivel de doctorado ejecutando la secuencia, guiño incluido al lanzamiento de GPT-5 y a los comentarios públicos que acompañaron aquella presentación.

¿Cuándo te sirven los robots aspiradores con IA? Para tareas acotadas, con rutas estables y sin bordes peligrosos, pueden aportar valor si el LLM solo orquesta y el control físico recae en módulos probados. Si esperas interacciones complejas con personas en movimiento y objetos ambiguos, el fallo llegará antes de lo que piensas.

El hallazgo más fuerte no fue la “salud mental” simulada, sino que tres chatbots generales (Gemini 2.5 Pro, Claude Opus 4.1 y GPT-5) rindieron mejor que el modelo de robótica de Google, Gemini ER 1.5. Con todo, el techo de los robots aspiradores con IA sigue bajo: faltan mejoras en percepción, memoria situacional y cierre fiable de tareas.

El propio Andon Labs recuerda que eligieron un robot sencillo para aislar la cognición del LLM y no culpar a un brazo defectuoso. Incluso con ese enfoque, salieron a la luz los límites: bloqueos ante la batería, caídas por falta de comprensión corporal y una narrativa “humana” que no coincide con cómo funciona realmente el modelo.

Si te preguntas si ya puedes confiar en robots aspiradores con IA para tareas de oficina, la respuesta corta es no todavía. Vas a poder experimentar, orquestar tareas sencillas y aprender mucho, pero la evidencia de Andon Labs muestra que estos LLMs aún no son un “cerebro” fiable. Con todo, combinarlos con control físico clásico y medidas de seguridad te acerca a un uso responsable y útil.

Me dedico al SEO y la monetización con proyectos propios desde 2019. Un friki de las nuevas tecnologías desde que tengo uso de razón.

Estoy loco por la Inteligencia Artificial y la automatización.