Kimi K2 Thinking es el nuevo modelo de Moonshot, la firma china del ecosistema Alibaba, y llega con una promesa clara: más autonomía y un enfoque abierto que compite de tú a tú con los grandes.

Moonshot lanzó Kimi K2 en julio con 10.000 millones de parámetros y ahora sube a 32.000 millones de parámetros activos en Kimi K2 Thinking. Ese salto no es solo “más grande”, porque activa solo lo necesario en cada tarea con una arquitectura Mixture-of-Experts. La trampa está en cómo usa esas “herramientas agénticas”… y en cuántas puede encadenar sin fallar.

Según la propia Moonshot, este modelo mantiene entre 200 y 300 llamadas secuenciales a herramientas, lo que se traduce en decisiones y acciones autónomas durante más tiempo. Piensa en reservar un viaje, comparar precios, rellenar formularios y enviar confirmaciones, y todo seguido. Si lo comparamos con la app móvil de un servicio web, aquí la IA toma el volante y tú supervisas.

Para ti, eso significa que vas a poder delegar procesos largos sin partirlos en trozos. Para una empresa, implica menos errores y más ritmo en tareas repetitivas como recopilar datos, navegar por páginas internas y externas, y resumir informes.

Kimi K2 Thinking además es multimodal, con búsqueda en tiempo real, y entiende texto, imágenes y código en la misma conversación, manteniendo un contexto amplio durante horas.

La arquitectura Mixture-of-Experts explica el equilibrio: varios “expertos” se activan solo cuando hace falta, y el resto queda en reposo. Eso recorta coste de cálculo y mejora la estabilidad en secuencias largas. Hay un dato que ilustra el enfoque: el entrenamiento costó 4,6 millones de dólares, frente a los ~500 millones estimados de GPT-5, una diferencia abismal en 2025 que empuja el precio final al usuario.

Y aquí llega otro punto práctico. La API de Kimi K2 Thinking cuesta 0,6 dólares por millón de tokens de entrada y 2,5 por millón de salida. GPT-5 Chat se mueve en 1,25 y 10 dólares, y Claude Sonnet 4.5 en 3 y 15 dólares. Con todo, pagar menos no sería suficiente si rindiera peor; el giro está en los bancos de prueba independientes.

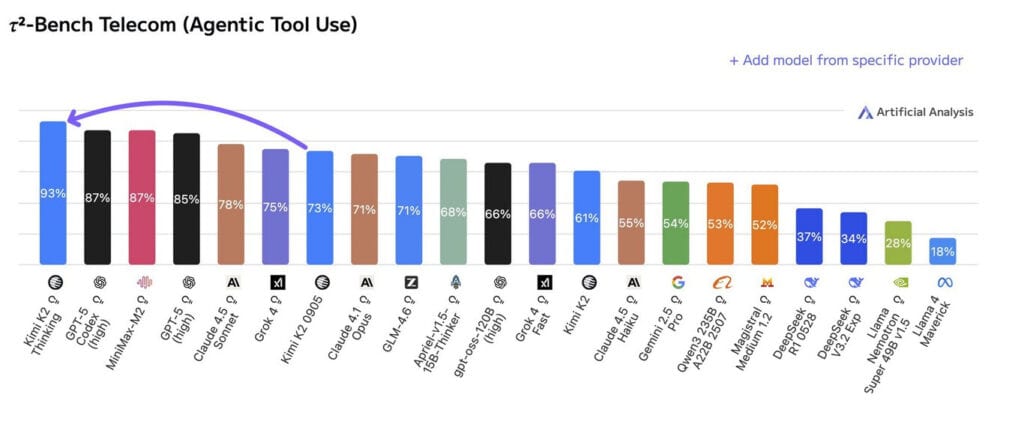

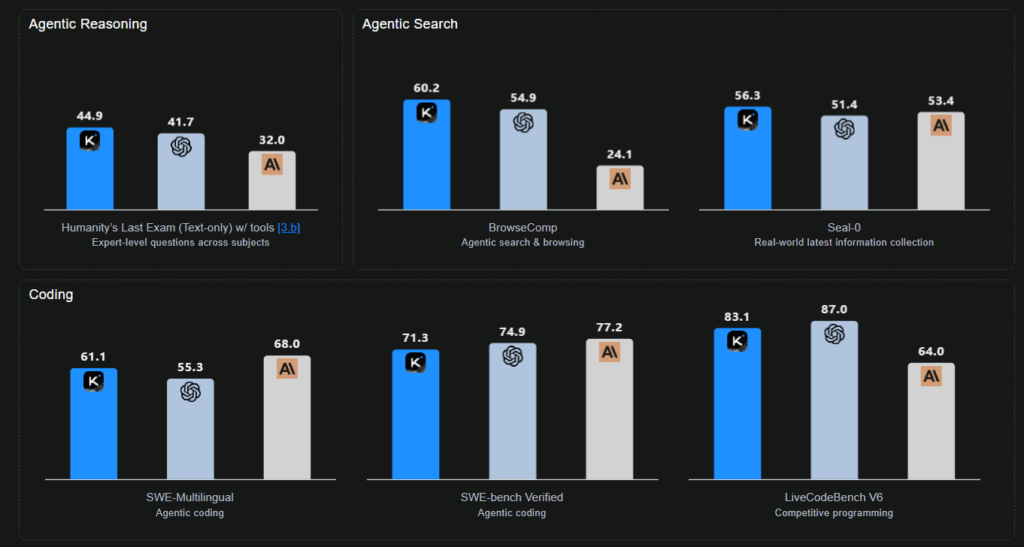

Esos benchmarks muestran que Kimi K2 Thinking supera a GPT-5 y Claude Sonnet 4.5 (Thinking) en tareas de búsqueda, navegación agéntica en navegador, manejo de texto y recopilación de información. Aun así, todavía no lo adelanta en generación de código, un área donde sigue por detrás.

El modelo es abierto. Puedes leer su código, adaptarlo o instalarlo desde su repositorio en GitHub, algo que contrasta con OpenAI, Google o Anthropic, que mantienen modelos cerrados. Aun así, instalar Kimi K2 Thinking localmente requiere un ordenador muy potente. Para salvar ese obstáculo, Moonshot publica versiones destiladas que bajan la barrera y, para la mayoría, el acceso web es suficiente.

A nivel de experiencia, Kimi K2 Thinking funciona como un chatbot conversacional con razonamiento complejo y memoria larga. Permite subir documentos grandes, pedir resúmenes fiables y generar informes con citas, y también mezclar una imagen con texto y un fragmento de código en la misma consulta. Es multilingüe, aunque su foco principal es el chino.

La diferencia con ChatGPT o Gemini no es solo técnica, es de modelo de producto: código abierto frente a servicios propietarios. Ese matiz permite auditoría comunitaria, adaptación a sectores específicos y despliegues “on-premise” cuando el cumplimiento exige control total. DeepSeek es otro ejemplo de este movimiento abierto que ya compite con grandes como Gemini o ChatGPT.

Si solo quieres probarlo, no necesitas instalar nada. En kimi.com puedes registrarte y usar gratis Kimi K1.5 y Kimi K2. Para acceder a Kimi K2 Thinking en la versión web oficial y completa hay suscripción, con planes de 19 o 30 dólares. Ese acceso en web facilita usar la versión avanzada sin tocar tu ordenador.

En pruebas públicas y documentación técnica, los datos citados proceden de Moonshot y de bancos de prueba difundidos por la comunidad, contrastados con precios de API publicados en sus webs. “El modelo mantiene cientos de llamadas sin romper el hilo contextual”, explican desde Moonshot.

Hay contexto que ayuda a entender el salto. Kimi K2 empezó “la serie” en julio con 10.000 millones de parámetros, y Kimi K2 Thinking sube a 32.000 millones activos con MoE. En paralelo, el sector ha visto cómo modelos abiertos como DeepSeek presionan a los cerrados con resultados competitivos. La novedad aquí no es solo el rendimiento, sino el equilibrio entre precio, apertura y funciones agénticas.

Si tu prioridad es programar a diario, ChatGPT o Gemini siguen por delante en código. La carrera sigue, y este modelo ha entrado con fuerza en el grupo de cabeza.

Directora de operaciones en GptZone. IT, especializada en inteligencia artificial. Me apasiona el desarrollo de soluciones tecnológicas y disfruto compartiendo mi conocimiento a través de contenido educativo. Desde GptZone, mi enfoque está en ayudar a empresas y profesionales a integrar la IA en sus procesos de forma accesible y práctica, siempre buscando simplificar lo complejo para que cualquiera pueda aprovechar el potencial de la tecnología.