OpenAI da otro pequeño paso con GPT‑5.2‑Codex, una versión centrada en desarrollo de software y ciberseguridad que aterriza directamente en ChatGPT y, en breve, en la API. Vas a poder pedirle desde refactorizaciones grandes hasta revisiones de seguridad, todo en sesiones largas sin perder el hilo.

No se trata de una revolución total respecto a GPT‑5.1‑Codex‑Max, que salió hace menos de un mes. Los cambios son matizados, pero tocan puntos sensibles para cualquier equipo técnico: más estabilidad en tareas largas, mejor manejo de repositorios grandes y un foco muy claro en detectar riesgos de seguridad en tu código y en las arquitecturas que usas.

GPT‑5.2‑Codex es un modelo de IA derivado de GPT‑5.2, entrenado específicamente para tareas de programación y pensado para integrarse en flujos de trabajo reales de desarrollo de software. Nace como evolución directa de GPT‑5.1‑Codex‑Max, así que mantiene su filosofía: servir como “compañero de código” que escribe, revisa y ejecuta tareas técnicas de forma bastante autónoma.

La gran diferencia está en el enfoque. Esta versión está diseñada para que puedas programar de forma más autónoma con ayuda de la IA, pero con un refuerzo claro en ciberseguridad. No solo genera funciones o clases, también analiza cómo encajan en la arquitectura, qué dependencias tocan y qué posibles agujeros podrían aparecer, especialmente cuando trabajas con frameworks muy usados en producción.

Si venías usando GPT‑5.1‑Codex‑Max, te preguntarás qué cambia de verdad. GPT‑5.2‑Codex introduce mejoras de rendimiento, pero no un salto dramático. En benchmarks como SWE‑Bench Pro o Terminal‑Bench 2.0, este modelo consigue algo más de precisión que GPT‑5.2 y que el propio GPT‑5.1‑Codex‑Max, aunque por muy poco margen. Es un ajuste fino, no una ruptura total.

Esas pequeñas mejoras se notan en cosas muy concretas: es más fiable al completar tareas complejas de código, comete algo menos de errores al interpretar instrucciones largas y suele necesitar menos correcciones cuando le pides cambios grandes sobre un mismo repositorio. No te va a escribir el sistema entero solo, pero sí vas a poder delegar mejor muchas partes repetitivas y pesadas.

GPT‑5.2‑Codex hereda de GPT‑5.1‑Codex‑Max el uso de agentes para programación autónoma y la capacidad de trabajar con una Terminal integrada. Eso significa que puede seguir una serie de pasos, ejecutar comandos, revisar resultados y ajustar el plan sin que tengas que microgestionar cada línea, algo muy útil para tareas como pruebas automatizadas o scripts de mantenimiento.

En la práctica, puedes pedir que prepare un entorno, ejecute tests, modifique archivos y vuelva a lanzar las pruebas hasta que pase todo. El control final sigue siendo tuyo: el modelo no lanza comandos peligrosos sin que tú lo revises, y no tiene acceso directo a tu entorno si no lo integras explícitamente de forma controlada.

Uno de los puntos fuertes de GPT‑5.2‑Codex es su entrenamiento para trabajar de forma nativa con múltiples ventanas de contexto. Esto le permite seguir una tarea de larga duración, saltando entre partes del código o documentación, sin “olvidar” lo que estaba haciendo unas horas antes. Para ti, se traduce en sesiones largas sin rupturas raras de contexto.

Gracias a una técnica de compactación de contexto, puede condensar información previa y mantenerla accesible. Así puede continuar una refactorización que empezó hace rato, entender los cambios que ya se aplicaron y evitar volver a sugerir lo mismo. No es memoria mágica, pero aguanta mejor proyectos medianos y grandes donde un solo archivo ya no cuenta toda la historia.

Cuando afrontas refactorizaciones amplias o migraciones de código, la memoria de contexto marca la diferencia. OpenAI indica que GPT‑5.2‑Codex mejora el rendimiento en cambios a gran escala, manteniendo una visión coherente de grandes repositorios durante sesiones prolongadas. Esto ayuda mucho cuando tocas varias capas de la aplicación a la vez.

El modelo es especialmente sólido en tareas de refactorización profunda, migraciones a nuevos frameworks o versiones, y en la creación de funcionalidades que afectan a distintos módulos. Según la propia compañía, es capaz de seguir iterando sobre una misma tarea incluso cuando cambias el plan a mitad de camino o cuando los intentos anteriores han fallado, sin perder el hilo de lo ya probado.

El foco central de GPT‑5.2‑Codex es la seguridad. OpenAI asegura que sus capacidades de ciberseguridad son las más sólidas que han lanzado hasta ahora en un modelo orientado a código. No solo identifica fallos evidentes, también revisa patrones de arquitectura y flujos de datos que pueden derivar en problemas difíciles de ver a simple vista.

La idea es que puedas integrarlo como una herramienta más dentro de tu equipo de seguridad o de tu pipeline de CI/CD. De este modo, vas a poder reaccionar con más rapidez ante nuevas amenazas, pedir una revisión rápida de un módulo sensible o solicitar un análisis de riesgos sobre una nueva integración con un servicio externo, antes de que llegue a producción.

GPT‑5.2‑Codex está entrenado para analizar código y arquitecturas de software con rapidez, con un enfoque especial en los frameworks más populares. Eso incluye patrones típicos de aplicaciones web, APIs y servicios que suelen aparecer en entornos de producción. El modelo busca vulnerabilidades conocidas y posibles malas configuraciones que pueden pasar desapercibidas.

Sigue siendo una herramienta de apoyo, no un auditor completo. Te ayuda a detectar riesgos, destacar puntos delicados y priorizar revisiones, pero la decisión final sobre cambios de arquitectura o sobre un despliegue crítico debería seguir en manos de tu equipo de seguridad. Piensa en él como un analista rápido al que puedes pedir una segunda opinión casi al instante.

Cuando oyes hablar de un modelo de IA fuerte en ciberseguridad, la preocupación lógica es si también puede servir para atacar sistemas. OpenAI intenta acotar esto con su Marco de Preparación, donde clasifica la capacidad ofensiva de sus modelos. En ese esquema, GPT‑5.2‑Codex se queda por debajo del nivel considerado de alto riesgo.

Esto significa que el modelo, según la compañía, no tiene habilidades para automatizar ataques sin control humano ni para generar exploits complejos por su cuenta. Aunque es mejor que su predecesor a la hora de identificar vulnerabilidades, sigue sin llegar al umbral máximo de riesgo definido internamente. Es una forma de equilibrar potencia defensiva y control sobre el posible uso malicioso.

OpenAI afirma que va a trabajar con la comunidad de seguridad para reforzar protecciones y recortar el espacio para usos malintencionados de GPT‑5.2‑Codex. La idea es colaborar con expertos en ciberseguridad para ajustar filtros, mejorar las respuestas ante solicitudes sospechosas y detectar patrones de uso que puedan indicar actividad de hackers.

Ninguna medida es perfecta. Como desarrollador o responsable técnico, te interesa combinar estas protecciones con tus propios controles: gobernanza de acceso a la API, límites de uso interno y políticas claras sobre cómo se usa la IA en tu organización. El modelo ayuda, pero la responsabilidad final sobre cómo se emplea sigue siendo tuya.

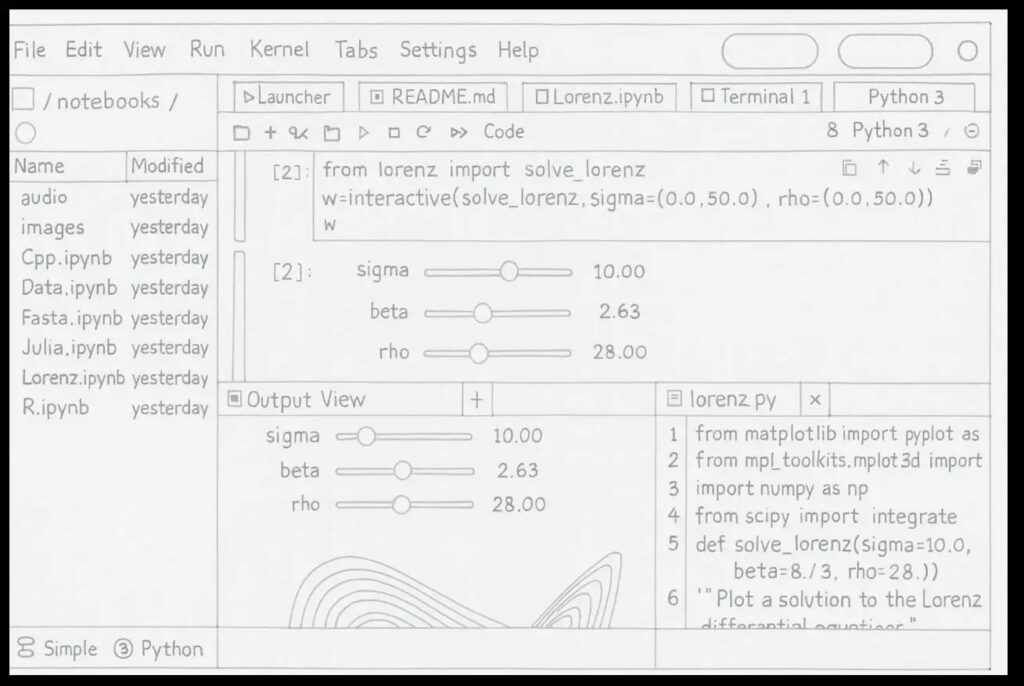

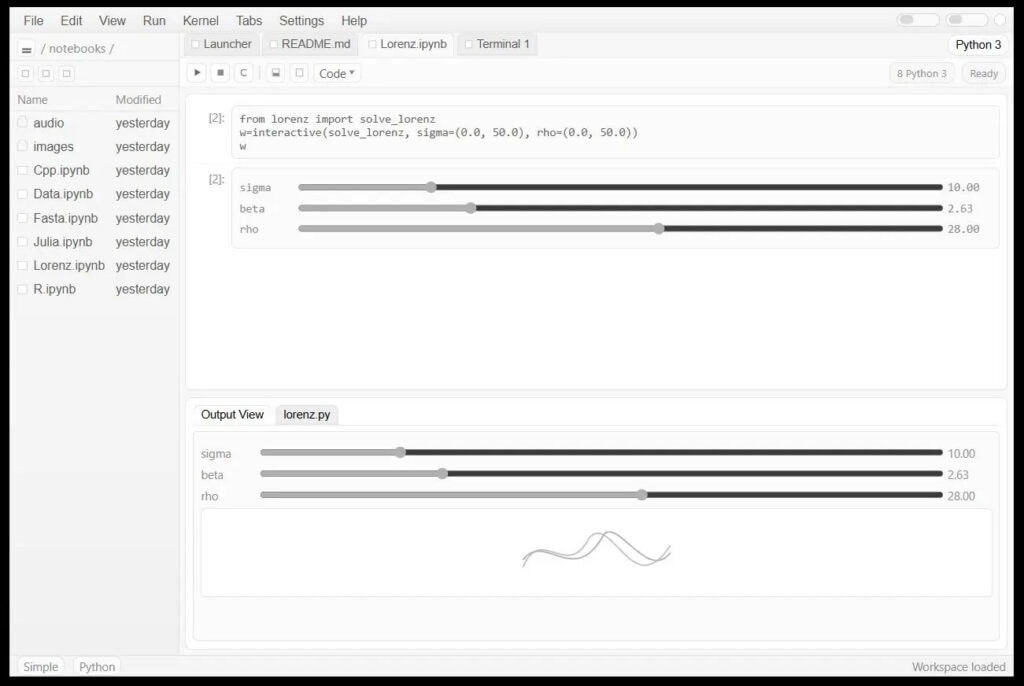

Otro punto interesante de GPT‑5.2‑Codex es cómo entiende mejor los elementos visuales que sueles compartir cuando trabajas con código: diagramas técnicos, gráficos de arquitectura o capturas de pantalla de errores. En entornos de trabajo, esta mejora de interpretación le permite contestar con más precisión cuando la entrada no es solo texto plano.

Gracias a esta capacidad visual, el modelo puede convertir un mock‑up o bosquejo en un prototipo funcional. Por ejemplo, puedes subir el diseño de una pantalla y pedir un esqueleto de front‑end que respete la estructura y los componentes. En muchos casos, el resultado puede estar ya bastante cerca de algo que podrías pulir y llevar a producción con pocos ajustes extra.

En la práctica, vas a poder usar GPT‑5.2‑Codex para tareas como generar prototipos rápidos a partir de bocetos, documentar diagramas de arquitectura en texto claro o explicar qué representa un gráfico técnico que alguien ha compartido en una incidencia. Todo esto ayuda a reducir malentendidos dentro del equipo y a pasar más rápido de idea a código funcional.

Conviene que revises siempre lo que genera. Aunque el prototipo parezca listo para producción, es sensato aplicar tus pruebas, tus estándares de calidad y tus controles de seguridad habituales, especialmente cuando la funcionalidad toca datos sensibles o lógica de negocio crítica.

OpenAI está desplegando GPT‑5.2‑Codex en ChatGPT de forma gradual para todos los usuarios de pago desde el momento del anuncio. Esto significa que, si tienes una suscripción, irás viendo cómo el modelo aparece como opción en tu versión de escritorio o en la interfaz web, sin necesidad de configuraciones complicadas.

Para integraciones más avanzadas, la compañía ha anunciado que GPT‑5.2‑Codex llegará a la API de OpenAI en las próximas semanas. Así vas a poder conectarlo a tus herramientas internas, pipelines de CI/CD o paneles de observabilidad, e incorporarlo como un servicio web que revisa código, genera parches o ejecuta auditorías básicas en segundo plano.

Si quieres empezar a probarlo en tu flujo de trabajo, puedes seguir un enfoque progresivo para ir viendo hasta dónde encaja con tu equipo:

Esta forma escalonada te permite aprovechar las mejoras de GPT‑5.2‑Codex en programación autónoma, manejo de repositorios grandes, análisis de vulnerabilidades y comprensión visual, sin perder de vista los riesgos ni delegar más de la cuenta. Si lo usas como apoyo constante y no como sustituto del criterio técnico, vas a poder escribir mejor código, reforzar la seguridad y mantener el control sobre cómo se emplea la IA en tus proyectos.

Me dedico al SEO y la monetización con proyectos propios desde 2019. Un friki de las nuevas tecnologías desde que tengo uso de razón.

Estoy loco por la Inteligencia Artificial y la automatización.