Imagina un auto que no solo “te lleva”, sino que entiende lo que pasa a su alrededor como si tuviera reflejos. No es ciencia ficción. En 2026, la conversación ya no gira solo en torno al motor o la batería, sino alrededor de un nuevo “cerebro” que promete decidir en tiempo real.

Esa promesa ya se le conoce como “IA física”. La etiqueta se repitió en el CES 2026 de Las Vegas y, aunque suene a contradicción —una computadora con cuerpo—, funciona como un mecanismo de marketing para describir una transformación concreta: autos, robots y sensores que empiezan a actuar en el mundo real.

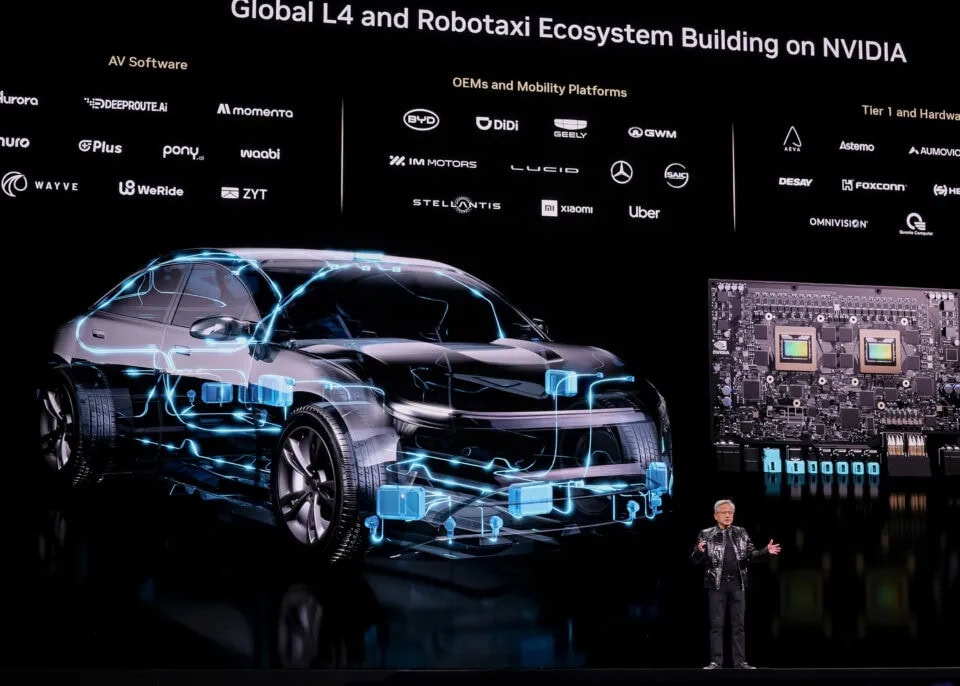

En ese mismo escenario, empresas de chips como Nvidia y ARM dejaron claro por qué empujan el término. La industria automovilística es su nueva central de negocios: un mercado estimado en 123.000 millones de dólares para 2032, un salto del 85% frente a 2023.

“El ‘cerebro central’ del vehículo será ahora cientos de veces más grande en capacidad de cómputo”, señaló Mark Wakefield, responsable del mercado mundial del automóvil en AlixPartners. Y subrayó la pieza clave: eso, precisamente, es lo que están vendiendo los fabricantes de chips.

Ahora bien, ¿qué significa “IA física” sin el brillo del eslogan? Se define como la forma en que los desarrolladores esperan que sistemas autónomos interactúen con el mundo real usando datos de cámaras y sensores. Es decir: percibir, comprender, razonar y ejecutar acciones complejas frente a situaciones cambiantes.

La analogía más clara está en casa. La IA física funciona como un tablero eléctrico inteligente: no alcanza con tener lámparas (sensores) y cables (software). Hace falta un interruptor central que lea qué ambientes están activos, detecte un problema y decida qué circuito encender o apagar en el momento justo.

En un auto, ese “tablero” es la computación a bordo (cómputo en el vehículo, procesamiento sin depender de la nube). Es el engranaje que toma lo que ven las cámaras, lo cruza con otros sensores y produce una respuesta inmediata: frenar, ceder el paso, mantener carril o transferir el control.

Porque, a diferencia de una app, un vehículo no puede “adivinar”: tiene que actuar con margen de error mínimo. Por eso la IA física exige recursos potentes, y ahí aparece la oportunidad para Nvidia y ARM. Nvidia, de hecho, anunció una nueva línea de modelos de IA de código abierto orientados a sistemas autónomos. ARM presentó en el CES una división específica dedicada a IA física, como quien abre una nueva planta dentro de la fábrica.

La convergencia se vio también en el cruce con humanoides. Un ejemplo: los robots humanoides que trabajarán en fábricas de Hyundai, desarrollados por Google DeepMind, Boston Dynamics y el fabricante coreano, comenzarían a desplegarse en los próximos meses. Es la misma lógica: sensores para “ver”, cómputo para “pensar” y actuadores para “hacer”.

En autos, la cadena de anuncios apuntó al mismo cableado. Ford afirmó que en 2028 venderá un sistema que permitirá manejar sin necesidad de mirar la carretera. El Afeela, fruto de Sony y Honda, se conducirá solo en la mayoría de situaciones en algún momento aún sin fecha. Geely tendrá chips de Nvidia para su “sistema de conducción inteligente”, con la promesa de evolucionar hacia “conducción autónoma de alto nivel”. Y Mercedes-Benz lanzará este año en Estados Unidos un nuevo sistema que, con el tiempo, aspira a llevar el auto de casa al trabajo sin intervención humana.

Jensen Huang, CEO de Nvidia, fue categórico en su presentación: los vehículos autoconducidos ya representan un negocio gigantesco para la compañía. El mensaje es simple: si el coche suma autonomía, el “cerebro” crece. Y si el “cerebro” crece, los chips se vuelven la pieza central.

Para el usuario, la aplicación práctica no es solo “que el auto maneje”. Es la posibilidad de que el vehículo entienda mejor el contexto y haga transferencias de control más finas entre humano y software. Dicho como rutina: menos estrés en tráfico complejo y más asistencia en momentos donde una distracción cuesta caro.

La IA física, al final, no es magia: es un interruptor cada vez más potente dentro de máquinas que ya convivían con nosotros. Y si ese tablero se vuelve más inteligente, el viaje diario también puede volverse un poco más liviano.

Directora de operaciones en GptZone. IT, especializada en inteligencia artificial. Me apasiona el desarrollo de soluciones tecnológicas y disfruto compartiendo mi conocimiento a través de contenido educativo. Desde GptZone, mi enfoque está en ayudar a empresas y profesionales a integrar la IA en sus procesos de forma accesible y práctica, siempre buscando simplificar lo complejo para que cualquiera pueda aprovechar el potencial de la tecnología.