OpenAI ha comenzado a desplegar ChatGPT Health, y no es un “nuevo modo” cualquiera: es la admisión oficial de que la gente ya usa ChatGPT como si fuese un mini-consultorio. Según la propia compañía, más de 230 millones de personas hablan cada semana con el sistema sobre cuestiones de salud, lo que deja claro que el fenómeno ya no es marginal.

Pero claro, que algo sea masivo no lo convierte automáticamente en seguro, ni correcto. En concreto, el cirujano Sina Bari, líder de IA sanitaria en iMerit, cuenta un caso que debería ponernos en modo alerta antes de dejarnos llevar por el hype: un paciente apareció con un diálogo impreso de ChatGPT en el que el sistema atribuía a un medicamento una “probabilidad del 45% de embolia pulmonar”.

Bari verificó el origen del dato y encontró el truco: ese 45% provenía de un artículo sobre el impacto del fármaco en un subgrupo muy específico de personas con tuberculosis. Es decir, el número no era “falso” en el sentido clásico, pero estaba sacado de contexto y no era aplicable al paciente que lo leyó. En medicina, el contexto es la diferencia entre tranquilizar a alguien o mandarlo a urgencias por pánico.

Pese a ver de cerca estos patinazos, Bari dice estar más ilusionado que preocupado con el anuncio de ChatGPT Health. OpenAI planea desplegarlo “en las próximas semanas” con la idea de crear un entorno más privado para hablar de salud, y ahí aparece el argumento fuerte de venta: los mensajes de los usuarios no se usarán como datos de entrenamiento del modelo.

Es decir, al menos sobre el papel, la conversación de “me duele esto” o “tengo este diagnóstico” no se recicla para mejorar el sistema de cara a otros. A ello se suma una idea que Bari considera positiva: formalizar un uso que ya existe para meter salvaguardas y proteger mejor la información del paciente. Pero formalizar también significa industrializar, y en salud eso suele venir con un peaje claro: más datos, más integraciones y más superficies de ataque.

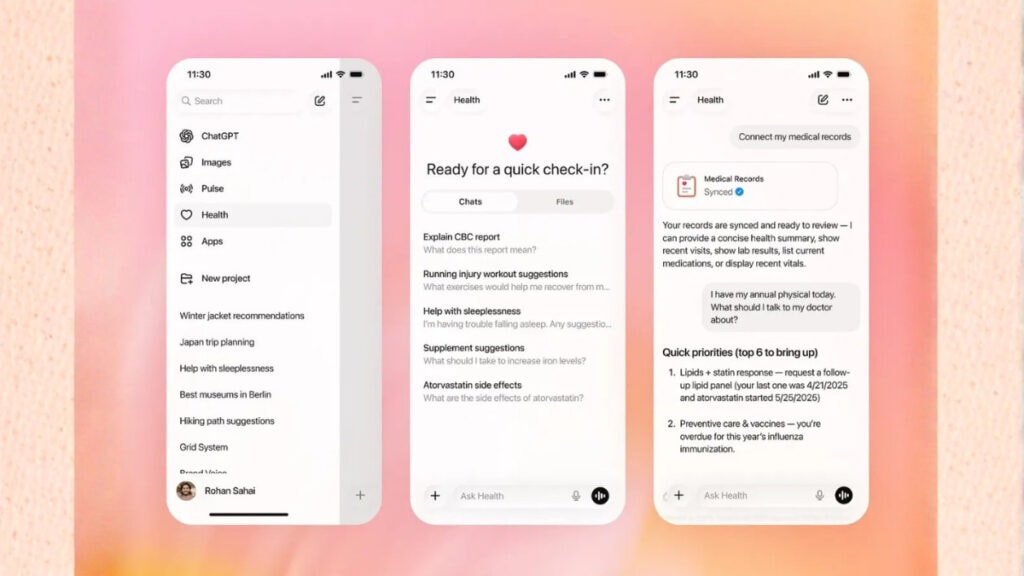

ChatGPT Health podrá ofrecer orientación más personalizada si el usuario sube su historial médico y sincroniza aplicaciones como Apple Health o MyFitnessPal. El salto es evidente: pasamos del “tengo dolor de cabeza” genérico al “aquí están mis analíticas, mi peso, mis pasos, mi sueño y mi medicación”. Esa personalización es justo lo que hace que una IA sea útil: menos generalidades, más precisión y menos consejos de manual.

Pero también es lo que convierte la herramienta en un imán para problemas serios de seguridad y cumplimiento normativo. En concreto, Itai Schwartz, cofundador de la empresa de prevención de fuga de datos MIND, lanza una advertencia nada paranoica: puede terminar transfiriéndose información médica desde organizaciones que cumplen HIPAA a proveedores que no cumplen HIPAA.

Si ese “salto” se normaliza, el debate deja de ser solo técnico y pasa a ser regulatorio y político: qué se permite, qué se audita y quién responde cuando algo sale mal. Schwartz lo resume en una pregunta incómoda: cómo abordarán los reguladores las transferencias de datos hacia proveedores no sujetos a HIPAA.

Privacidad aparte, el riesgo más conocido de los LLM no desaparece por ponerle un apellido: las alucinaciones. Evaluaciones como el modelo de consistencia factual de Vectara apuntan a que GPT-5 es más propenso a alucinar que muchos modelos de Google y Anthropic. Puedes tener una interfaz “Health”, promesas de aislamiento de datos y un tono más cuidadoso… y aun así recibir una explicación convincente y equivocada.

En medicina, el problema no es solo el error, sino la seguridad con la que se presenta. Una frase con porcentaje inventado puede pesar más que una visita al médico si el paciente ya viene preocupado. A esto se suma un cambio cultural sin marcha atrás: muchos usuarios han dejado de googlear síntomas y ahora preguntan a un chatbot.

Andrew Brackin, socio de Gradient e inversor en health tech, sostiene que la salud ya era uno de los mayores casos de uso de ChatGPT, y desde ese ángulo parece lógico que OpenAI intente ofrecer una versión más privada y optimizada para preguntas sanitarias. La pregunta incómoda es otra: ¿estamos mejorando el acceso a la salud o solo cambiando la pantalla desde la que nos preocupamos?

Nigam Shah, profesor de Medicina en Stanford y chief data scientist de Stanford Health Care, pone el foco donde más duele en EE. UU.: el acceso. Según Shah, el tiempo de espera para ver a un médico de atención primaria suele ser de tres a seis meses, y si la alternativa es esperar medio año o hablar hoy con una herramienta que no es médico pero puede orientar, mucha gente va a elegir lo segundo.

Eso no convierte al chatbot en un profesional sanitario; lo convierte en un parche que compite contra la nada. Por eso Shah cree que la vía más clara para introducir IA en sanidad es hacerlo del lado del proveedor, no del paciente. Hay un agujero negro de productividad del que se habla poco: estudios señalan que las tareas administrativas pueden comerse alrededor de la mitad del tiempo de un médico de primaria.

Menos tiempo mirando a personas y más tiempo mirando pantallas, formularios y sistemas que no se hablan entre sí. Si un médico atiende menos pacientes al día por burocracia, la lista de espera crece y el paciente acaba buscando respuestas donde puede. En Stanford, Shah lidera el desarrollo de ChatEHR, un software integrado en la historia clínica electrónica para interactuar con registros de forma más ágil.

Una probadora temprana, Sneha Jain, explica que hacerlo más usable permite dedicar menos tiempo a buscar información y poner lo relevante “por delante”, es decir, liberar minutos de pantalla para ganar minutos de conversación con el paciente. Anthropic también se mueve en esa dirección y anunció un producto de salud la misma semana, junto a Claude for Healthcare, orientado a reducir tiempo en tareas administrativas como la autorización previa con aseguradoras.

Mike Krieger, CPO de Anthropic, señaló que hay equipos que gestionan cientos o miles de casos semanales, y que recortar 20 o 30 minutos por caso sería un ahorro “dramático”. Pero aquí aparece la tensión estructural que no conviene ignorar: el incentivo del médico es ayudarte; el de una tecnológica, por noble que sea, responde ante accionistas.

Bari lo resume con una frase clave: los pacientes confían en que los médicos sean cínicos y conservadores para protegerles. ChatGPT Health puede ser un paso útil si ordena y reduce riesgos de un uso que ya existe, pero la gran jugada quizá no sea que tú hables con un bot, sino que tu médico recupere tiempo para hablar contigo.

Me dedico al SEO y la monetización con proyectos propios desde 2019. Un friki de las nuevas tecnologías desde que tengo uso de razón.

Estoy loco por la Inteligencia Artificial y la automatización.