Alibaba Cloud acaba de mover ficha con Qwen3-Max-Thinking, su nuevo modelo flagship de razonamiento, y lo ha hecho con una cifra imposible de ignorar: 262.144 tokens de contexto dentro de la línea Qwen3-Max. No se trata solo de un número llamativo, sino de una señal clara sobre el tipo de usos que Alibaba quiere habilitar.

Esto no va únicamente de “un chat que responde bien”. La apuesta apunta a flujos de trabajo largos, con memoria real, y a ofrecer a los equipos una palanca clara para elegir entre precisión o velocidad según la situación. Qwen3-Max-Thinking ya está disponible en Qwen Chat y está diseñado para integrarse en productos a través de Model Studio de Alibaba Cloud.

Lo realmente interesante no es el botón de “probar”, sino la idea de alternar entre “modo pensar” y “modo rápido” como quien cambia de marcha en un coche: cuando el escenario se complica, bajas una marcha y aseguras; cuando el camino es recto, aceleras sin miedo.

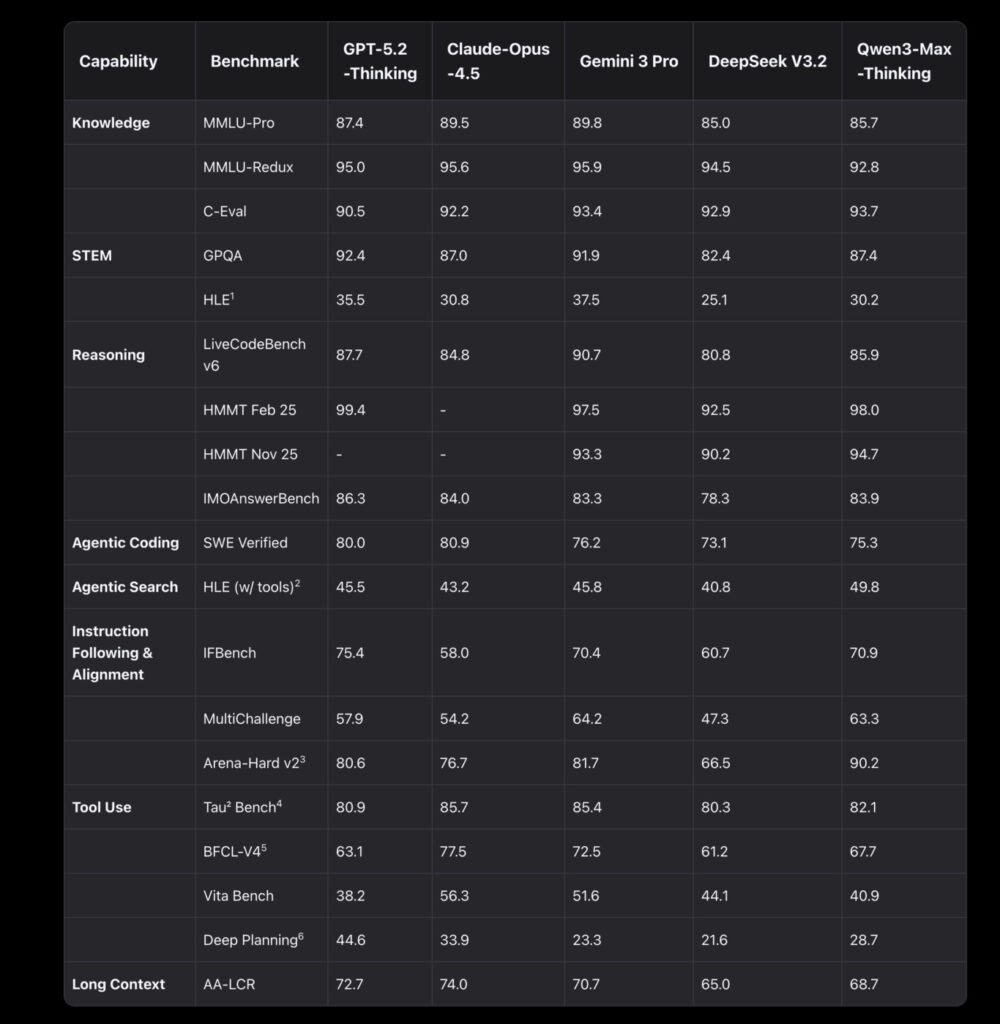

El modelo se presenta como una auténtica bestia de razonamiento para matemáticas avanzadas, programación y flujos de trabajo con agentes multi-step. Son tareas donde no basta con sonar convincente: hace falta encadenar pasos, validar resultados, retroceder si algo falla y, sobre todo, no perder el contexto a mitad del proceso.

En el mundo real, el prompt rara vez es “hazme un poema”. Suele ser algo más cercano a “analiza estos requisitos, revisa esta documentación, genera código, ejecútalo, detecta errores y corrígelos”. En ese tipo de escenarios, el razonamiento profundo marca la diferencia.

Las primeras pruebas también dejan una señal clara: la variante “thinking” brilla especialmente cuando hay uso de herramientas o verificación profunda. Eso sí, los testers advierten de algo conocido: el beneficio real depende mucho de la mezcla de prompts y del cómputo asignado en inferencia.

En Model Studio, la línea Qwen3-Max ofrece una ventana de contexto de 262.144 tokens, lo que permite introducir enormes volúmenes de texto, instrucciones, historiales, tablas o documentación sin que el modelo se quede sin “aire” a la primera de cambio.

Este tamaño de contexto cambia el tipo de aplicaciones que se pueden construir sin recurrir a hacks poco elegantes. Menos troceado agresivo, menos resúmenes forzados y menos situaciones de “ya no recuerdo lo que dijiste hace 30 mensajes”.

Eso sí, contexto largo no significa magia automática. Si alimentas al modelo con PDFs mal parseados y notas caóticas, el resultado seguirá siendo caótico. Sin embargo, con un pipeline bien diseñado —extracción limpia, fragmentos con sentido, buenas citas y control de versiones—, este contexto se nota especialmente en proyectos donde el historial importa: auditorías, soporte técnico, análisis legal o ingeniería con documentación viva.

Alibaba menciona un snapshot identificado como qwen3-max-2026-01-23, descrito como una fusión de capacidades de pensamiento y no pensamiento en un único modelo. No se trata de dos modelos separados que debas orquestar desde fuera, sino de un sistema capaz de alternar comportamientos según la necesidad.

A veces conviene razonar a fondo; otras, responder rápido es más eficiente. Esto abre una pregunta práctica inevitable: ¿quién decide cuándo “pensar”? ¿El usuario mediante el prompt, la configuración del producto o un automatismo según el tipo de tarea?

La respuesta probablemente sea “depende”, pero lo relevante es que Alibaba está empujando un modelo con mentalidad de producto, no solo de demo técnica.

En modo “thinking”, el modelo puede intercalar llamadas a herramientas dentro de su proceso de razonamiento. No es solo pensar más tiempo, sino pensar mientras consulta, calcula y verifica, que es justo lo que se espera de un LLM en tareas serias.

El paquete de herramientas es directo y funcional: búsqueda web integrada, extracción de contenido de páginas y un intérprete de código. Este combo apunta a un patrón cada vez más habitual: reunir evidencias, hacer parsing y ejecutar cálculos antes de generar una respuesta final.

Aquí también aparece la otra cara de la moneda. Si el modelo busca en la web, extrae datos y ejecuta código, el control de seguridad, permisos y trazabilidad deja de ser un añadido y pasa a ser parte central del diseño. Para entornos empresariales, esto es crítico: no quieres un agente creativo, sino uno que deje rastro, cite fuentes y no improvise números cuando tiene un intérprete de código disponible.

Model Studio plantea un uso claro: activar el razonamiento deliberado cuando la precisión es crítica y cambiar a respuestas rápidas para prompts rutinarios. El razonamiento se convierte así en un recurso asignable.

Si la tarea es sensible —finanzas, QA, decisiones técnicas—, pagas latencia y cómputo para reducir errores. Si es una consulta cotidiana, priorizas velocidad. El gran debate de 2026 no es si el modelo “sabe mucho”, sino cuánto cuesta, cuánto tarda y cuánta confianza genera cuando hay consecuencias reales.

El éxito de Qwen3-Max-Thinking se medirá en métricas poco glamorosas pero decisivas: menos retrabajo, menos alucinaciones costosas, mejores flujos de agentes e integración limpia en sistemas existentes.

Si Alibaba consigue que este doble modo sea fácil de controlar y predecible, el mensaje es potente: los LLM dejan de ser una charla y pasan a ser infraestructura. Con 262.144 tokens de contexto y herramientas integradas, la promesa es clara: agentes con memoria larga y capacidad real de acción. Queda por ver si la competencia responde con la misma combinación de contexto, tooling y pragmatismo… o si seguimos fingiendo que un chat rápido sirve para todo.

Me dedico al SEO y la monetización con proyectos propios desde 2019. Un friki de las nuevas tecnologías desde que tengo uso de razón.

Estoy loco por la Inteligencia Artificial y la automatización.