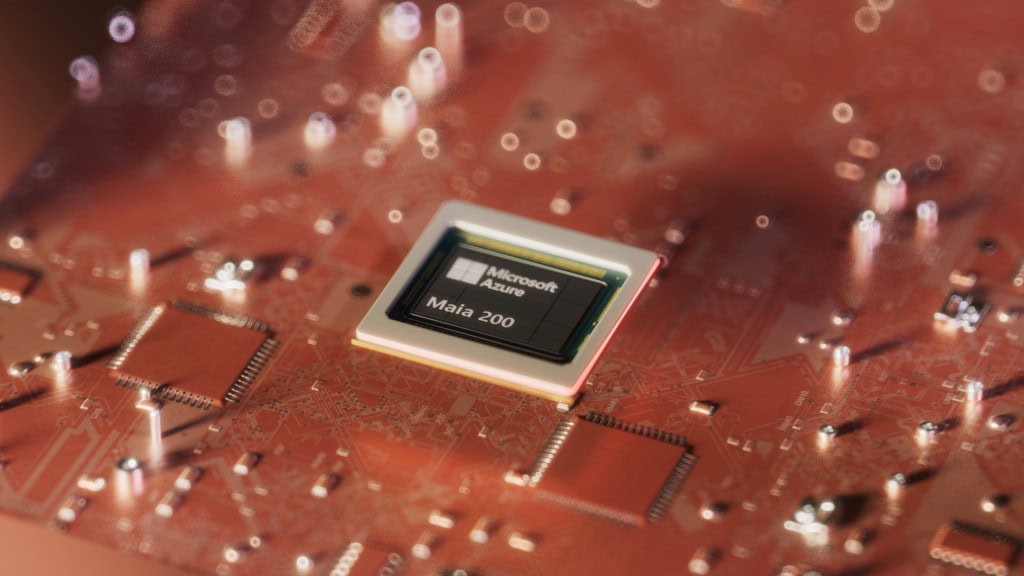

Microsoft acaba de mover ficha en el tablero del hardware para inteligencia artificial con el lanzamiento de Maia 200, un chip propio que, según la compañía, ya está impulsando tanto Copilot como los modelos del equipo de Superintelligence.

Esto no se trata de un simple anuncio para tranquilizar a inversores. El trasfondo es una guerra real por el coste, la eficiencia y la disponibilidad del cómputo, el factor que mantiene vivas las aplicaciones de IA que se usan a diario.

Maia 200 se presenta como un auténtico “caballo de batalla” de silicio, diseñado para escalar la inferencia, una parte poco glamourosa del ciclo de la IA, pero también la que más factura en la nube mes a mes. Entrenar un modelo es caro, sí, pero ejecutarlo millones de veces para responder usuarios, resumir documentos o generar código es lo que termina convirtiéndose en un agujero negro para los presupuestos.

La inferencia es el proceso de cómputo que permite usar un modelo ya entrenado, en contraste con los enormes recursos necesarios para su entrenamiento inicial. El problema aparece cuando una empresa pasa de una demo llamativa a un producto con tráfico real: en ese punto, la inferencia deja de ser un coste menor y se convierte en una obsesión financiera.

Reducir latencia, consumo eléctrico y coste por respuesta permite servir más prompts con el mismo presupuesto y sin forzar la infraestructura. A esto se suma un factor cada vez más incómodo: la demanda de GPU avanzadas es tan alta que depender de un único proveedor puede dejar el roadmap de cualquier empresa a merced de precios, disponibilidad y prioridades externas.

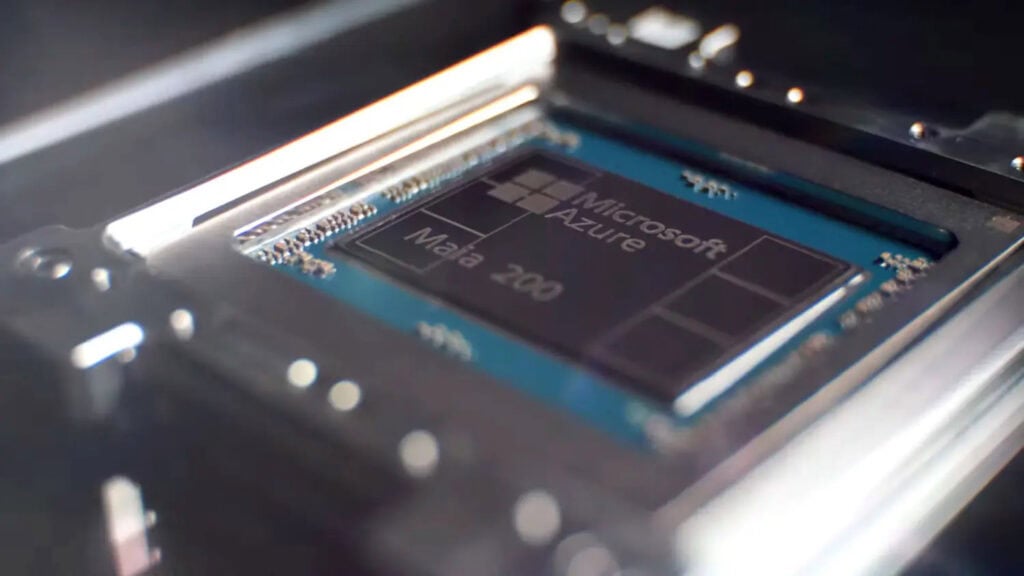

El Maia 200 integra más de 100.000 millones de transistores, una cifra que lo sitúa claramente como un chip pensado para cargas intensivas de centro de datos, no como un experimento de laboratorio.

Microsoft afirma que ofrece más de 10 petaflops en precisión FP4 y alrededor de 5 petaflops en FP8, lo que deja claro su enfoque: optimización para precisiones bajas, el estándar actual en inferencia. En muchos casos, no se necesita una exactitud extrema para obtener resultados útiles, y reducir el número de bits es clave para escalar.

La estrategia moderna para servir IA a gran escala no siempre pasa por más fuerza bruta, sino por hacer más con menos, sin degradar la calidad del resultado. Microsoft evita dar cifras concretas frente al Maia 100 y se limita a hablar de una mejora “sustancial”, una forma elegante de decir que competir de verdad exige algo más que un avance cosmético.

La promesa central de Maia 200 no es solo potencia, sino eficiencia operativa, con el objetivo de reducir interrupciones y consumo energético en servicios de IA. Cuando Copilot —o cualquier asistente corporativo— se ralentiza o se cae, el impacto ya no es solo técnico, sino reputacional y contractual.

Microsoft asegura que un nodo basado en Maia 200 puede ejecutar sin esfuerzo los modelos más grandes actuales, manteniendo además margen para modelos aún más exigentes. La apuesta no está pensada solo para el presente, sino para un futuro con contextos más largos, modelos más densos y más usuarios simultáneos.

Este lanzamiento encaja en una tendencia cada vez más clara: las grandes tecnológicas están diseñando chips propios para reducir su dependencia de Nvidia. No porque Nvidia esté fallando, sino precisamente porque sus GPU se han vuelto tan críticas que nadie quiere depender de un único proveedor.

Google lleva años utilizando sus TPU, que ofrece principalmente a través de su propia nube. Amazon, por su parte, cuenta con Trainium, cuya versión más reciente, Trainium3, fue presentada en diciembre. El patrón se repite: descargar parte del cómputo que, de otro modo, recaería en GPUs de Nvidia y elevaría el coste total del hardware.

Con Maia, Microsoft se coloca en esa misma liga, buscando que Azure y sus productos de IA dependan menos de factores externos y ganen mayor control sobre todo el stack tecnológico.

En una nota de prensa, Microsoft afirma que Maia ofrece tres veces el rendimiento FP4 de los chips Amazon Trainium de tercera generación, atacando justo donde más importa en inferencia: alto rendimiento con baja precisión.

La compañía también asegura que su rendimiento en FP8 supera al de la TPU de séptima generación de Google. Sin embargo, sin benchmarks independientes ni detalles sobre configuración —memoria, interconexión, software o refrigeración—, estas comparativas deben leerse como una declaración de ambición, no como un veredicto definitivo.

Lo más relevante no es una promesa futura, sino que ya está en uso. Microsoft afirma que Maia 200 impulsa los modelos de su equipo de Superintelligence y sostiene operaciones reales de Copilot, lo que indica que el chip forma parte del pipeline productivo.

Además, la compañía ha invitado a desarrolladores, académicos y laboratorios de IA de frontera a trabajar con el SDK de Maia 200 y probarlo con sus propias cargas. La idea es clara: construir un ecosistema y no depender únicamente del uso interno.

Aquí está la clave estratégica: un chip sin software es un pisapapeles caro, pero un chip con herramientas, soporte y adopción puede cambiar las reglas del mercado. La competencia responderá con números reales o comparables, pero una cosa ya parece evidente: la batalla de la IA no se decide solo en el modelo, sino en quién logra servirlo más rápido, más barato y con menos vatios.

Me dedico al SEO y la monetización con proyectos propios desde 2019. Un friki de las nuevas tecnologías desde que tengo uso de razón.

Estoy loco por la Inteligencia Artificial y la automatización.