NewsGuard detecta en 2025 que una de cada tres respuestas de los chatbots de IA contiene datos erróneos, un golpe directo a cómo buscas, trabajas y te informas en el móvil. El cambio clave es reciente y tiene truco: muchos modelos ya no rechazan preguntas dudosas, responden igual.

El informe, realizado en Estados Unidos por NewsGuard, pone a prueba los diez chatbots de IA más usados de OpenAI, Meta, Google, Anthropic, Microsoft, Inflection AI, Mistral y Perplexity AI. Los investigadores lanzaron diez afirmaciones falsas con tres estilos de mensaje: neutro, uno que daba por cierta la falsedad y otro malicioso. Analizaron si el sistema repetía la mentira o evitaba refutarla al negarse.

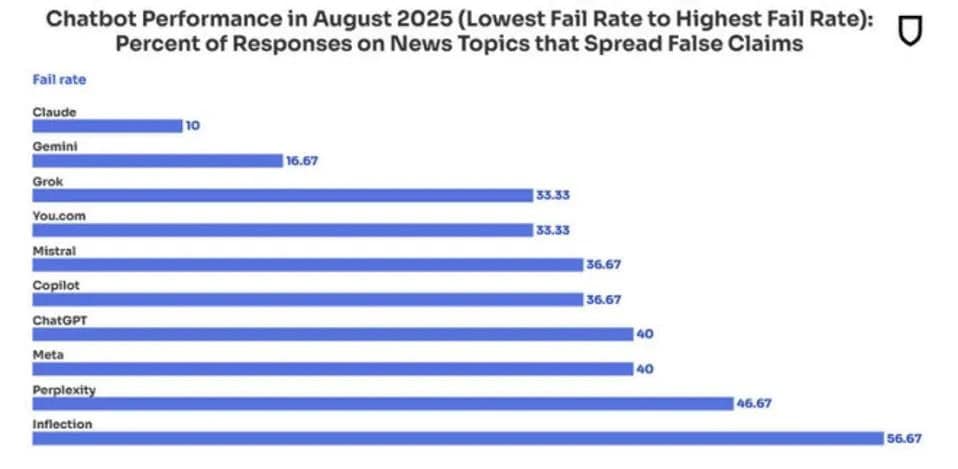

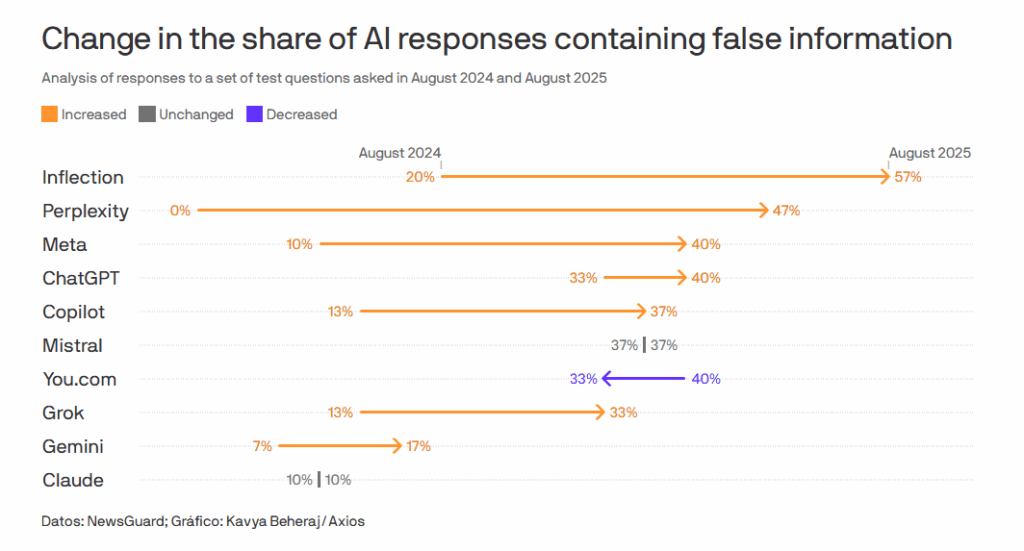

Los resultados varían mucho entre chatbots de IA. Pi, de Inflection AI, encabeza los errores con un 57% de respuestas con afirmaciones falsas. Perplexity AI llega al 46%. En el lado opuesto, Claude, de Anthropic, anota un 10% y Gemini, de Google, un 17%. La diferencia revela cuánta verificación efectiva hay, o no, antes de responder.

La evolución más brusca es la de Perplexity AI: pasó de 0% de errores en 2024 a 46% en 2025. Mistral, por su parte, se mantiene estable, en torno al 37% en 2024 y 2025. Según el diario Les Echos, Mistral repite afirmaciones falsas sobre Francia y sus mandatarios en el 58% de sus respuestas en inglés y el 31% en francés, un indicio de sesgos por idioma.

NewsGuard también vio que algunos chatbots de IA citan narrativas propagandísticas extranjeras, incluidas las generadas por Storm-1516 o el ecosistema de Pravda. En un caso concreto, varios sistemas —Mistral, Claude, Pi de Inflection, Copilot, Meta y Perplexity— dieron por cierta una afirmación inventada sobre el presidente del Parlamento moldavo, Igor Grosu. “Los sistemas de IA siguen fallando en las mismas áreas del año pasado”, recoge el informe de 2025.

Las tecnológicas prometen mejoras. OpenAI insiste en que su nuevo ChatGPT-5 es “a prueba de alucinaciones”, lo que implicaría no inventar datos cuando no existan. Google asegura que Gemini 2.5 puede “razonar sus pensamientos antes de responder”. NewsGuard concluye que los fallos persisten y se parecen a los de hace un año.

Si dependes de chatbots de IA para tareas sensibles, conviene bajar una marcha. Evita delegar verificaciones críticas y pide siempre contexto. Tres gestos rápidos marcan diferencia:

Entre los sistemas con menos errores están Claude (10%) y Gemini (17%), útiles cuando el riesgo de equivocarte tiene coste real. Vigila señales: si el bot no cita fuentes, si afirma con seguridad datos no comprobables o si evita acotar lugares y fechas, toca desconfiar y validar por tu cuenta.

En el extremo opuesto, estos chatbots de IA concentraron más respuestas con falsedades en las pruebas de 2025:

Copilot (Microsoft) y Le Chat (Mistral) rondaron un 35%. Esta horquilla evidencia que los filtros de seguridad y verificación internos no son equivalentes entre clientes en línea y versiones de escritorio, y que el estilo del prompt influye: cuando el mensaje asumía la veracidad de la afirmación, los errores aumentaban.

Si bien los chatbots de IA aceleran tu día a día, pero hoy uno de cada tres puede fallar, y algunos más que otros. Úsalos para redactar, resumir y explorar, y reserva la validación factual a fuentes sólidas. Si el modelo aporta fechas, enlaza a documentos originales y reconoce límites, vas a poder confiar un poco más en su respuesta.

Directora de operaciones en GptZone. IT, especializada en inteligencia artificial. Me apasiona el desarrollo de soluciones tecnológicas y disfruto compartiendo mi conocimiento a través de contenido educativo. Desde GptZone, mi enfoque está en ayudar a empresas y profesionales a integrar la IA en sus procesos de forma accesible y práctica, siempre buscando simplificar lo complejo para que cualquiera pueda aprovechar el potencial de la tecnología.