Durante años, la inteligencia artificial se encontró atrapada en un bucle computacional que limitaba severamente su capacidad para comprender el lenguaje. Los sistemas basados en Redes Neuronales Recurrentes (RNN) procesaban el texto de forma secuencial, palabra por palabra, como si un lector intentara entender una novela olvidando cada frase tras leerla.

Esta forma de procesar información funcionaba para frases cortas, pero fallaba estrepitosamente al enfrentar textos largos, incapaz de conectar ideas distantes o interpretar correctamente pronombres y contextos. En palabras de los expertos de la época, “la naturaleza inherentemente secuencial impide la paralelización”, dejando a la IA bloqueada y limitada.

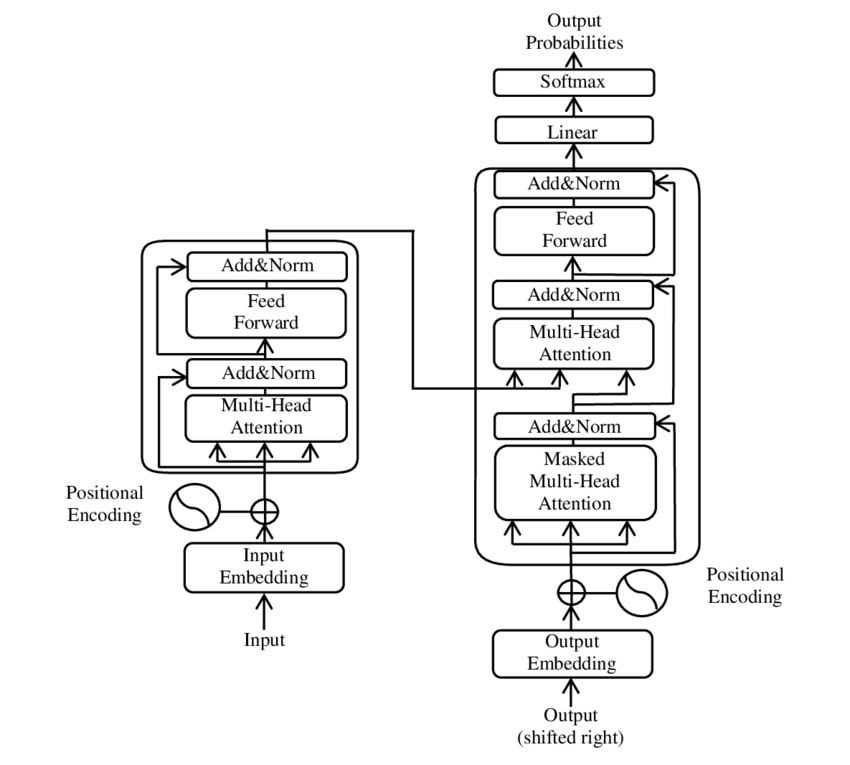

Todo cambió en 2017 con la publicación de un artículo de apenas ocho páginas titulado “Attention Is All You Need”. Sus autores presentaron una arquitectura radicalmente diferente: el Transformer, que sustituía la secuencia estricta por un procesamiento paralelo completo gracias a un mecanismo que recibió el nombre de auto-atención (self-attention).

Este sistema permite al modelo evaluar la importancia de cada palabra dentro de una frase en relación con todas las demás, creando un mapa contextual instantáneo. De esta manera, la IA podía entender que en la frase “El robot cogió la manzana del árbol y se la comió”, el pronombre “la” se refería a “manzana” y no a “árbol”, o que en “El banco del río era bonito”, “banco” se vinculaba a la orilla y no a una institución financiera.

El Transformer, al prescindir de la recurrencia y las convoluciones, permitió procesar grandes cantidades de información en paralelo, abriendo la puerta a modelos mucho más potentes y eficientes. Según los propios autores: “El Transformer permite una paralelización significativamente mayor y puede alcanzar un nuevo estado del arte”.

El impacto del Transformer no fue inmediato, pero resultó tectónico para la industria de la IA. Google aplicó estos principios para crear BERT, un modelo que transformó los motores de búsqueda al comprender el contexto de las consultas de manera más precisa.

Sin embargo, fue OpenAI quien llevó esta arquitectura a su máxima expresión con los modelos GPT (Generative Pre-trained Transformer), el corazón de herramientas como ChatGPT, que hoy usamos para redactar textos, resumir documentos o generar código.

Cada interacción con ChatGPT utiliza los principios del Transformer, demostrando cómo un pequeño paper académico de 2017 cambió la trayectoria de la IA de manera radical. Lo que comenzó como una innovación teórica terminó creando un nuevo paradigma en la comprensión automática del lenguaje, mostrando que, a veces, una idea concisa y bien ejecutada puede transformar industrias enteras.

Me dedico al SEO y la monetización con proyectos propios desde 2019. Un friki de las nuevas tecnologías desde que tengo uso de razón.

Estoy loco por la Inteligencia Artificial y la automatización.