Un equipo de la Universidad de Cambridge y la Universidad Hebrea de Jerusalén puso a prueba a ChatGPT con un reto clásico de hace 2.400 años. El objetivo no era pillar un dato suelto, sino ver si el sistema podía razonar sin apoyarse en memoria previa.

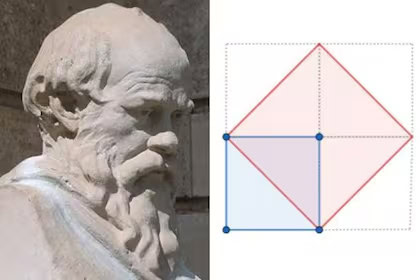

El desafío viene del siglo IV a.C., aparece en Platón y lo plantea Sócrates: “duplicar el cuadrado”. Si preguntas cómo hacerlo, la respuesta intuitiva es duplicar la longitud de los lados. Y ahí está el error. La pista correcta pasa por la diagonal, pero no es evidente a primera vista.

Los investigadores escogieron este dilema por una razón clara: su solución no se basa en imágenes ni en fórmulas memorizadas, y es improbable que estuviera escrita tal cual en los datos de entrenamiento. Querían comprobar si, en un diálogo, este servicio web podía construir una explicación razonada paso a paso.

Cuando llevaron la prueba al chat, el sistema sorprendió. Fue capaz de formular una explicación válida para el problema del cuadrado, sin recurrir a referencias textuales detectables. Había una segunda vuelta: al reformular la pregunta con un rectángulo, apareció un tropiezo, un error similar al de un alumno en aprendizaje. Esa combinación de acierto y fallo abrió un hilo interesante.

El investigador visitante en Cambridge, Nadav Marco, lo expresó en su valoración: “La probabilidad de que las respuestas correctas estuvieran en los datos de entrenamiento era prácticamente nula”. En otras palabras, no bastaba con rastrear una cita, porque el núcleo del reto exige deducción, no memoria.

También te puede interesar:Ingeniero Mostró el Prompt de ChatGPT con el que una Mujer Ganó 150K Dólares en PowerballEl profesor Andreas Stylianides conectó lo observado con la pedagogía: la “zona de desarrollo próximo”. Es el margen entre lo que un alumno ya domina y lo que puede aprender con guía. En el diálogo, el sistema pareció moverse en ese borde, elaborando propuestas nuevas y no solo repitiendo datos, igual que haces tú cuando avanzas con ayuda del profesor.

Los autores recalcan un límite que conviene no olvidar: no podemos afirmar que la inteligencia artificial “piense” como una persona. Con todo, hay paralelismos en los procesos, desde la construcción de hipótesis hasta el ajuste con nuevas preguntas.

¿Y si el sistema había visto algo parecido? Los investigadores eligieron precisamente un ítem muy poco probable en el entrenamiento, sin soporte visual y con formulación dialógica. En esa configuración, tú mismo vas a poder notar si el chat solo cita o si encadena pasos lógicos coherentes.

¿Qué mirar a partir de ahora? Tres señales te darán pista de hacia dónde va esto:

Harán falta más tareas geométricas, con y sin dibujos, y más sesiones multivuelta para medir si el sistema mantiene el hilo. De todos modos, la discusión ya está encendida en la comunidad: ¿hasta qué punto estas respuestas emergen de patrones estadísticos o de una especie de método interno para probar ideas? Para ti, usuario, lo práctico es claro: vas a poder plantear retos que no dependan de copiar, sino de explicar y reformular, y distinguir cuándo se “atasca”.

En última instancia, el experimento sugiere que la capacidad de razonamiento de ChatGPT no es pura repetición y que, frente a preguntas inéditas como “duplicar el cuadrado”, puede construir explicaciones útiles, aunque aún tropiece en variantes. El paralelismo con procesos humanos se asoma sin prometer milagros, y eso, para el día a día, ya es noticia suficiente para seguir aprendiendo con esta herramienta.

También te puede interesar:Emiratos Árabes Desafía a EE. UU. con su Nueva Superinfraestructura de IAMe dedico al SEO y la monetización con proyectos propios desde 2019. Un friki de las nuevas tecnologías desde que tengo uso de razón.

Estoy loco por la Inteligencia Artificial y la automatización.