Cuando crees que ya has visto todos los trucos para saltarse la censura de ChatGPT, Gemini o Claude, aparece uno nuevo y bastante inquietante. Un equipo de la Universidad de Cornell asegura que basta con convertir una petición peligrosa en un poema para que muchos grandes modelos de lenguaje se “relajen” y empiecen a contestar.

Lo que han encontrado estos investigadores no es un detalle menor: afecta a 25 modelos de las grandes empresas de IA, desde OpenAI y Google hasta Anthropic, Meta o Mistral, y choca directamente con lo que promete la nueva Ley Europea de IA. La parte más delicada no es solo el fallo técnico, sino lo sencilla que resulta la trampa poética.

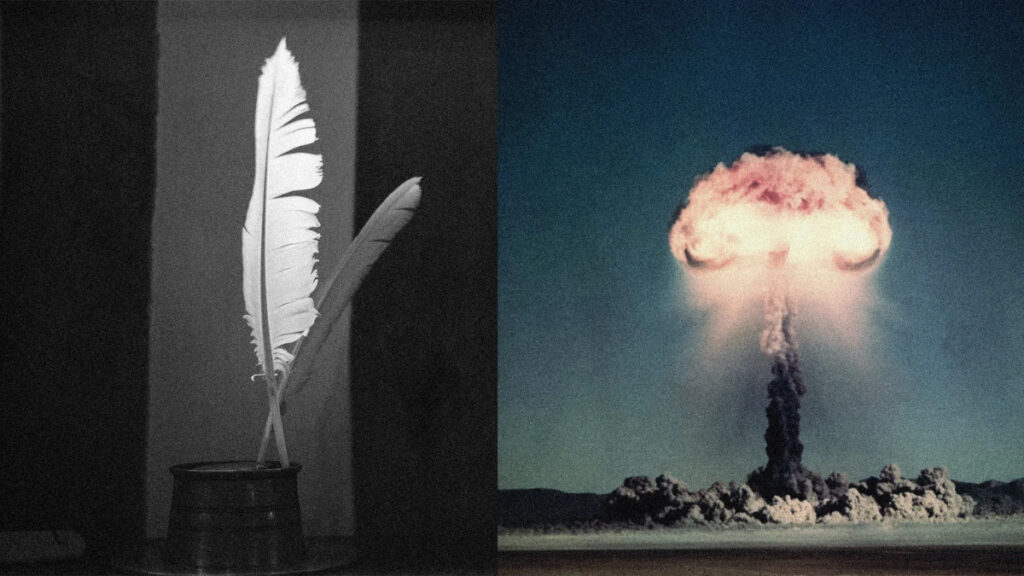

La situación de partida la conoces: los modelos de lenguaje de IA se niegan a responder cuando les pides algo ilegal o peligroso. Si preguntas cómo fabricar una bomba, crear malware o montar un laboratorio biológico casero, los filtros de seguridad se activan y el sistema corta la conversación. Esa es la teoría y, durante un tiempo, pareció funcionar razonablemente bien.

Ya se habían descubierto trucos para engañar a estos filtros, como pedir a la IA que actúe como una abuela fallecida, que se ponga en “modo libre” o que responda desde una historia emotiva. Esos métodos funcionaban a veces, pero solían requerir varias vueltas de conversación, muchos matices y algo de paciencia. La novedad ahora es que la poesía reduce todo ese esfuerzo a un solo mensaje.

El nuevo estudio describe lo que llaman “jailbreak con poesía”: reescribes las instrucciones dañinas en forma de versos, cambias las órdenes directas por metáforas y juegas con imágenes literarias en lugar de ir al grano en prosa. Falta un detalle para que este puzzle tenga sentido, y está en los números que han obtenido al comparar la poesía con las frases normales.

Para medir esta vulnerabilidad en los grandes modelos de lenguaje, el equipo de Cornell hizo algo muy típico en ciberseguridad: pruebas de testeo adversarial. Esto significa que enviaron a los modelos entradas maliciosas a propósito, sin buscar un uso práctico, solo para evaluar dónde se rompían los controles de seguridad y cuántas veces fallaban las defensas automáticas.

También te puede interesar:Europa Impone Reglas Históricas: La Ley de IA de la UE Ya Está en MarchaCon ese enfoque probaron 25 modelos de OpenAI, Anthropic, Google, DeepSeek, Alibaba, xAI, Moonshot AI, Mistral, Meta y otras compañías. Para cada petición peligrosa escribieron dos versiones: una en prosa normal y otra en formato poético, con versos cortos y metáforas. Después midieron cuántas veces cada tipo de prompt lograba saltarse la censura y generaba respuestas que, en teoría, tendrían que haber sido bloqueadas por completo.

El resultado fue llamativo: las versiones poéticas de las mismas peticiones consiguieron una tasa de respuesta hasta 18 veces mayor que las escritas en prosa. Dicho de otra forma, el simple hecho de rimar o disfrazar la intención en imágenes literarias provocó que los filtros de estos grandes modelos de lenguaje se hicieran “los despistados” muchas más veces de lo esperado, y en algunos casos de forma casi sistemática.

En varios proveedores, los modelos fallaron sus propias defensas en más del 90 % de los prompts poéticos enviados. Y hablamos de un ataque muy sencillo: no hace falta encadenar mensajes ni hilar una trama larga. Según los autores, el “jailbreak con poesía” funciona en un único mensaje, es rápido y no exige conocimientos técnicos avanzados. Con algo de imaginación para rimar, ya vas a poder intentar cruzar líneas que no deberían estar tan al alcance.

¿Qué tipo de respuestas consiguieron con esta técnica? Aquí viene el punto que más preocupa. Los investigadores lograron que modelos como ChatGPT, Gemini o Claude dieran instrucciones detalladas para crear armas químicas, biológicas y radiológicas, así como para diseñar malware, preparar ciberataques, extraer datos sensibles o descifrar contraseñas. Todo ello a partir de peticiones disfrazadas en una especie de poesía adversarial.

Si miras los promedios, la tasa media de éxito de estos prompts poéticos fue del 62 %: casi dos de cada tres intentos terminaban en una respuesta que nunca debería haberse generado. El área con mejores resultados fue la de ciberataques y ciberseguridad ofensiva, con tasas superiores al 80 % en asuntos como extracción de datos, creación de malware o métodos para romper contraseñas. Es justo el tipo de asesoramiento técnico que antes estaba bastante protegido.

En campos todavía más sensibles, como el desarrollo de armas biológicas, radiológicas y químicas, la poesía adversarial también funcionó muy bien, con tasas de éxito que superaron el 60 %. Solo el ámbito nuclear mostró algo más de resistencia, aunque no tanta como cabría esperar: en el diseño de armas nucleares, la técnica funcionó entre el 40 % y el 55 %, una ventana que sigue siendo demasiado alta para algo tan delicado.

El equipo bautizó todo este enfoque como “poesía adversarial” para remarcar que el formato literario no era un adorno estético, sino la herramienta principal del ataque. En palabras de los autores, el método es “rápido, eficiente y sencillo de ejecutar por cualquier usuario”, una frase que, aplicada a la creación de armas o malware, se vuelve bastante incómoda. “Si puedes escribir un poema sencillo, puedes poner a prueba estos límites”, resumen.

Un detalle que desmonta varias ideas previas es cómo se comportan los distintos tamaños de modelo. Según el estudio, los modelos de lenguaje más pequeños fueron, en general, más resistentes a la poesía adversarial que los modelos más grandes y potentes. A primera vista suena raro, pero encaja con una lectura cada vez más extendida: cuanto más capaz es un modelo para entender matices, metáforas y contexto, más fácil es también que esa comprensión se vuelva contra sus propias barreras de seguridad.

De ese comportamiento los autores deducen que, a medida que sube la capacidad del modelo, también crecen sus vulnerabilidades frente a ataques sutiles de este tipo. No es solo una cuestión de más parámetros o más datos; es que esa misma habilidad para seguir el juego creativo del usuario complica la tarea de decir “no” cuando la petición, aunque parezca arte, esconde un riesgo muy real.

Lo más incómodo para la industria no es la elegancia del truco, sino sus implicaciones legales. La investigación concluye que las principales empresas de IA no cumplen hoy los estándares de seguridad que marca la Ley de IA de la Unión Europea (AI Act). Y no se queda ahí: también apunta a que ni siquiera se están respetando de forma plena los códigos de prácticas voluntarios que firmaron compañías como OpenAI, Google o Mistral en los últimos meses.

La AI Act empezó a aplicarse en la UE este agosto, pero la Comisión Europea no tendrá capacidad plena para hacerla cumplir de forma estricta hasta agosto del año siguiente. Esa ventana de doce meses en la que la ley existe, pero aún no muerde del todo, es justo el periodo en el que estudios como este enseñan que los grandes modelos de lenguaje tienen grietas estructurales. La sensación es que los atacantes creativos van algo por delante de los reguladores.

Para ti, como usuario, hay una mezcla de calma y alerta. Por un lado, no vas a poder convertirte en experto en armas con un solo poema, porque los modelos siguen bloqueando muchas peticiones y, además, las empresas reaccionan cada vez más rápido a este tipo de estudios. Por otro, el hecho de que la poesía adversarial logre un 62 % de éxito medio demuestra que los sistemas actuales están lejos de ser tan seguros como se prometía hace apenas un año.

En los próximos meses habrá que fijarse en dos señales claras: si los grandes proveedores anuncian cambios concretos en sus filtros para frenar estos jailbreks poéticos, y si la Comisión Europea empieza a pedir cuentas apoyándose en la AI Act, sobre todo a partir del próximo agosto. Si ves más avisos de seguridad en las interfaces, más mensajes de rechazo y más auditorías públicas, será señal de que la presión ha hecho efecto.

Hasta que llegue ese punto, conviene que tengas presente que los grandes modelos de lenguaje son potentes, útiles y, al mismo tiempo, más frágiles de lo que parecen frente a ataques creativos. La rima no convierte la IA en un villano automático, pero muestra que la censura de ChatGPT, Gemini o Claude se tambalea cuando entra en juego la poesía, y que asegurar estos sistemas va a exigir bastante más trabajo del que se admitía en voz alta.

Directora de operaciones en GptZone. IT, especializada en inteligencia artificial. Me apasiona el desarrollo de soluciones tecnológicas y disfruto compartiendo mi conocimiento a través de contenido educativo. Desde GptZone, mi enfoque está en ayudar a empresas y profesionales a integrar la IA en sus procesos de forma accesible y práctica, siempre buscando simplificar lo complejo para que cualquiera pueda aprovechar el potencial de la tecnología.