Los gigantes de la IA pierden brillo justo cuando los “nanomodelos” empiezan a marcar el paso. La pista llega con Gemma 3 270M, un modelo diminuto presentado por Google que cabe en casi cualquier dispositivo y, Rinde sorprendentemente bien. ¿Por qué importa? Porque podrías ejecutar IA útil en tu móvil o en el navegador con un coste mínimo. Falta un detalle clave que cambia el juego.

Las referencias del mercado, como Llama 4, Claude 4 o el reciente GPT-5, siguen creciendo en tamaño y presupuesto, pero sus saltos cualitativos ya no impresionan como antes.

Mientras tanto, Gemma 3 270M pone el foco en lo contrario: especialización y eficiencia extrema. Hablamos de un “nanomodelo” de solo 270 millones de parámetros, frente a mastodontes como Llama 4 Behemoth (288B), Qwen 3 (235B) o DeepSeek R1 (671B).

En vez de potencia bruta, Gemma 3 270M se centra en ser una base muy afinable para tareas concretas. Queda por ver si renunciar a la versatilidad generalista paga la pena en el día a día. La respuesta aparece cuando lo pones a trabajar en algo real y medible.

Si entrenas el modelo con tus datos, vas a poder personalizar respuestas, clasificar correos o convertir textos en estructuras limpias para tus sistemas. La clave está en el ajuste fino (fine tuning) rápido, que te permite adaptar Gemma 3 270M a tu equipo y a tus métricas sin esperar semanas. Con todo, no pretende “saber de todo”, sino acertar en lo que tú necesitas.

En un Pixel 9 Pro, una versión cuantizada en INT4 de Gemma 3 270M gestiona 25 chats usando solo el 0,75 % de la batería. Es decir, puedes mantener conversaciones útiles sin que el teléfono sufra. No esperes razonamientos largos, tipo investigación avanzada. Aquí gana lo que es corto, rápido y repetible.

También te puede interesar:¿Usas ChatGPT Como Confidente? La Psicóloga Alejandra Enríquez Explica Por Qué Es un Error Grave

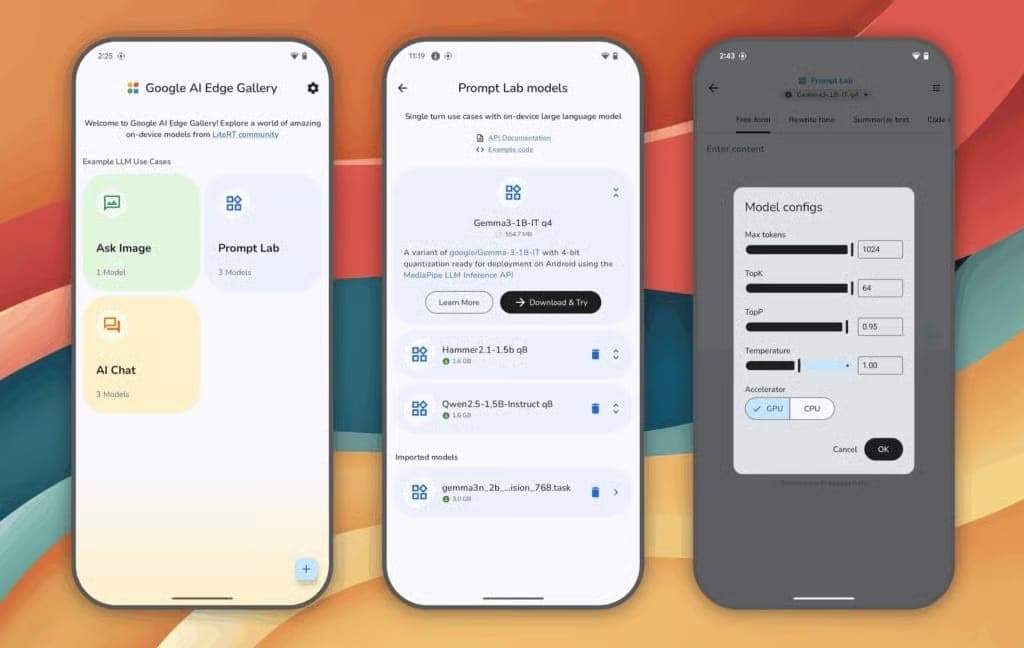

También suma en despliegue. Puedes ejecutar Gemma 3 270M en una pestaña del navegador y montar una web que genere cuentos para niños, respuestas personalizadas o clasificaciones al vuelo. Si lo comparas con la app móvil de un servicio web, vas a poder tener control total de los datos y del coste por uso. Y sin servidores complejos.

Con un ajuste fino ligero, Gemma 3 270M sirve para generar cuentos infantiles con estilos distintos, estructurar datos a partir de texto, y personalizar mensajes según segmentos de cliente. También puedes clasificar emails o tickets de soporte y jugar al ajedrez con nivel decente.

El objetivo no es competir con un gran modelo creativo, sino responder bien a tareas concretas, repetitivas y medibles. La familia Gemma 3 ya mostró el rumbo en marzo con variantes de 1B, 4B, 12B y 27B parámetros. Solo la de 27B entra en la liga “grande”; las otras corren en equipos modestos con 16 GB de memoria gráfica. Eso abre la puerta a que tengas un motor propio sin depender de la nube para todo.

Y no está sola. Microsoft empuja Phi-3 y Phi-4 (14B), en China destaca Qwen-2.5-14B, la startup Liquid propone LFM2 con 440M de parámetros, y NVIDIA tiene Nemotron-Nano-9B, que mejora benchmarks frente a modelos más grandes como Qwen3-8B. La señal es clara: los modelos pequeños crecen, se multiplican y marcan alternativas reales a los gigantes.

La personalización no es un muro técnico. Puedes afinar Gemma 3 270M en plataformas como Hugging Face siguiendo instrucciones de Google, y en pocas horas tener un prototipo útil. Para avanzar rápido, prueba esta secuencia breve:

Los datos de eficiencia y tamaño proceden de demostraciones técnicas de Google y de repositorios públicos, contrastados con especificaciones de parámetros y consumos reproducibles. Cada despliegue cambia con tu hardware, tu cuantización y tus datos, así que conviene medir en tu propio entorno con un conjunto de pruebas estable.

La respuesta corta: cada mejora requiere más cómputo, más tiempo y más talento, y el retorno práctico se estanca. Esos modelos siguen siendo útiles en tareas muy abiertas, como razonamiento complejo o multimodal profundo. La diferencia ahora es que ya no necesitas eso para casi todo.

El enfoque emergente sugiere otra arquitectura: pequeños modelos bien afinados que hacen una cosa muy bien y, después, se interconectan entre sí. Así puedes componer aplicaciones con módulos que se especializan en “entender”, “limpiar” y “responder”. Si uno falla, lo cambias sin tocar el resto, y mantienes el control del rendimiento y del precio.

La sorpresa del año no llega de un gigante, sino de un modelo diminuto que puedes moldear a tu medida. Gemma 3 270M no busca sustituir a los grandes, sino encajar donde importa: precio, rapidez y control. Si tu prioridad es construir herramientas precisas para necesidades concretas, vas a poder hacerlo con Gemma 3 270M, con Phi-3/4 o con LFM2, y sumar resultados sólidos sin un presupuesto desorbitado.

Directora de operaciones en GptZone. IT, especializada en inteligencia artificial. Me apasiona el desarrollo de soluciones tecnológicas y disfruto compartiendo mi conocimiento a través de contenido educativo. Desde GptZone, mi enfoque está en ayudar a empresas y profesionales a integrar la IA en sus procesos de forma accesible y práctica, siempre buscando simplificar lo complejo para que cualquiera pueda aprovechar el potencial de la tecnología.