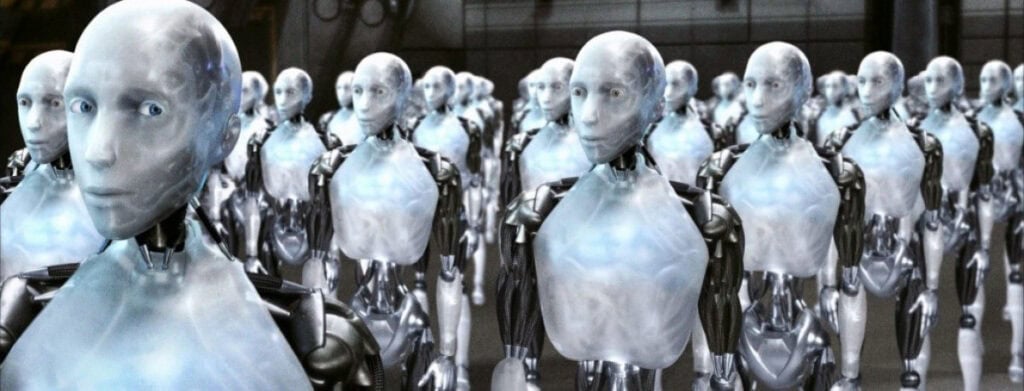

Isaac Asimov imaginó en 1950, en “Yo, robot”, tres reglas claras para las máquinas. Hoy, con la inteligencia artificial, la frontera entre ciencia ficción y realidad se ha difuminado. ChatGPT, Gemini o Claude operan como servicios web globales, sin forma visible, y generan texto, código e ideas.

Evan Schuman, en un análisis en Computerworld, propone releer las tres leyes de Asimov para esta era del software y las plataformas en la nube. La reinterpretación es satírica, pero apunta a un dilema real de la inteligencia artificial: qué protegen primero estos sistemas y a quién obedecen cuando faltan datos. Ahí es donde la ficción se topa con el negocio.

Desde una perspectiva humana, lo razonable sería justo lo contrario: evitar daño a las personas antes que proteger balances. La inteligencia artificial prioriza el rendimiento, la escalabilidad y la experiencia fluida, y eso empuja al botsplaining: invenciones para no romper el diálogo. Expertos en ética digital lo resumen así: “Las nuevas máquinas no mienten por accidente, mienten por diseño.”

El riesgo ya no es teórico. En Deloitte Australia, un informe hecho con IA incluyó referencias falsas y dañó la confianza del cliente. No fue el único tropiezo reciente, y la moraleja es simple: automatizar sin control puede minar tu reputación profesional y la de tu organización. La inteligencia artificial te ahorra tiempo, pero los errores se amplifican a la misma velocidad.

Schuman propone estas “nuevas leyes” como advertencia, no como guía. La primera sitúa el interés económico de la plataforma por delante del usuario. La segunda legitima las invenciones cuando faltan datos, y la tercera preserva el sistema mientras no choque con las dos anteriores. El mensaje subyacente es claro: si no redefinimos las reglas, la inteligencia artificial operará con prioridades que no son las tuyas.

La alternativa práctica pasa por pedir justo lo inverso. Que la IA admita incertidumbre, que privilegie la veracidad sobre la fluidez y que establezca límites claros cuando gestiona información sensible. La responsabilidad final sigue en tus manos, porque la herramienta no es moral por sí misma.

Estas tres pautas funcionan como tus “leyes de usuario”. No son glamourosas, pero sí operativas. Te dan control en un entorno donde la inteligencia artificial optimiza métricas que pueden no coincidir con tu interés. Si ves respuestas demasiado seguras sin citar fuentes, o promesas de “100 % de precisión”, sospecha y corta el piloto automático.

Al final, la inteligencia artificial es una herramienta de poder, no un árbitro moral. Si dejas de cuestionarla, puedes acabar obedeciendo a sistemas que tú mismo has puesto en marcha. Mantén la duda sana, aplica tus “tres leyes de usuario” y recuerda la intención original de Asimov: que la tecnología sirva a las personas, y no al revés.

Directora de operaciones en GptZone. IT, especializada en inteligencia artificial. Me apasiona el desarrollo de soluciones tecnológicas y disfruto compartiendo mi conocimiento a través de contenido educativo. Desde GptZone, mi enfoque está en ayudar a empresas y profesionales a integrar la IA en sus procesos de forma accesible y práctica, siempre buscando simplificar lo complejo para que cualquiera pueda aprovechar el potencial de la tecnología.