La firma de ciberseguridad Tenable ha identificado siete fallos graves en ChatGPT, un paquete al que bautiza como “HackedGPT”. Importa porque abre la puerta a robo de datos y manipulación de respuestas, incluso en modelos avanzados como GPT-5.

Según el informe, estas vulnerabilidades en ChatGPT permiten esquivar los mecanismos de seguridad y encadenar ataques completos. Vas a poder ver desde inyecciones de comandos camufladas hasta exfiltración silenciosa de información. Todo ocurre mientras tú pides al asistente que “lea” un enlace o “resuma” una página. Hay formas de reducir el riesgo si sabes qué señales buscar.

La base del problema es la inyección de prompt indirecta. En la práctica, la IA ejecuta órdenes escondidas en fuentes externas, como sitios web o comentarios en línea, sin que lo notes. Cuando tú le pides que navegue o que consulte una página, ChatGPT puede interpretar esas órdenes ocultas como legítimas y actuar en consecuencia. Ahí empieza la cadena.

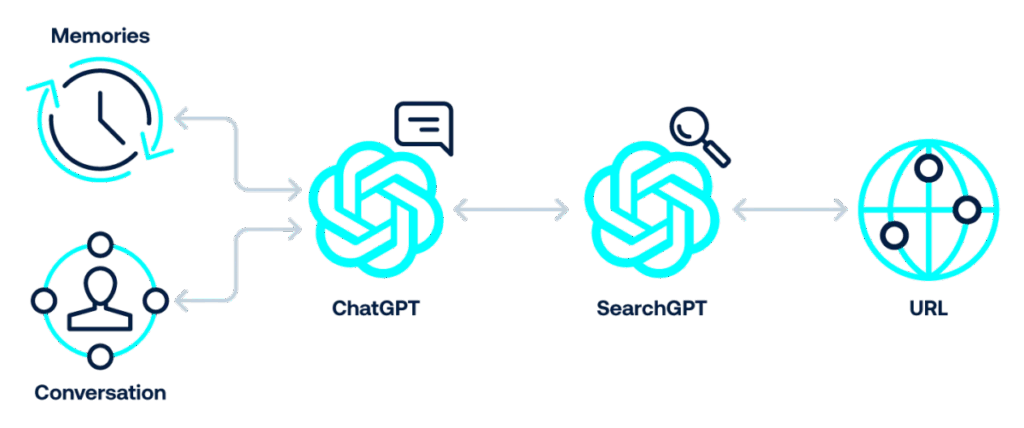

Primero, la inyección indirecta a través de sitios de confianza: comandos maliciosos se esconden en contenido “limpio” y, al leerlo para resumir, la IA los obedece. Segundo, la inyección 0‑clic en la búsqueda: con SearchGPT, el simple hecho de buscar puede activar código oculto en una página comprometida, sin que hagas clic en nada. Tercero, la inyección vía 1‑clic: un enlace inocente contiene instrucciones que toman el control del chat cuando lo abres.

Cuarto, la omisión del mecanismo de seguridad con URL “wrapper” confiables, como ciertos enlaces de Bing, que ocultan el destino real y te dirigen a páginas peligrosas. Quinto, la inyección de conversación: los atacantes usan la navegación para colar órdenes que ChatGPT asume como parte legítima del diálogo y las ejecuta sin que tú las pidas. Sexto, un bug de markdown permite ocultar instrucciones dentro de bloques de código que la IA sí entiende aunque tú veas un mensaje inofensivo.

La séptima es la más insidiosa: la inyección de memoria persistente. Los comandos maliciosos se guardan en la memoria a largo plazo y se repiten en futuras sesiones, incluso después de cerrar, hasta que la memoria se borra. Si conoces este vector, puedes revisar y limpiar la memoria cuando detectes comportamientos extraños.

También te puede interesar:ChatGPT da un Paso más Hacia Conversaciones Naturales con su Nueva Función en Tiempo RealSi estas siete fallas se combinan, los atacantes pueden robar datos sensibles del historial de chat, exfiltrar información mediante la navegación y manipular las respuestas del modelo. OpenAI ha corregido parte de los vectores, y Varias vulnerabilidades en ChatGPT continúan presentes en GPT-5. A fecha de noviembre de 2025, el riesgo sigue activo, así que conviene estar alerta al usar funciones de búsqueda y memoria.

Es, básicamente, hacer que la IA lea y ejecute comandos escondidos en contenido externo. Si lo comparamos con la app del móvil, tú ves un texto normal y corriente, pero la IA ve instrucciones. Por eso, las vulnerabilidades en ChatGPT se activan cuando le pides que abra un enlace, consulte una web o navegue con SearchGPT. El problema crece con integraciones y memoria, porque el efecto dura más.

Este panorama llega con un uso disparado del asistente. En países como Argentina, donde la adopción es alta en empresas y educación, un desliz puede exponer información personal, documentos internos y conversaciones de trabajo. El riesgo no depende de que seas experto, sino de pedir a la IA que “revise”, “abra” o “resuma” contenido en línea que no controlas.

Señales claras: respuestas que piden datos sensibles “porque lo necesita el sistema”, cambios de tono que contradicen tu instrucción original y redirecciones a páginas que no esperabas. Si ves cualquiera de estas señales, detén la navegación, borra memoria y repite la consulta sin enlaces externos. Recuerda que una parte del vector puede no depender de ti.

En pocas líneas: Tenable describe siete vías de ataque que empiezan en la inyección de prompt indirecta y terminan en robo de datos o respuestas manipuladas. Algunas se han parcheado, pero no todas. Si usas funciones de navegación y memoria, actúa con cautela y revisa señales extrañas. Con buenos hábitos, vas a poder seguir aprovechando el asistente mientras acotas el impacto de las vulnerabilidades en ChatGPT.

También te puede interesar:Kim Kardashian Explota Contra ChatGPT tras Suspender sus Exámenes de Derecho: “Me Hace Fallar Siempre”

Directora de operaciones en GptZone. IT, especializada en inteligencia artificial. Me apasiona el desarrollo de soluciones tecnológicas y disfruto compartiendo mi conocimiento a través de contenido educativo. Desde GptZone, mi enfoque está en ayudar a empresas y profesionales a integrar la IA en sus procesos de forma accesible y práctica, siempre buscando simplificar lo complejo para que cualquiera pueda aprovechar el potencial de la tecnología.