¿Te subirías a un coche “autónomo” si supieras que, cuando se confunde, puede levantar el teléfono y pedir ayuda a un humano a miles de kilómetros? La promesa suena a ciencia ficción. Pero el mecanismo real se parece más a un servicio de asistencia en ruta que a la magia.

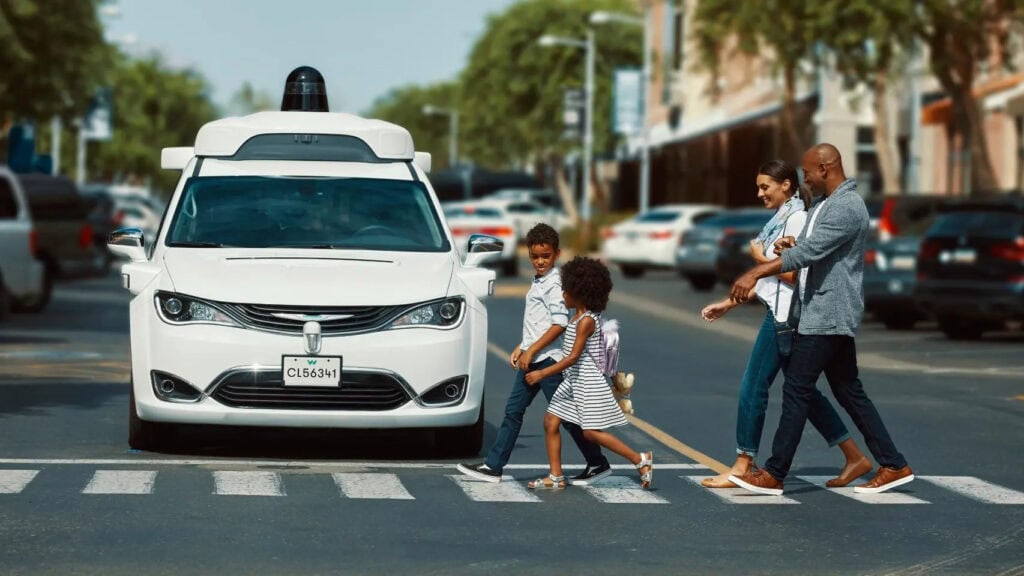

Eso fue lo que reveló Waymo, la filial de Alphabet dedicada a la conducción autónoma, durante una audiencia en el Senado de Estados Unidos sobre riesgos y regulación. El detonante fue una seguidilla de incidentes públicos, incluido el atropello de un niño cerca de un colegio.

En esa comparecencia, Mauricio Peña, director de seguridad de Waymo, explicó que cuando un vehículo enfrenta una situación que no puede resolver por sí solo, solicita apoyo de un operador de asistencia remota (un humano que orienta a distancia). También quedó expuesto un dato poco conocido: parte de esos operadores trabaja desde Filipinas, algo que varios senadores criticaron por la falta de transparencia.

Waymo insiste en un matiz que funciona como pieza clave de su defensa: los operadores “proporcionan orientación, pero Waymo siempre se encarga de la conducción”. Es decir, no sería un joystick que gira el volante. Sería, en teoría, una voz que sugiere una salida cuando aparece un corte de calle o una escena rara.

Sin embargo, el hallazgo abre una pregunta central: si existe un canal humano externo, también existe un nuevo cableado que puede fallar, ser atacado o malinterpretarse. Y en seguridad, cada engranaje extra cuenta.

La analogía más clara es la de un ascensor “inteligente”. Puede tener sensores, cámaras y un cerebro digital. Pero si un día se queda trabado entre pisos, alguien en una central lo “rescata” con instrucciones, reinicios y decisiones rápidas. No cambia el hecho de que el ascensor se mueva solo casi siempre. Cambia la idea de que no hay nadie detrás.

También te puede interesar:Waymo Prueba Gemini Como Asistente de IA a Bordo de sus RobotaxisCon los coches autónomos pasa algo parecido. Su “autonomía” se apoya en tres tareas: percepción (ver), planificación (decidir) y actuación (ejecutar). Y, como subraya la investigadora Missy Cummings, directora del Centro de Autonomía y Robótica de la Universidad George Mason, el mayor malentendido es creer que estos sistemas son realmente autónomos.

La clave es que el mundo real es desordenado. Una obra improvisada, un peatón indeciso, un patrullero mal estacionado. Para un humano, suele ser intuición. Para una máquina, es estadística contra el caos.

Además del operador remoto, existe otro ejército invisible: los etiquetadores de datos (personas que marcan a mano lo que la máquina debe aprender). En automoción, hay equipos que delinean carriles, identifican peatones, señalan bicis, semáforos y situaciones límite en millones de imágenes.

También trabajan sobre datos de LIDAR (pulsos de láser para medir distancias), que producen “nubes” de puntos 3D. Es información valiosa, pero no se interpreta sola. Necesita ojos humanos que ordenen el mapa y lo conviertan en lecciones.

Este trabajo suele ser repetitivo y se terceriza a países con salarios bajos, pagándose por hora o por tarea. Y no solo alimenta el entrenamiento inicial: también revisa incidentes, analiza errores y fabrica ejemplos nuevos cada vez que el sistema falla. Por eso, la idea de un Nivel 5 de autonomía (conducción total sin supervisión humana) todavía aparece lejos en ciudades complejas.

El caso Waymo encaja en un fenómeno más amplio: el “trabajo fantasma”, mano de obra oculta que permite vender automatización como si no hubiera humanos en la retaguardia. Esa misma lógica sostiene a modelos de IA como ChatGPT, donde el etiquetado (corrección y clasificación) y la moderación (filtrar violencia, sexo, odio) funcionan como un interruptor de seguridad.

También te puede interesar:NHTSA Investiga a Waymo por Robotaxis en Contravía y Riesgos para PeatonesUna investigación de Time expuso que OpenAI subcontrató a Sama en Kenia para clasificar contenidos extremadamente violentos, con denuncias de daños psicológicos. Y la periodista Karen Hao, autora de “El imperio de la IA”, advierte que esta opacidad alimenta el mito de la “magia”: sistemas que parecerían volverse inteligentes solos, cuando en realidad aprenden con reglas humanas, a veces a un costo humano alto.

Para el público, la aplicación práctica es directa. Primero, exigir claridad: si un servicio usa asistencia remota, debería decirlo. Segundo, entender límites: “autónomo” no siempre significa “sin humanos”. Tercero, empujar regulación: condiciones laborales, auditorías de seguridad y trazabilidad de quién interviene y cuándo.

Al final, la tercera ley de Arthur C. Clarke ayuda a poner las cosas en su lugar: lo que parece magia suele ser trabajo oculto. Y nombrarlo es el primer paso para que ese engranaje sea más seguro, más justo y menos invisible.

Directora de operaciones en GptZone. IT, especializada en inteligencia artificial. Me apasiona el desarrollo de soluciones tecnológicas y disfruto compartiendo mi conocimiento a través de contenido educativo. Desde GptZone, mi enfoque está en ayudar a empresas y profesionales a integrar la IA en sus procesos de forma accesible y práctica, siempre buscando simplificar lo complejo para que cualquiera pueda aprovechar el potencial de la tecnología.