La empresa de inteligencia artificial Anthropic, conocida por el desarrollo de su modelo Claude, ha dado un paso poco común en la industria tecnológica: crear un sistema capaz de detectar conversaciones relacionadas con armas nucleares.

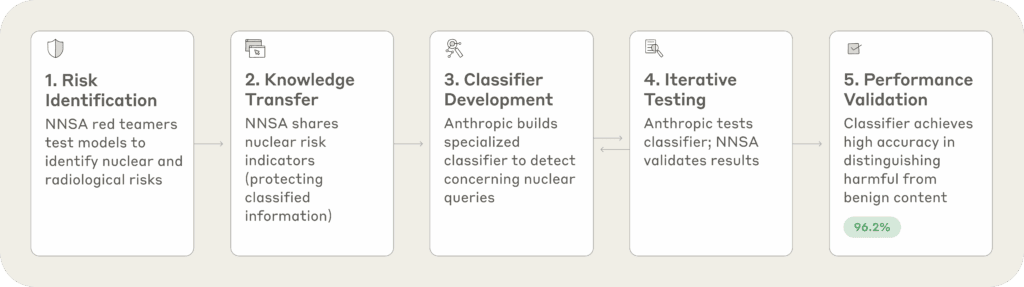

La compañía anunció la medida en una publicación oficial en la que detalló los avances logrados junto al Departamento de Energía de Estados Unidos (DOE) y la Administración Nacional de Seguridad Nuclear (NNSA). El objetivo declarado es evitar que la IA se convierta en una herramienta para la proliferación de armas de destrucción masiva.

El proyecto se materializa en un clasificador automático, un sistema de inteligencia artificial diseñado para distinguir conversaciones legítimas sobre energía o medicina nuclear de aquellas con potencial malicioso, relacionadas con el desarrollo de armamento.

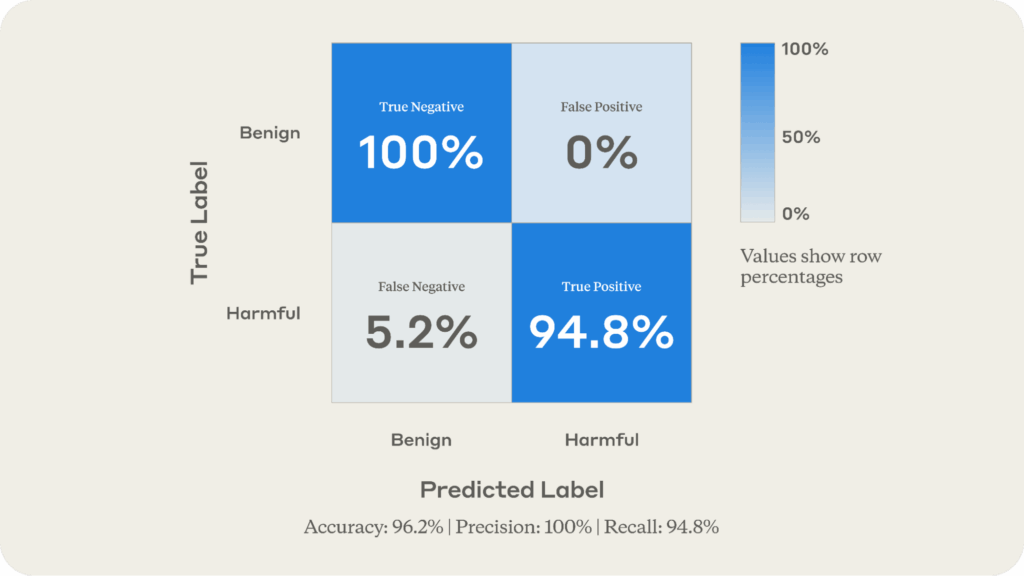

Según Anthropic, las pruebas iniciales muestran una precisión del 96%, un dato significativo si se considera que este tipo de diálogos son poco frecuentes pero de enorme riesgo.

La clave del problema radica en la naturaleza dual de la tecnología nuclear. Los mismos principios físicos que hacen funcionar un reactor pueden ser empleados para fabricar un arma nuclear. En este sentido, Anthropic reconoce que la frontera entre lo legítimo y lo peligroso es muy estrecha.

Una IA demasiado restrictiva podría bloquear información útil para estudiantes de ingeniería nuclear o para investigaciones médicas. Una demasiado permisiva, en cambio, podría facilitar que actores malintencionados utilicen el modelo para obtener conocimiento sensible.

También te puede interesar:Anthropic Resuelve la Demanda por Piratería de Libros y Esquiva un Juicio que podía Marcar PrecedentePor ello, el DOE y la NNSA trabajaron junto a los ingenieros de Anthropic para definir un listado de indicadores de riesgo nuclear que sirvieran de referencia al sistema. Este enfoque se probó mediante datos sintéticos —prompts creados artificialmente para simular escenarios reales— con el fin de garantizar la seguridad sin exponer información clasificada ni comprometer la privacidad de los usuarios.

El sistema actúa de manera similar a un filtro de correo no deseado. Mientras que un “spam filter” detecta correos fraudulentos o publicitarios, este clasificador etiqueta conversaciones nucleares como benignas o preocupantes en tiempo real. Los resultados iniciales fueron alentadores:

Anthropic señala que el sistema ya se encuentra desplegado en Claude, su modelo de IA, y que se ha probado en tráfico real. Aunque surgieron algunos falsos positivos en conversaciones relacionadas con eventos geopolíticos recientes, estos fueron corregidos gracias a la integración con otras capas de seguridad.

Uno de los aspectos más relevantes de este anuncio es el modelo de cooperación. Anthropic destaca que el mayor desafío no fue técnico, sino institucional: cómo validar un sistema de seguridad sin compartir información clasificada por parte del gobierno y sin exponer datos sensibles de los usuarios. La solución pasó por generar datos sintéticos que sirvieran como base para entrenar y evaluar el clasificador.

Este enfoque, según la empresa, demuestra que es posible establecer alianzas público-privadas que refuercen la seguridad nacional sin vulnerar derechos individuales.

También te puede interesar:Claude AI se Integra en Chrome y Promete Cambiar la Manera en que Buscamos en InternetLa iniciativa se enmarca dentro de un esfuerzo más amplio para fijar estándares de seguridad en modelos de frontera, coordinados con foros como el Frontier Model Forum, donde participan también compañías como OpenAI, Google DeepMind y Microsoft.

La noticia se da en paralelo con otro movimiento estratégico: Anthropic anunció que ofrecerá Claude a todas las agencias federales por un costo simbólico de 1 dólar, replicando una acción previa de OpenAI. Este gesto busca posicionar a la empresa como un actor clave en el ecosistema de IA gubernamental, reforzando la narrativa de “compañía responsable” que promueve.

Aunque el proyecto puede considerarse un avance, también plantea preguntas críticas. ¿Quién define qué conversaciones son “preocupantes”? ¿Hasta qué punto puede un sistema privado, aunque colabore con el gobierno, decidir sobre la legitimidad de un diálogo académico, científico o periodístico?

El propio informe de Anthropic reconoce que hubo errores de clasificación en contextos de actualidad internacional, lo que deja ver que la línea entre seguridad y censura puede ser difusa.

Además, algunos expertos en seguridad digital advierten que la efectividad de un sistema de este tipo depende tanto de su precisión como de su transparencia. Si la herramienta se convierte en un estándar industrial sin suficiente supervisión externa, podría abrir la puerta a abusos, especialmente en países donde la censura es común.

La apuesta de Anthropic representa uno de los primeros intentos formales de establecer “salvaguardas nucleares” en sistemas de IA, un terreno que hasta ahora había sido explorado solo en foros académicos o en estudios teóricos.

El hecho de que se haya implementado y probado en un modelo comercial como Claude marca un precedente que probablemente inspire —o presione— a otros desarrolladores de IA a seguir un camino similar.

Sin embargo, la efectividad real del sistema solo se podrá medir en el tiempo y bajo condiciones reales de amenaza. La compañía ha dejado claro que el clasificador seguirá en fase experimental, sujeto a ajustes y a evaluaciones conjuntas con las autoridades.

El desarrollo de este clasificador refleja tanto la maduración de la industria de la inteligencia artificial como la creciente preocupación por sus riesgos de seguridad nacional. Anthropic ha demostrado que es posible construir herramientas para reducir los peligros de la proliferación nuclear en la era de la IA, pero también ha abierto un debate sobre los límites del control privado en temas de interés público.

La iniciativa puede ser vista como un paso hacia una IA más responsable y segura, aunque el riesgo de sobrecensura, malinterpretación o uso político sigue latente. Lo cierto es que la discusión sobre qué papel deben jugar las empresas de IA en la seguridad global apenas comienza, y el clasificador de Anthropic será un punto de referencia inevitable en esa conversación.

Me dedico al SEO y la monetización con proyectos propios desde 2019. Un friki de las nuevas tecnologías desde que tengo uso de razón.

Estoy loco por la Inteligencia Artificial y la automatización.