Nvidia ha salido al CES con una idea muy clara: si la IA va a devorar computación como si no hubiese mañana, su nueva arquitectura Rubin quiere ser el plato principal. Jensen Huang no la presentó como “una mejora”, sino como el nuevo estado del arte en hardware para inteligencia artificial, con cifras que apuntan directamente al gran cuello de botella de 2026 y más allá.

En concreto, Rubin ya está en producción y Nvidia espera acelerar el ramp up durante la segunda mitad del año, aunque “estar en producción” no significa que mañana vaya a aparecer en cualquier nube como si fuese un simple cambio de instancia. Aquí hablamos de una transición de plataforma completa, con proveedores cloud, laboratorios y centros de datos, ajustando electricidad, refrigeración y logística como si fuese una operación militar.

Rubin sustituirá a Blackwell, que a su vez reemplazó a Hopper y Lovelace, confirmando un ritmo de iteración que ya es marca de la casa. Anunciada por primera vez en 2024, Rubin representa la siguiente vuelta de ese ciclo agresivo de desarrollo que Nvidia ha convertido en su mayor ventaja competitiva.

Mientras otros fabricantes tardan años en “madurar” una familia de chips, Nvidia encadena generaciones casi como si fueran actualizaciones de software. Ese ritmo, con bastante veneno debajo, explica en parte por qué la compañía ha llegado a convertirse en la corporación más valiosa del mundo.

Claro que cuando dominas el suministro de “picos y palas” de la fiebre del oro de la IA, el mercado te pone en un pedestal… hasta que fallas una entrega.

Los chips Rubin ya están previstos para su uso por prácticamente todos los grandes proveedores de nube. Nvidia mencionó acuerdos y colaboraciones con OpenAI, Anthropic y Amazon Web Services, lo que indica que Rubin no es un experimento ni un prototipo, es la autopista por la que quieren correr los modelos grandes en el próximo ciclo.

A eso se suma el salto al HPC de primera división. Sistemas basados en Rubin se utilizarán en el superordenador Blue Lion de HPE y también en el futuro Doudna del Lawrence Berkeley National Lab, lo que deja claro que esto no va solo de chatbots, sino también de ciencia dura, simulación, investigación y cargas que viven pegadas al límite de memoria y comunicación.

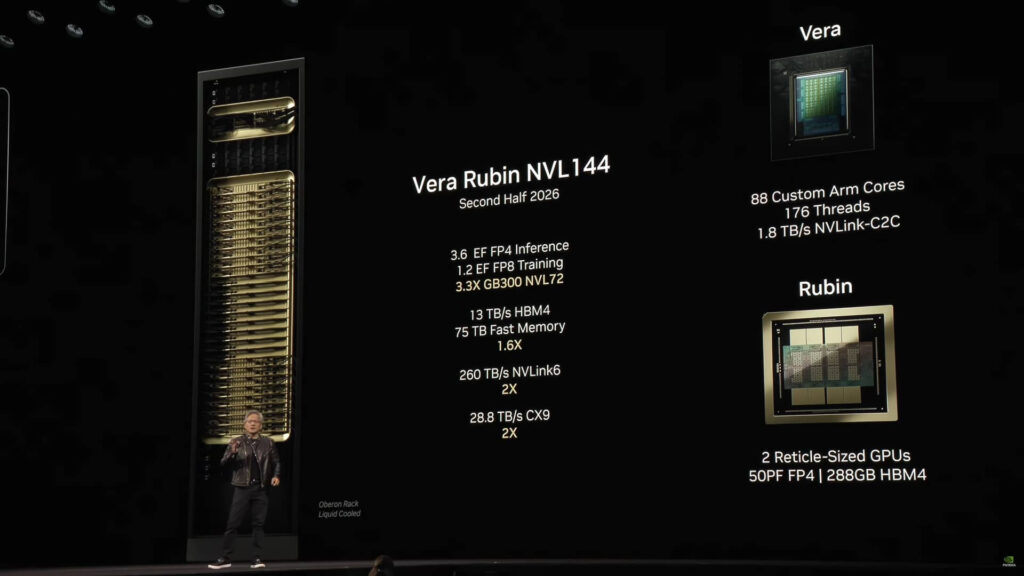

Rubin no se vende como “una GPU más rápida”, sino como una arquitectura completa compuesta por seis chips diseñados para funcionar como un sistema integrado. La pieza central es la GPU Rubin, pero el conjunto incluye CPU, redes, interconexión y cambios relevantes en almacenamiento.

Y si llevas tiempo siguiendo la industria, sabes que el rendimiento real ya no depende solo de FLOPS. El problema moderno está en mover datos: memoria, cachés, redes internas, redes entre nodos y almacenamiento. Por eso Rubin intenta aliviar cuellos de botella crecientes con mejoras en BlueField para almacenamiento y en NVLink para interconexión. La idea es clara: la GPU puede ser un monstruo, pero si el resto del sistema no la alimenta con baja latencia, se queda esperando mientras tú quemas dinero en vatios.

Nvidia también anunció una nueva CPU llamada Vera, orientada específicamente a razonamiento agéntico. Dion Harris, director sénior de soluciones de infraestructura de IA de la compañía, puso el foco en un problema que muchos ya están sufriendo: el crecimiento descontrolado de las demandas de memoria por culpa de la caché.

Flujos de trabajo como la IA agéntica y las tareas de larga duración aprietan cada vez más los requisitos de la caché KV, ese sistema que permite a los modelos “recordar” contexto sin recalcularlo todo. Cuanto más contexto, más herramientas, más pasos y más tiempo “pensando”, más crece esa caché y más se dispara el consumo de memoria.

Para atacar ese límite, Nvidia introduce un nuevo nivel de almacenamiento conectado externamente al dispositivo de cómputo, con la idea de escalar el pool de memoria de forma más eficiente. Traducido: si no cabe en HBM, te añado un escalón más para que el sistema no se ahogue cuando el contexto se vuelve gigante.

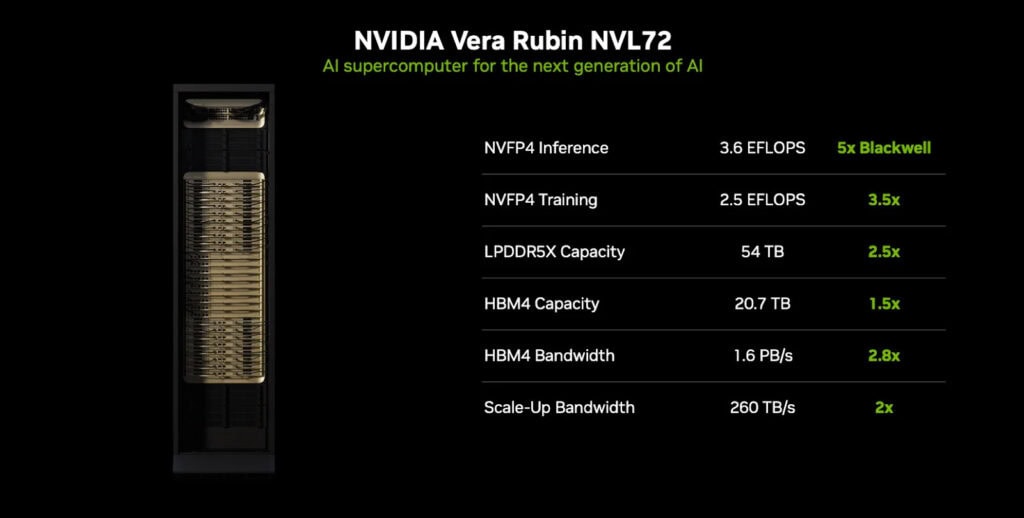

Aquí es donde Nvidia saca el megáfono. Según pruebas internas, Rubin sería 3,5 veces más rápida que Blackwell en entrenamiento, una mejora que puede cambiar calendarios de investigación y convertir semanas de cómputo en días, siempre que el resto del stack acompañe.

En inferencia, Nvidia afirma que Rubin sería cinco veces más rápida que Blackwell, justo en la parte donde está el negocio masivo: servir millones de prompts, agentes y llamadas a herramientas con latencias aceptables. A eso se suma una cifra que ya casi no sorprende, pero sigue impresionando: hasta 50 petaflops y ocho veces más cómputo de inferencia por vatio.

El mensaje es directo: no se trata solo de correr más rápido, sino de hacerlo sin que el centro de datos arda… ni tu factura eléctrica.

Todo esto llega en plena carrera por construir infraestructura de IA, con laboratorios y nubes compitiendo no solo por chips, sino por instalaciones capaces de alimentarlos. En una llamada de resultados en octubre de 2025, Huang estimó que se gastarán entre 3 y 4 billones de dólares en infraestructura de IA durante los próximos cinco años.

No es una moda pasajera, es una reindustrialización del compute, con centros de datos funcionando como las nuevas fábricas. Pero esa cifra también implica tensión: suministro, energía, permisos, redes eléctricas, agua y el clásico “en esta zona ya no caben más racks”.

Rubin no es solo un chip, es la apuesta de Nvidia por seguir siendo el embudo por el que pasa esa inversión gigantesca. Si cumple lo prometido y el ramp up va en serio, veremos una nueva oleada de modelos más grandes, más persistentes y más agénticos. La pregunta incómoda queda flotando: ¿quién se queda fuera cuando todos quieren lo mismo al mismo tiempo?

Tocará esperar para ver si la competencia responde… y, sobre todo, si la infraestructura del mundo real puede seguir el ritmo de la IA que Nvidia está empujando.

Me dedico al SEO y la monetización con proyectos propios desde 2019. Un friki de las nuevas tecnologías desde que tengo uso de razón.

Estoy loco por la Inteligencia Artificial y la automatización.