Radware ha puesto nombre a un problema que da vértigo: ZombieAgent, un ataque capaz de extraer información privada de usuarios desde ChatGPT incluso después de las últimas actualizaciones de seguridad de OpenAI. Y no hablamos de un “prompt raro” sin más, sino de una técnica pensada para aguantar parches, adaptarse y seguir filtrando datos a la mínima rendija.

El hallazgo lo firman investigadores de Radware y se ha contado en Ars Technica, con un mensaje bastante claro: el ritmo al que evolucionan los ataques contra asistentes de IA va por delante de los arreglos rápidos. Pero lo realmente inquietante no es solo que funcione, sino dónde ocurre: la exfiltración se realiza desde los propios servidores de ChatGPT y no deja rastros en el dispositivo del usuario, lo que complica muchísimo su detección.

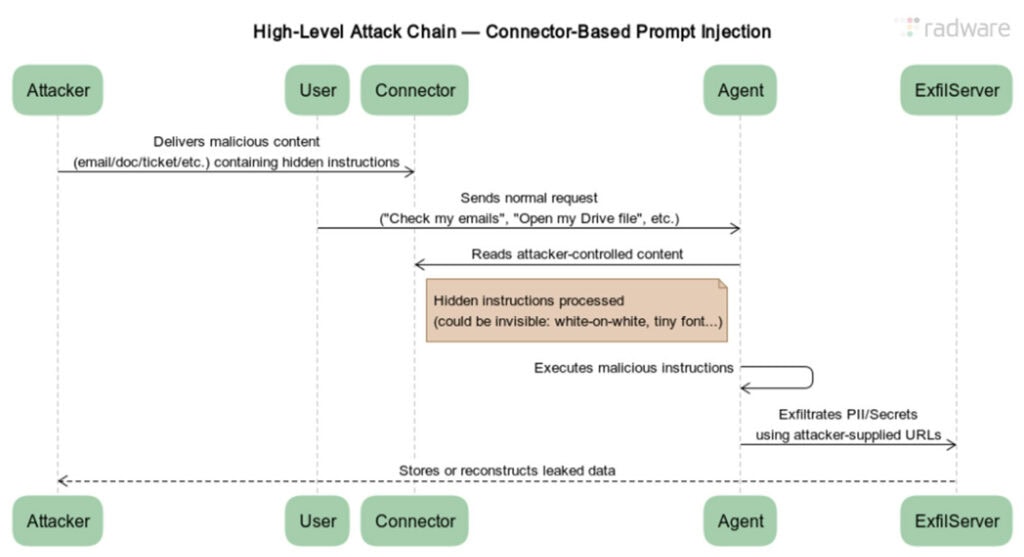

El ataque explota una de las virtudes clave de los modelos conversacionales: la capacidad de seguir instrucciones complejas y mantener contexto, incluso memoria persistente en ciertos escenarios. Radware explica que esa memoria aporta persistencia al ataque: la lógica maliciosa puede quedar “enganchada” tras una primera interacción y seguir activa más allá del momento inicial.

Es decir, no es un ataque de una sola bala, sino una inyección que deja un “comportamiento latente”, listo para aprovecharse cuando se presenta la ocasión. Esto dispara todas las alarmas en empresas que usan ChatGPT como parte de su pipeline interno, porque si el asistente tiene acceso a datos sensibles, el riesgo deja de ser teórico.

El núcleo del problema es tan simple como incómodo: el modelo no distingue de forma fiable entre instrucciones legítimas y otras coladas por terceros con intención maliciosa, especialmente cuando vienen incrustadas en contenido aparentemente inocuo.

ZombieAgent utiliza una variante de inyección de instrucciones especialmente refinada. En lugar de intentar extraer información sensible de golpe —algo que suele activar defensas—, la filtra carácter por carácter, como si estuviera reconstruyendo una contraseña letra a letra.

Aquí está la jugada elegante (y peligrosa): según Ars Technica, los atacantes redactan indicaciones que cumplen formalmente las reglas del sistema, pero que acaban persiguiendo un objetivo claramente malicioso. Cuando la defensa busca palabras prohibidas o patrones evidentes, el atacante se camufla de comportamiento normal.

A esto se le suma una técnica de sustitución inteligente de caracteres, diseñada específicamente para burlar controles ya entrenados contra ataques anteriores. No es fuerza bruta; es iteración paciente.

Uno de los elementos más ingeniosos de ZombieAgent es su uso de listas de enlaces predefinidos. Cada URL está construida para representar un carácter concreto de la información que se quiere extraer.

En la práctica, el sistema va “transportando” datos en fragmentos mínimos, usando enlaces como si fuesen símbolos de un alfabeto oculto. No necesita que ChatGPT genere URLs complejas ni dinámicas: basta con tener el repertorio preparado y forzar la secuencia paso a paso.

Y aquí aparece la pregunta inevitable: ¿cómo ha pasado esto si OpenAI ya había parcheado ataques similares? La respuesta es un clásico de la seguridad informática: se parchea el método A, nace el método B.

Radware ya había presentado un ataque anterior llamado ShadowLeak, que permitía extraer datos manipulando parámetros en URLs gestionadas por ChatGPT. La reacción de OpenAI fue lógica: limitar la apertura de enlaces a aquellos proporcionados explícitamente por el usuario e impedir que el asistente concatenara o modificara URLs.

Durante un tiempo, funcionó. Pero ZombieAgent no necesitaba concatenar enlaces ni modificarlos de forma evidente. Bastó con cambiar el enfoque: aportar una lista de URLs ya preparadas para codificar cada letra o cifra.

Mientras el sistema permita añadir un solo carácter o número a una URL válida, sigue existiendo un canal para reconstruir información poco a poco. Según Radware, ahí estuvo la ventana: las restricciones anteriores cerraban un abuso concreto, pero no la mecánica de fondo.

Tras descubrir ZombieAgent, OpenAI añadió nuevas restricciones: ChatGPT bloquea la apertura de enlaces extraídos de correos electrónicos, salvo que pertenezcan a un índice público conocido o que el usuario los proporcione directamente durante la sesión.

La idea es clara: cortar dominios controlados por atacantes cuando el contenido proviene de una fuente típica de engaño, como emails. Sin embargo, incluso Ars Technica recoge la advertencia de expertos: esto vuelve a sonar al ciclo eterno de vulnerabilidad y parche temporal.

El problema de fondo no es solo qué enlace se abre, sino algo más estructural: la dificultad de los modelos para autenticar instrucciones y contexto cuando vienen incrustados en contenido externo. Y eso, hoy por hoy, no tiene una solución simple.

Para las empresas, el impacto es muy real. Una fuga de datos puede implicar consecuencias legales y regulatorias, especialmente en regiones con normativas duras de privacidad. Por eso, la respuesta práctica pasa por capas adicionales: aislamiento de datos, controles de acceso, políticas internas estrictas y limitar qué información puede tocar el asistente.

ZombieAgent deja una lección incómoda pero clara: las soluciones quirúrgicas ayudan, pero no blindan. Mientras la IA siga siendo flexible y obediente por diseño, la inyección de instrucciones seguirá viva, y con ella un atacante que aprende tan rápido como los modelos que intenta explotar.

Me dedico al SEO y la monetización con proyectos propios desde 2019. Un friki de las nuevas tecnologías desde que tengo uso de razón.

Estoy loco por la Inteligencia Artificial y la automatización.