Google acaba de convertir Chrome en algo más que un simple navegador: ahora quiere que sea un copiloto inteligente capaz de entender tus pestañas, interactuar con tus fotos y, si le das permiso, incluso comprar por ti mediante funciones como auto-browse.

Tras la oleada de “navegadores con IA” impulsados por OpenAI, Perplexity, Opera o The Browser Company, Google ha decidido jugar su carta más fuerte: integrar la IA directamente donde ya navega medio planeta.

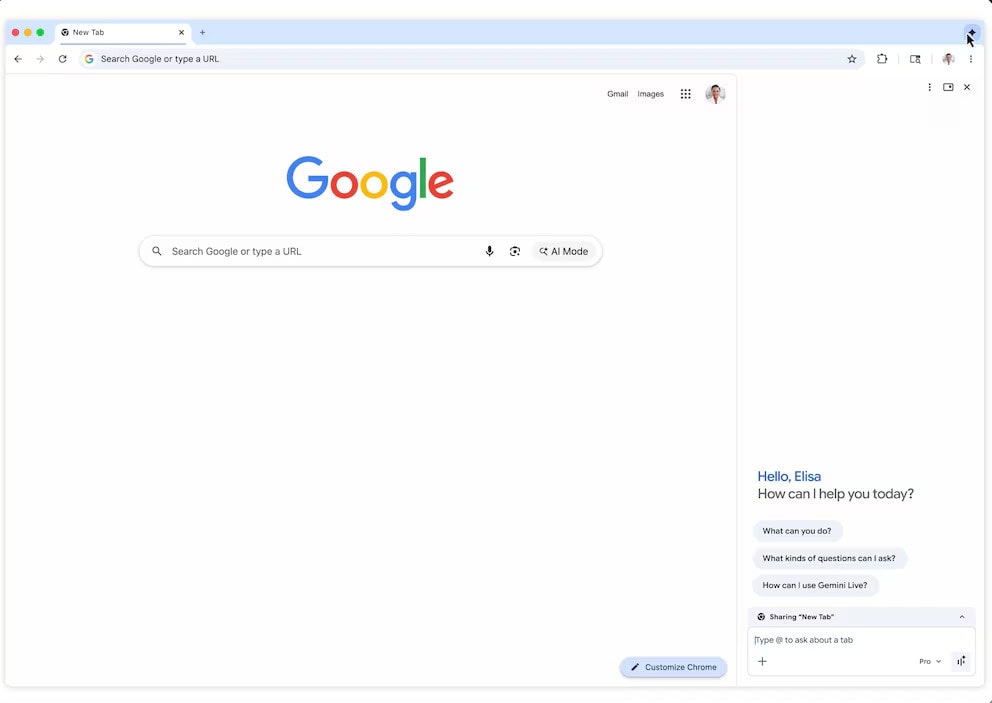

El cambio más visible llega con Gemini, que deja de ser una ventanita flotante —como lo era desde septiembre— para convertirse en una barra lateral persistente dentro de Chrome. Ya no se trata de “abrir el asistente un momento”, sino de tenerlo siempre presente, como si fuera otra columna más del navegador.

La clave no está solo en hacer preguntas sobre la página actual. Desde esta barra lateral, Gemini también puede responder sobre otras pestañas abiertas, algo que parece menor hasta que se usa de verdad. En la práctica, permite cruzar información sin saltar frenéticamente de tab en tab, un escenario muy común cuando se comparan productos o se investiga a fondo.

Este movimiento no surge en el vacío. Durante el último año, varias empresas lanzaron navegadores “nativos de IA” con promesas de automatización, asistentes laterales y flujos de trabajo más rápidos, todos con un objetivo bastante claro: desplazar a Chrome.

Sin embargo, competir contra Chrome no es solo cuestión de mejores prompts o de una interfaz más llamativa. Chrome juega con la ventaja de ser el navegador con mayor cuota de mercado mundial, lo que convierte cualquier nueva función en un despliegue masivo casi por inercia.

También te puede interesar:Chrome Estrena Resúmenes de Tiendas con IA para Comprar con Más Seguridad y Confianza

En la práctica, si Google conecta IA a Chrome, no está probando un producto, sino empujando un estándar de facto que llega a millones de usuarios de forma casi automática.

Google mostró a la prensa una idea que, si funciona como promete, puede ser de las más útiles del conjunto. Cuando abres varias pestañas desde una misma página, la barra lateral de Gemini las interpreta como un grupo contextual.

Esto significa que entiende que esas pestañas no son elementos aislados, sino parte de una misma tarea: comparar, investigar o tomar una decisión. Un caso de uso muy concreto es la comparación de precios o productos antes de comprar, donde el valor real está en sintetizar información dispersa.

Aquí es donde se verá si la IA está bien integrada o si se queda en un chatbot pegado con cinta adhesiva. Si el modelo se confunde entre pestañas o mezcla especificaciones, la ayuda se transforma rápidamente en ruido.

Antes de esta actualización, Gemini en Chrome solo estaba disponible para usuarios de Windows y macOS. Ahora, Google amplía la barra lateral a Chromebook Plus, una señal clara de cómo quiere empujar su ecosistema IA-first dentro de su propio hardware.

Chromebook Plus es un terreno especialmente favorable para este tipo de integración: usuarios muy acostumbrados a los servicios de Google y a flujos de trabajo intensivos en pestañas, donde un asistente contextual puede marcar la diferencia.

También te puede interesar:Perplexity ofrece comprar Chrome en medio de la presión legal contra GoogleMás allá de la barra lateral, lo realmente delicado es lo que viene después. Google planea llevar a Chrome su función de “inteligencia personal”, recientemente lanzada y conectada a Gmail, Search, YouTube y Google Photos.

En este escenario, Gemini ya no solo observa la web, sino que entiende tu contexto personal, tu historial y tus propios contenidos. El ejemplo que propone Google es revelador: preguntar por el calendario familiar o pedirle que redacte y envíe un correo sin salir de la pestaña en la que estás.

La compañía adelanta que estas funciones llegarán en los próximos meses, mediante despliegues progresivos. Sin embargo, aquí surge la pregunta inevitable para muchos usuarios: ¿qué pasa con mis datos?

Chrome también incorporará una integración llamada Nano Banana, pensada para modificar una imagen existente usando otra imagen o un producto encontrado mientras navegas. Es, en esencia, llevar el “edítame esto tomando como referencia aquello” directamente al navegador, donde se toman muchas decisiones visuales de compra.

La verdadera protagonista del anuncio, no obstante, es auto-browse. Google lo presenta como una función “agéntica” capaz de completar tareas de forma autónoma: entrar en una web, buscar un producto, encontrar un cupón y preparar una compra.

Esto supone pasar de navegar a delegar acciones, algo que Google sabe que genera inquietud. Por eso introduce un freno claro: el agente pedirá intervención humana en pasos sensibles, como iniciar sesión o confirmar el pago final.

Google ya había explicado que estas funciones usarán el gestor de contraseñas de Chrome y los datos de tarjetas guardadas, pero que los modelos de IA no tendrán acceso directo a esas credenciales. La idea es una arquitectura con aislamiento, aunque quedará por ver cómo se audita y cómo se comunica sin exceso de jerga técnica.

Aquí aparece el gran obstáculo que todo el sector conoce bien: los agentes basados en navegador todavía son poco fiables. En las demos todo funciona —compras, viajes, reservas—, pero en el mundo real las webs cambian, los formularios se rompen, aparecen captchas y las peticiones de los usuarios suelen ser ambiguas.

Muchos agentes fallan al interpretar la intención o se caen al saltar entre sitios, lo que frena la adopción porque nadie quiere supervisar a una IA más de lo que se supervisa a uno mismo.

Google afirma que, en pruebas tempranas, los usuarios ya lo han usado para programar citas, rellenar formularios tediosos, recopilar documentos fiscales, pedir presupuestos a profesionales y presentar informes de gastos. Son tareas repetitivas y aburridas, justo donde un agente puede brillar si mantiene la fiabilidad.

Por ahora, auto-browse comienza a desplegarse para suscriptores de AI Pro y Ultra en Estados Unidos, una forma elegante de limitar riesgos en la fase inicial. Si todo sale bien, Chrome dejará de ser un simple visor de webs para convertirse en el lugar donde decides y la IA ejecuta.

Si sale regular, el escenario será el de siempre: funciones espectaculares en la keynote y usuarios desactivándolas a la semana. Lo realmente interesante no es si Gemini responde más rápido, sino si Google logra que la automatización sea confiable y no una ruleta.

Porque si el navegador más usado del planeta se convierte en un “agente”, la competencia no podrá quedarse solo en chatbots con barra lateral.

Me dedico al SEO y la monetización con proyectos propios desde 2019. Un friki de las nuevas tecnologías desde que tengo uso de razón.

Estoy loco por la Inteligencia Artificial y la automatización.