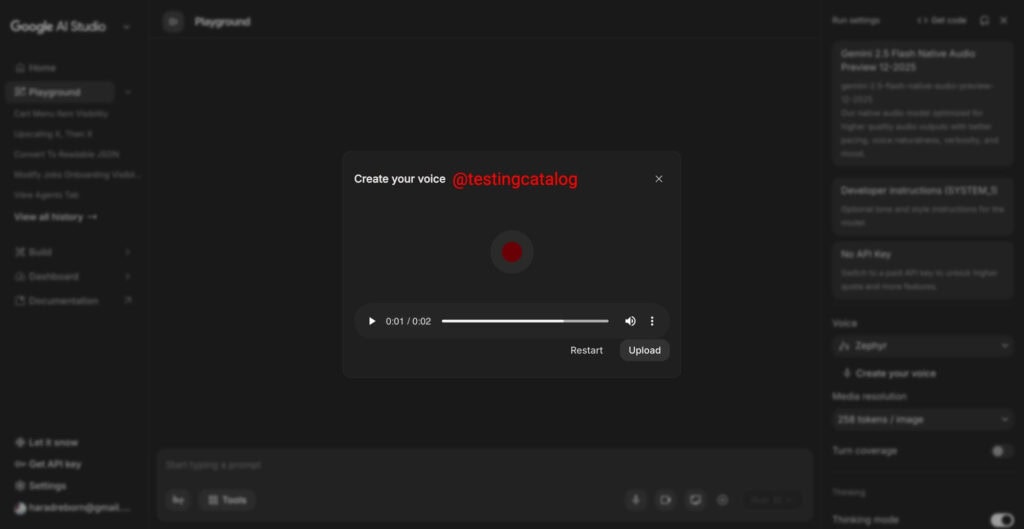

Google está dejando miguitas muy jugosas en AI Studio con una opción oculta llamada “Create Your Voice”, que apunta directamente a la clonación de voz integrada con Gemini. Esta función aparece justo donde importa: al interactuar con el modelo de vista previa Flash native audio preview, actualmente vinculado a Gemini 2.5 Flash, lo que ya ofrece pistas claras sobre su enfoque técnico.

Al seleccionar “Create Your Voice”, se abre una ventana emergente pensada para grabar y subir audio, como si el usuario fuera a “donar” su voz al sistema para entrenar un modelo personalizado. Sin embargo, la función todavía no está activa: el botón existe, el flujo está definido y la interfaz está lista, pero la clonación de voz aún no funciona.

Esto no parece casual, ya que cuando Google muestra una interfaz completa antes de tiempo suele indicar que el backend o el modelo subyacente está en pruebas internas, limitado por permisos o todavía en proceso de ajuste técnico y legal.

El detalle importante no es solo el nombre “Create Your Voice”, sino dónde está integrada la función: dentro de una experiencia de audio nativo. Hablamos de un modo de preview asociado a Flash, que dentro del ecosistema Gemini suele implicar velocidad, baja latencia y costes contenidos de inferencia.

Este enfoque es clave para asistentes que responden por voz en tiempo real, donde no es viable que el sistema tarde varios segundos entre frase y frase. A esto se suma una idea que encaja bien: si Google prepara clonación de voz en este entorno, es porque está trabajando en un modelo de audio nativo más avanzado, posiblemente un futuro Gemini 3 Flash o equivalente.

Aunque esto último no está confirmado, el patrón es conocido: primero aparece el esqueleto de la función, luego se prueba internamente y, finalmente, se libera al público con límites y políticas claras.

También te puede interesar:Google AI Studio se Reinventa con Integración de Jules SWE y Gestión Avanzada en IASi se habilita, los desarrolladores podrían generar una voz sintética basada en una muestra real proporcionada por el usuario. El flujo sería sencillo: se graban unos segundos o minutos de voz, el modelo aprende rasgos, timbre y cadencia, y a partir de ahí la IA puede hablar “como tú” o como una persona autorizada.

Esto eleva la personalización a otro nivel, ya que no se trata de elegir una voz genérica, sino de usar una identidad vocal real. Al mismo tiempo, se abre un debate sensible, porque la clonación de voz es una herramienta potente para accesibilidad y rehabilitación, pero también supone un riesgo serio si se utiliza para suplantación.

Por eso, Google tendrá que aplicar guardarraíles sólidos, como verificación de identidad, consentimiento explícito, marcas de agua en el audio y trazabilidad del uso. Lanzarla sin controles sería peligrosa, mientras que hacerlo con medidas adecuadas podría convertirla en una de las funciones más valiosas de Gemini.

AI Studio no está pensado solo para experimentar con prompts, sino para crear productos reales. En este contexto, la clonación de voz encaja especialmente bien para desarrolladores que construyen asistentes conversacionales, bots de atención al cliente o herramientas de accesibilidad.

Una aplicación podría comunicarse con una voz consistente, personal y reconocible, sin depender de catálogos limitados de voces genéricas. Además, existe un componente emocional importante, ya que para personas con dificultades del habla o en procesos de rehabilitación, recuperar una voz personalizada, bajo un uso ético, puede tener un impacto real.

La clonación de voz no es una tecnología nueva y ya existen plataformas que la ofrecen con buenos resultados. La diferencia aquí es la integración directa dentro del ecosistema de Google, que combina modelos Gemini, AI Studio y herramientas de producto en un solo entorno.

También te puede interesar:Nueva Función "Voy a Tener Suerte" de Google para AI Studio: ¿Qué Sabemos Hasta Ahora?Si la voz clonada se convierte en un asset del proyecto, se puede combinar con prompts, control de estilo y respuestas multimodales sin fricciones. El resultado es un flujo más limpio: registras la voz, llamas al modelo nativo de audio y despliegas, sin depender de múltiples servicios externos.

Para equipos pequeños, esto supone menos complejidad técnica, menor latencia y mayor control desde un único panel.

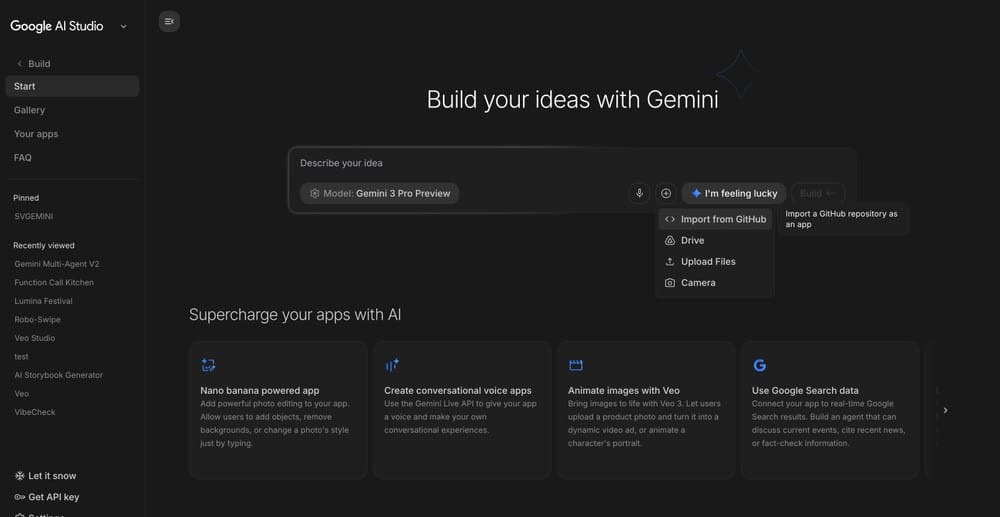

Otra señal relevante es la aparición de “Import from GitHub” dentro del apartado de construcción de proyectos. La función sugiere la posibilidad de importar repositorios completos y convertirlos en proyectos funcionales dentro de AI Studio, lo que marcaría el paso definitivo de demos experimentales a integración con aplicaciones reales.

Aun así, quedan preguntas abiertas sobre frameworks compatibles, gestión de dependencias, soporte para monorepos y tratamiento de secretos. Sin esos detalles, la función puede ser revolucionaria o quedarse en una demostración atractiva sin uso real, aunque todo apunta a un objetivo claro: AI Studio como plataforma de desarrollo end-to-end.

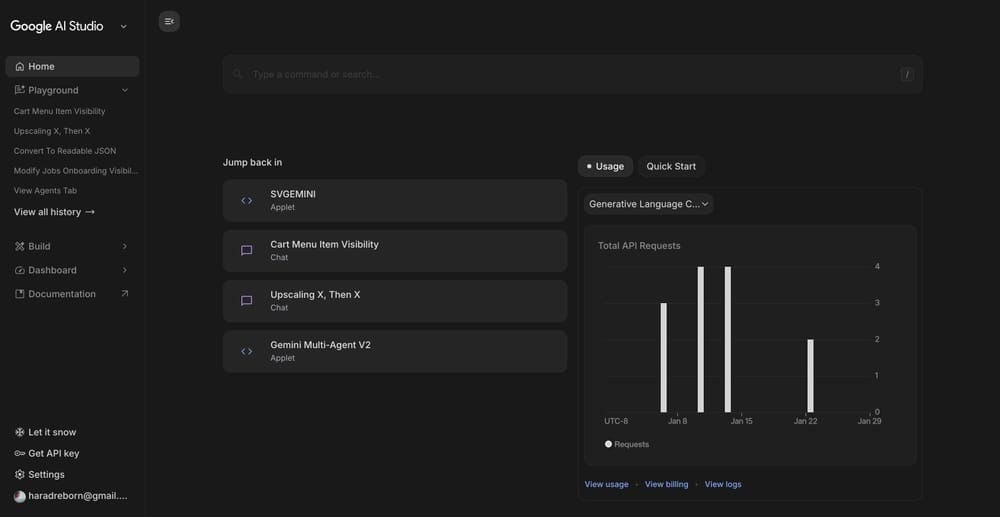

Incluso la página de inicio está cambiando, con una separación más clara entre métricas de uso, resúmenes de actividad y paneles orientados al seguimiento. Este tipo de ajustes suele indicar que la plataforma ya no piensa solo en usuarios curiosos, sino en equipos que necesitan control y visibilidad.

Por ahora, no hay fechas oficiales para la clonación de voz ni para la importación desde GitHub, pero el ritmo de cambios sugiere que estas funciones podrían activarse en cuanto alcancen la estabilidad necesaria. La sensación general es clara: Google quiere que AI Studio sea el lugar donde construyes, pruebas y despliegas con Gemini sin salir del ecosistema.

Me dedico al SEO y la monetización con proyectos propios desde 2019. Un friki de las nuevas tecnologías desde que tengo uso de razón.

Estoy loco por la Inteligencia Artificial y la automatización.