Google ha empezado a retirar sus AI Overviews (resúmenes generados por IA en la Búsqueda) en consultas médicas sobre tests hepáticos, después de que The Guardian detectara respuestas potencialmente engañosas.

Hablamos de salud, un terreno donde una cifra casi correcta no es un simple matiz técnico, sino una mala decisión esperando a ocurrir.

The Guardian señaló la consulta “what is the normal range for liver blood tests” como un ejemplo de cómo un resumen de IA puede transmitir una falsa sensación de seguridad. Según el medio, el Overview mostraba rangos de referencia sin contemplar variables clínicas básicas como la edad, el sexo, la etnia o la nacionalidad.

Estos factores no son un detalle accesorio: el rango “normal” de muchos marcadores hepáticos cambia según el contexto del paciente. Simplificarlo a una cifra universal puede llevar a que alguien piense que su analítica está bien cuando, en realidad, no lo está.

El diario británico afirma que Google retiró los AI Overviews tanto para “what is the normal range for liver blood tests” como para “what is the normal range for liver function tests”. Se trata de búsquedas muy habituales, realizadas por personas preocupadas que, con un informe de laboratorio en la mano, intentan interpretar resultados antes de hablar con un médico.

Aquí aparece el matiz clave: The Guardian comprobó que variaciones como “lft reference range” o “lft test reference range” seguían activando resúmenes de IA en un primer momento. Si basta con reformular la pregunta para que vuelva la respuesta automática, la retirada parece más un parche puntual que una solución estructural.

También te puede interesar:Google Pone en Riesgo a los Usuarios al Minimizar Avisos de Salud en AI OverviewsNo obstante, el autor que replica la noticia señala que, varias horas después de publicarse el artículo del Guardian, probó esas mismas búsquedas y ya no obtuvo AI Overviews en ninguno de los casos. Esto sugiere que Google aplicó un ajuste más amplio que la simple eliminación de dos consultas concretas.

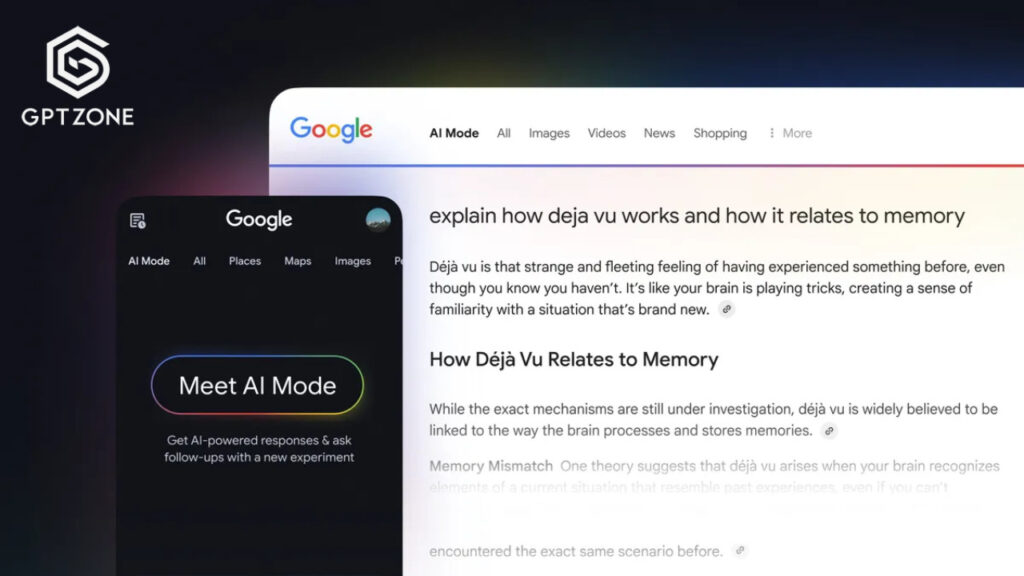

Aun así, la retirada no implica que Google deje de impulsar su experiencia generativa. Incluso cuando no aparecía el Overview en la página principal, el buscador seguía ofreciendo la opción de repetir la consulta en “AI Mode”. Es decir, no muestra el resumen por defecto, pero permite acceder a respuestas generadas por otra vía, con el mismo riesgo de resultar convincentes aunque incompletas.

A esto se suma un detalle casi irónico: en varios casos, el primer resultado orgánico para estas búsquedas era el propio artículo de The Guardian que denunciaba la retirada. El SEO, una vez más, mostrando su particular sentido del humor.

Un portavoz de Google declaró a The Guardian que la compañía no “comenta retiradas individuales dentro de Search”. Reconocer un caso específico puede sentar precedente, y a Google no le faltan frentes abiertos relacionados con la IA.

La empresa asegura que está trabajando en “mejoras amplias”, una formulación habitual que deja muchas preguntas abiertas: qué cambia exactamente, cómo se valida y qué mecanismos evitan que el problema se repita.

El portavoz añadió que un equipo interno de clínicos revisó las consultas destacadas por The Guardian, lo que confirma una sospecha extendida: cuando hay presión pública, entra en juego la revisión humana. Google también sostiene que, en muchos casos, la información revisada “no era inexacta” y estaba respaldada por webs de alta calidad.

El problema no siempre es la fuente, sino la síntesis. Una cosa es que la literatura médica sea correcta y otra muy distinta que un resumen sea seguro para un usuario real que busca una respuesta rápida a “¿estoy bien o no?”, no un marco académico completo.

En paralelo, TechCrunch indicó que contactó con Google para obtener comentarios adicionales. Cuanto más crece el producto de AI Overviews, más necesario resulta saber dónde están las líneas rojas y quién decide cuándo se cruzan.

El año pasado, Google anunció nuevas funciones para mejorar Search en usos sanitarios, incluidas “mejores panorámicas” y modelos de IA centrados en salud. El objetivo es legítimo: ayudar a navegar información médica de calidad en un entorno saturado de foros, blogs y consejos poco fiables.

Sin embargo, el salto entre “ordenar información” y “dar una respuesta directa” es enorme. Un buscador que lista fuentes obliga al usuario a contrastar; un resumen que ofrece un rango “normal” invita a cerrar la pestaña y respirar tranquilo.

Vanessa Hebditch, directora de comunicación y políticas del British Liver Trust, calificó la retirada como “una excelente noticia”. Para muchas organizaciones de pacientes, el mayor riesgo no es el error evidente, sino el error sutil que pasa desapercibido.

Hebditch también lanzó una advertencia clave: su preocupación es que se esté afinando demasiado en un resultado concreto, desactivando Overviews solo en ciertos casos, sin abordar el problema estructural de aplicar resúmenes de IA a temas de salud.

Ese es el punto incómodo. Si la solución consiste en jugar al whack-a-mole con queries individuales, la escala de Google siempre llevará ventaja… hasta que deja de tenerla. La pregunta de fondo no es si la IA puede acertar muchas veces, sino qué ocurre la vez que se equivoca en algo que alguien interpreta como guía clínica.

Tampoco es realista pensar que todo se arregla con un botón de “off” permanente. Google lleva meses impulsando estas experiencias porque aumentan retención, sesiones y la sensación de “respuesta directa”. El incentivo del producto, por definición, va en dirección contraria a la prudencia médica.

Además, aunque un resumen esté respaldado por webs de alta calidad, la medicina real está llena de rangos, excepciones y contexto personal. Precisamente eso es lo más difícil de capturar en un Overview: los matices, los asteriscos y lo que un clínico te diría tras revisar tu historial.

Veremos más retiradas puntuales y ajustes silenciosos, porque la presión pública funciona. Este caso demuestra que la IA en buscadores no se mide solo por benchmarks técnicos, sino por el daño que logra evitar cuando las personas la usan como si fuera un médico de guardia.

Esto es solo el inicio de una tensión prolongada entre ambición de producto y responsabilidad. Queda por ver si Google convierte estas “mejoras amplias” en un estándar real de seguridad o si se quedan en parches rápidos que duran hasta el próximo titular.

Me dedico al SEO y la monetización con proyectos propios desde 2019. Un friki de las nuevas tecnologías desde que tengo uso de razón.

Estoy loco por la Inteligencia Artificial y la automatización.