Donald Trump avisó durante la madrugada del 3 de enero, en Truth Social, que tropas de Estados Unidos habían detenido a Nicolás Maduro y a Cilia Flores, y en cuestión de minutos internet ya estaba “viendo” un arresto que al momento no había ocurrido.

Y es que lo más inquietante fue la rapidez con la que se materializó. TikTok, Instagram y X se llenaron casi de inmediato de supuestas “pruebas visuales”, como si estuviésemos ante una cobertura en directo de un acontecimiento histórico.

Cuando el feed decide que algo “está pasando”, la realidad pasa a un segundo plano y manda el clip más impactante. Da igual si es cierto o no: lo que importa es que encaje con la expectativa del momento.

El origen del caos informativo fue una afirmación pública de Trump: una “operación a gran escala” en Venezuela y un arresto ya consumado. Un mensaje con peso político que, al salir de Truth Social, encontró terreno fértil para replicarse sin freno en otras plataformas.

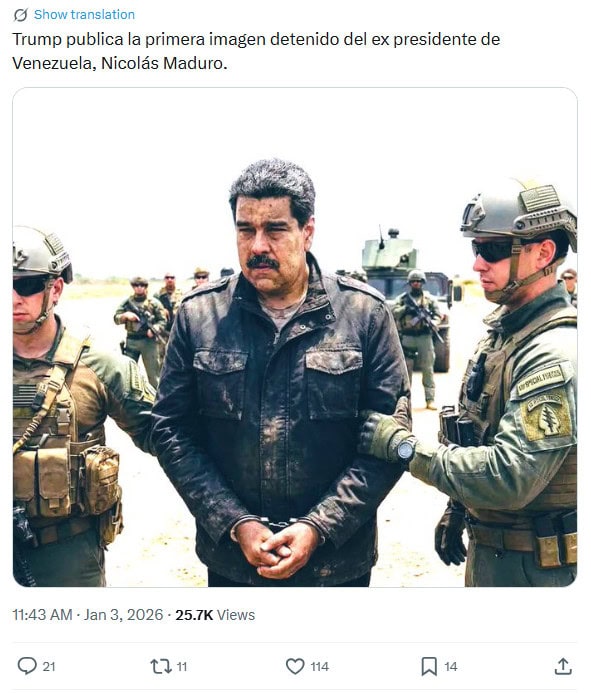

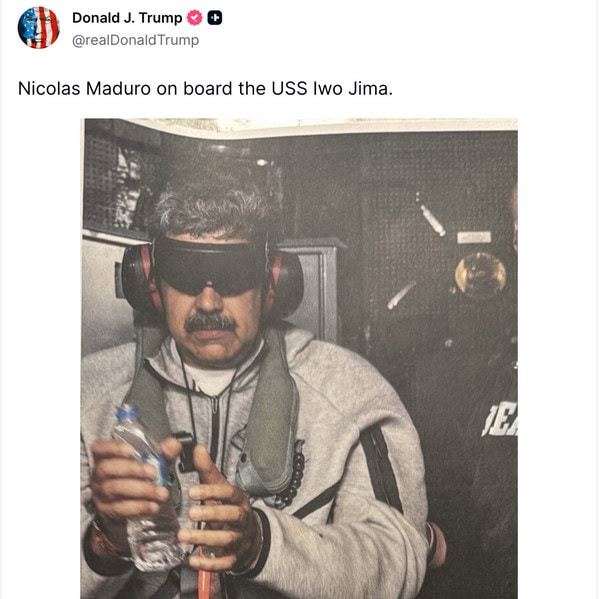

Y es que Truth Social funciona como detonador perfecto: una declaración de autoridad, copiada y pegada en X, Instagram y TikTok, y la reacción en cadena ya no hay quien la pare. El propio Trump llegó a compartir una fotografía del detenido, lo que para muchos usuarios sigue siendo suficiente prueba.

Esa lógica lleva años rota, pero seguimos cayendo en ella porque el cerebro quiere cerrar la historia cuanto antes. El algoritmo, encantado, se encarga del resto.

Uno de los patrones más repetidos fue reutilizar vídeos antiguos y venderlos como si fueran ataques recientes sobre Caracas. Grabaciones de protestas o disturbios de meses, incluso años atrás, reaparecieron con títulos en mayúsculas, música épica y un contexto completamente nuevo.

Este tipo de contenido no necesita ser creíble, solo necesita ser compartible. Muchas cuentas aprovecharon el pico emocional del momento para empujar estas piezas y rascar visualizaciones, seguidores e interacciones.

A esto se suma un factor estructural: la relajación de las políticas de moderación en varias plataformas hace que estas olas de desinformación entren con mucha menos fricción. Si tardas horas en revisar lo que se viraliza en minutos, ya llegas tarde.

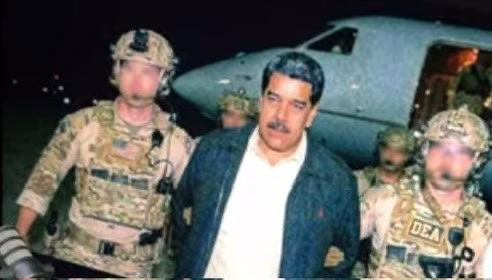

La situación se complicó todavía más cuando empezaron a circular imágenes y vídeos generados con inteligencia artificial que supuestamente mostraban a agentes estadounidenses arrestando a Maduro. Una de las imágenes más compartidas lo mostraba flanqueado por dos agentes, con una estética de foto “robada” que mucha gente dio por buena sin pensarlo demasiado.

No era la típica imagen burda: era lo bastante realista como para que, vista en pantalla pequeña y con prisas, colara. Análisis posteriores confirmaron que era falsa y que había sido generada o alterada con herramientas de IA.

Aquí entra un detalle técnico clave: SynthID, la tecnología de Google DeepMind para detectar contenido generado por IA, identificó una marca de agua digital invisible asociada a herramientas de Google. Incluso tras recortes, recomprasiones o reexportaciones pensadas para hacerla pasar por “nativa”, la huella seguía ahí.

Gemini corroboró ese diagnóstico y señaló que gran parte de la escena había sido creada o editada con IA. El problema es evidente: que exista detección no significa que llegue al usuario a tiempo, ni que esté integrada donde realmente importa, que es en el momento del “publicar” y del “compartir”.

La ironía es que la confusión también afectó a los propios sistemas de IA conversacional. Grok, integrado en X, reconoció que la imagen era falsa, pero añadió un error importante: afirmó que se trataba de una alteración de un arresto de un narcotraficante mexicano en 2017.

Acertó en el “qué” —era falso—, pero falló en el “origen”, justo el tipo de imprecisión que luego se cita como fuente. ChatGPT, por su parte, negó inicialmente que el arresto hubiera ocurrido, y el caso se convirtió en un ejemplo claro de un problema conocido: los modelos sufren con la información de última hora.

No es magia ni maldad, sino un choque entre latencia informativa, verificación y la prudencia de no inventar hechos sin respaldo sólido. Cuando la red está inundada de ruido, lo difícil no es responder rápido, sino responder bien.

A partir de las imágenes falsas, algunos usuarios dieron un paso más y generaron vídeos sintéticos que simulaban el arresto de Maduro. En TikTok, varios de estos clips alcanzaron cientos de miles de visualizaciones en apenas unas horas.

El incentivo es claro: publicas rápido, activas la emoción y el algoritmo te premia antes de que llegue cualquier corrección. Parte de ese material parecía basarse en creaciones de un artista digital llamado Ruben Dario, publicadas originalmente en Instagram y que superaron las 12.000 visualizaciones antes de ser reutilizadas.

Versiones similares circularon también en X, donde el recorte agresivo y la captura de pantalla convierten cualquier cosa en “prueba” en cuestión de segundos.

El patrón no es nuevo. En crisis internacionales recientes se repitió la misma secuencia: durante el estallido de la guerra entre Israel y Hamás en octubre de 2023 o en los bombardeos estadounidenses sobre instalaciones iraníes el verano pasado, aparecieron oleadas similares de falsos directos.

Entre los ejemplos más recientes, circuló un vídeo donde se retiraba un cartel de Maduro presentado como celebración espontánea tras su captura, cuando en realidad correspondía a 2024. También se viralizó un clip de la cuenta “Defense Intelligence” que supuestamente mostraba el asalto estadounidense a Caracas y superó los dos millones de visualizaciones en X, pese a que el original venía de TikTok y se había subido en noviembre de 2025.

La desinformación en 2026 ya no necesita inventar historias desde cero. Basta con reciclar materiales y añadirles una capa de IA para que parezcan nuevos. La combinación de herramientas generativas, moderación irregular y viralidad por diseño crea un entorno donde la ficción compite de tú a tú con los hechos, y a veces gana por KO técnico.

La pregunta incómoda es otra: si una simple afirmación nocturna puede fabricar “realidad” en minutos, ¿qué ocurre el día que alguien lo haga con un objetivo más serio que rascar visitas? Habrá que ver si las plataformas se toman en serio la verificación visual en tiempo real, porque ahora mismo el mensaje es cristalino: la mentira ya tiene pipeline, y va bastante más rápido que la verdad.

Me dedico al SEO y la monetización con proyectos propios desde 2019. Un friki de las nuevas tecnologías desde que tengo uso de razón.

Estoy loco por la Inteligencia Artificial y la automatización.