Kimi AI acaba de meter una marcha más al prototipado web con el lanzamiento de K2.5, su nuevo modelo, que ahora mismo presume de liderar los benchmarks open source en tareas de programación.

La próxima función que tienen en la recámara es de las que hacen levantar la ceja: generar un sitio web directamente a partir de una imagen o un vídeo, casi como un “copiar estilo”, pero llevado de forma directa a HTML y CSS funcionales. La idea es sencilla en apariencia: subes un contenido multimedia y el sistema te construye una página que encaje visualmente con lo que le has mostrado.

La clave es que aquí no se habla de un mockup rápido para salir del paso, sino de una orientación clara a producto: prototipar, iterar, revisar y volver a prototipar sin salir del mismo entorno de trabajo, reduciendo fricción en cada paso.

K2.5 llega con esa aura de “modelo para código” que no se queda en el prompt bonito. Según métricas públicas, lidera los benchmarks de código abierto, especialmente en tareas relacionadas con programación, lo que lo posiciona por delante de otras alternativas open source.

Es decir, no solo redacta texto convincente: escribe, entiende y corrige código con un nivel que, al menos sobre el papel, lo vuelve competitivo para usos reales. A esto se le suma un movimiento bastante lógico: si tu modelo es bueno programando, el siguiente paso es empujarlo hacia flujos de trabajo reales, no hacia demos llamativas pero poco prácticas.

En ese sentido, el prototipado web es un terreno ideal. Mezcla front-end, decisiones visuales, estructura de componentes y una infinidad de microdetalles donde la IA suele fallar. Si funciona ahí, funciona en casi cualquier lado.

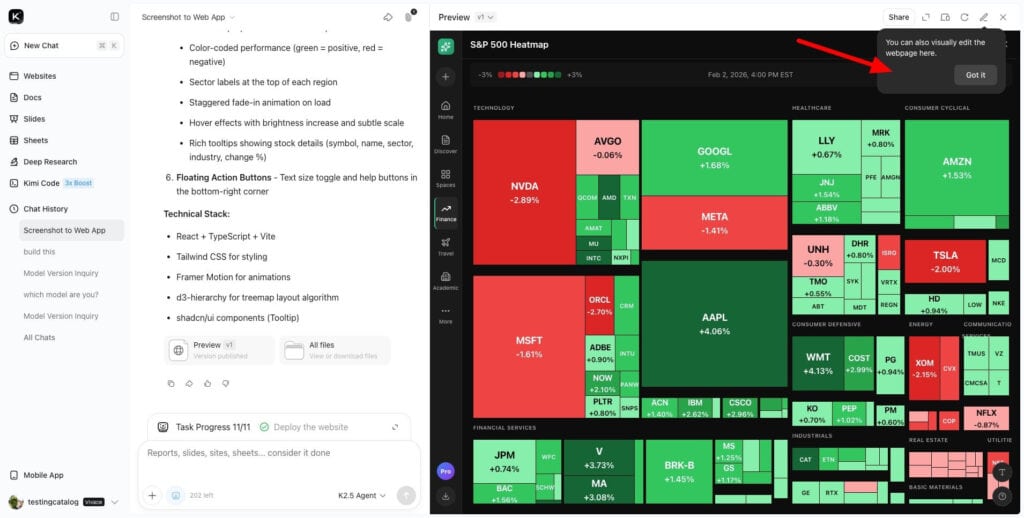

La novedad más jugosa es precisamente esa función que permite generar una web a partir de una imagen o un vídeo, disponible tanto en el modo de chat normal como en el modo agente.

Esto significa que puedes hacerlo de forma manual, como una petición más dentro de una conversación, o dejar que un agente encadene pasos, tome decisiones y ejecute el proceso como si fuese un pequeño pipeline de producción. La diferencia no está solo en el resultado, sino en el nivel de autonomía.

Lo importante no es que genere “una web”, sino que la página resultante coincida visualmente con el contenido multimedia proporcionado. Ahí es donde se separa lo útil de lo anecdótico: no basta con escupir una landing genérica, tiene que respetar jerarquías visuales, layouts, espaciados, tipografías aproximadas, componentes y hasta el “ritmo” de la interfaz.

Según pruebas internas, la función se comportó de forma fiable. Y en este contexto, fiable significa algo muy concreto: no se rompe al primer intento, algo nada trivial cuando el modelo tiene que ver, interpretar y traducir una interfaz visual a estructura web sin inventarse media UI.

Un detalle relevante es que el modo agente mostró un rendimiento global superior. Cuando se le permite planificar y ejecutar con mayor autonomía, el sistema parece equivocarse menos y aterrizar mejor el resultado final. Esto deja entrever una apuesta clara: Kimi no quiere ser solo una IA que responde, sino una IA que hace.

Convertir una imagen o un vídeo en una web es, en el fondo, un test de estrés brutal para cualquier modelo. Obliga a combinar visión, razonamiento, generación de código y consistencia visual, todo ello sin disparar la latencia ni crear un Frankenstein imposible de mantener.

Si sale bien, el impacto es enorme: horas menos de Figma-to-code, o al menos un primer borrador sólido sobre el que iterar. Si sale mal, ocurre lo contrario: más tiempo revisando, limpiando y rehaciendo componentes que no encajan.

Por eso este tipo de función no es un simple gimmick, sino una señal de hasta dónde puede llegar un modelo cuando se le empuja fuera del laboratorio.

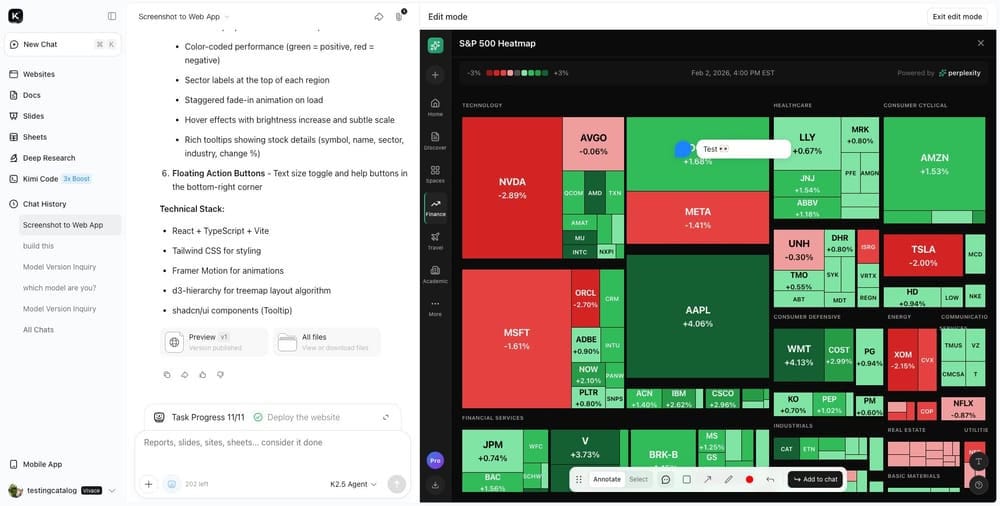

Kimi también está atacando otro punto clásico de fricción: la previsualización y el feedback. Van a añadir un modo de edición dedicado que permite anotar directamente sobre las previsualizaciones, como en una revisión rápida de diseño con un compañero.

No se trata solo de “ver lo generado”, sino de marcar encima, seleccionar componentes específicos de la interfaz y señalar problemas concretos. El detalle importante está en las herramientas: resaltar errores, colocar marcadores y añadir comentarios visuales.

Cuando termina la edición, esas anotaciones se renderizan como una imagen. Esto cambia bastante el juego, porque el feedback deja de ser texto ambiguo que alguien tiene que interpretar y pasa a ser una capa visual clara y compartible. Esa imagen vuelve al chat, facilitando el seguimiento y evitando malentendidos del tipo “cuando dije más margen, no era ahí”.

Puede parecer un añadido menor, pero cualquiera que haya pasado por ciclos de revisión sabe que la mayor pérdida de tiempo suele estar en la mala interpretación del feedback.

Con todo esto, la dirección de Kimi AI se vuelve bastante evidente: herramientas prácticas para prototipado rápido y feedback iterativo en un solo lugar. El foco está en integrar código, diseño y revisión de forma fluida, sin obligarte a saltar entre diez herramientas distintas.

No es solo “mira qué bien escribe mi LLM”, sino “mira cómo te acompaño desde el primer borrador hasta el ajuste final”. El verdadero reto llegará cuando entren casos reales: vídeos imperfectos, imágenes con UI incompleta, estilos inconsistentes o requisitos de accesibilidad.

Si K2.5 es tan sólido en programación como sugieren los benchmarks, tiene sentido que Kimi quiera convertir ese músculo técnico en producto usable de verdad. Al final, el mercado no necesita otro chat más: necesita menos fricción entre idea, diseño y entrega.

Habrá que ver si Kimi logra clavar ese “match visual” y si el modo agente termina convirtiéndose en ese compañero que no se inmuta cuando le pides diez iteraciones seguidas.

Me dedico al SEO y la monetización con proyectos propios desde 2019. Un friki de las nuevas tecnologías desde que tengo uso de razón.

Estoy loco por la Inteligencia Artificial y la automatización.