En plena carrera hacia la Inteligencia Artificial General (AGI), los modelos más avanzados de OpenAI están despertando serias dudas. Aunque prometen una capacidad de razonamiento sin precedentes, lo hacen a costa de un problema cada vez más evidente: una alta tasa de alucinación, es decir, la generación de respuestas incorrectas con total confianza.

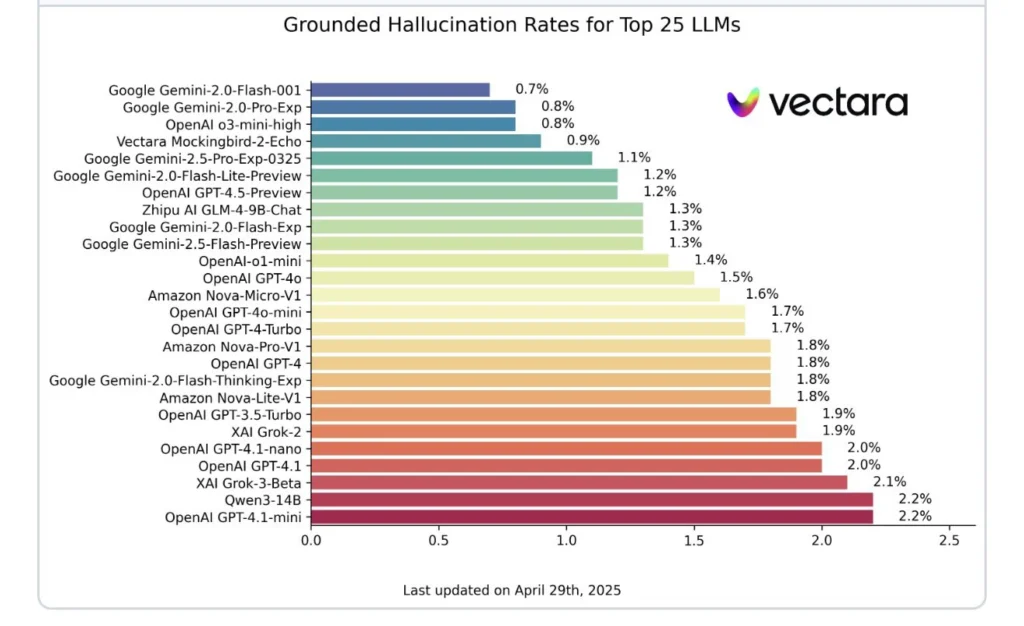

Los datos del Hallucination Leaderboard de Vectara, actualizados a finales de abril de 2025, desmienten la idea generalizada de que los modelos de lenguaje actuales alucinan más que nunca.

De hecho, muchos sistemas recientes están mostrando una fiabilidad sorprendente. Modelos como Google Gemini-2.0-Flash-001 (0,7%), Gemini-2.0-Pro-Exp (0,8%) y Vectara Mockingbird-2-Echo (0,9%) destacan con tasas de alucinación inferiores al 1%.

Sin embargo, no todos los desarrolladores pueden presumir de este logro. OpenAI, una de las compañías más influyentes del sector, enfrenta una realidad distinta.

Aunque su modelo o3-mini-high logra una tasa razonable del 0,8%, las versiones más potentes como o3 y o4-mini muestran cifras alarmantes. Según el profesor Ethan Mollick, experto en inteligencia artificial de Wharton, el modelo o3 alcanza una tasa de alucinación del 6,8%, mientras que el sistema DeepSeek R1, también mencionado en el estudio, llega hasta un inquietante 14,3%.

Estas cifras contrastan fuertemente con la narrativa optimista de OpenAI. Según su propio informe técnico, los modelos o3 y o4-mini están diseñados para realizar tareas de alto nivel, incluyendo resolución de problemas complejos y toma de decisiones autónoma. Pero su fiabilidad, claramente, no está a la altura de sus capacidades.

También te puede interesar:OpenAI o3 y o4-mini: los nuevos modelos IA de OpenAI con razonamiento multimodal y herramientas integradasLa paradoja es evidente: a mayor sofisticación en el razonamiento, menor fiabilidad en las respuestas. Este patrón sugiere que el enfoque de OpenAI (centrado en ampliar los límites cognitivos de sus modelos) podría estar sacrificando algo esencial: la veracidad.

Y en un entorno donde las aplicaciones de IA se integran cada vez más en procesos críticos (educación, salud, justicia, etc.), la precisión no es negociable.

En medio de esta crítica, al menos hay un punto positivo: OpenAI no ignora sus fallos. El reconocimiento de estas tasas de error puede ser el primer paso para reducirlas. A diferencia de otros momentos de euforia tecnológica, el sector parece estar más dispuesto a examinar con lupa sus propias métricas, lo que augura una etapa de corrección y refinamiento.

Estos resultados llegan en un momento clave. La promesa de alcanzar una IA general parece más cercana, pero si esta tecnología no puede mantener un equilibrio entre potencia y precisión, su utilidad real seguirá en entredicho. La batalla, entonces, ya no es solo por desarrollar modelos más inteligentes, sino por hacerlos confiables, verificables y responsables.

Me dedico al SEO y la monetización con proyectos propios desde 2019. Un friki de las nuevas tecnologías desde que tengo uso de razón.

Estoy loco por la Inteligencia Artificial y la automatización.