Nvidia se ha plantado en el CES 2026 con una idea muy clara: si quieres coches autónomos de verdad, necesitas que razonen, no solo que “detecten cosas”. La compañía pone el foco en una carencia que el sector lleva años arrastrando y que se vuelve crítica cuando el mundo real se sale del guion previsto.

En concreto, Alpamayo es una familia de modelos de IA open source, herramientas de simulación y conjuntos de datos diseñados para entrenar robots y vehículos físicos en situaciones complejas y poco frecuentes. No se trata solo de añadir volumen, sino de enseñar a la máquina a enfrentarse a escenarios que casi nunca ocurren… pero que importan muchísimo cuando ocurren.

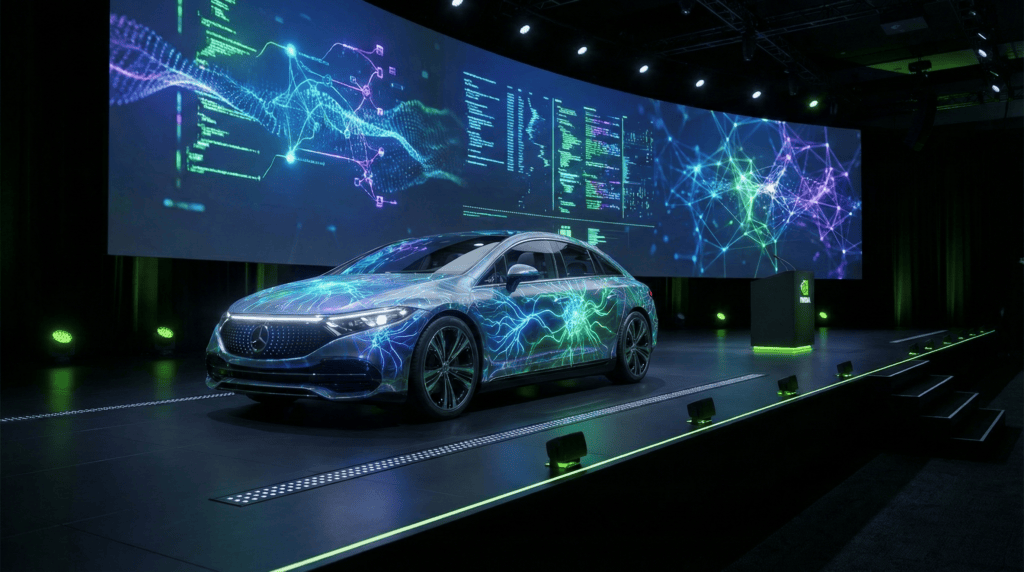

Jensen Huang lo ha definido como el “momento ChatGPT” de la IA física. Evidentemente, cuando el CEO de Nvidia usa esa analogía, no está hablando de meter un chatbot en un coche. Lo que está diciendo, en esencia, es que ahora las máquinas empiezan a entender, razonar y actuar en el mundo real.

El núcleo de esta familia es Alpamayo 1, un modelo VLA (visión-lenguaje-acción) con 10.000 millones de parámetros. No es únicamente visión por ordenador ni un LLM adaptado: combina percepción visual, instrucciones en lenguaje natural y toma de decisiones, y lo traduce en acciones físicas sobre dirección, frenos y acelerador.

La clave está en que Alpamayo 1 se apoya en razonamiento paso a paso (chain-of-thought), lo que Nvidia presenta como la capacidad de descomponer un problema complejo en decisiones intermedias y elegir la opción más segura entre varias posibles.

Pero aquí el valor no está en resolver el “caso estándar”. Nvidia insiste en los casos límite, esos eventos raros que no ocurren siempre, pero que cuando aparecen ponen en jaque a cualquier sistema autónomo.

El ejemplo que utiliza la compañía es muy de vida real: un cruce concurrido en hora punta con el semáforo averiado. En ese escenario no basta con detectar peatones y coches. Hay que inferir intenciones, anticipar movimientos y asumir que algunas personas se saltarán normas simplemente porque reina el caos.

Ali Kani, vicepresidente de Automoción en Nvidia, lo resume de forma bastante clara: el modelo enumera posibilidades, razona escenarios y selecciona la trayectoria más segura. Dicho en lenguaje humano, deja de limitarse a “ver” y empieza a entender la situación.

Evidentemente, suena a promesa grande, pero al menos es una promesa bien enfocada: menos “yo detecto carriles” y más “yo comprendo lo que está pasando”.

Jensen Huang no se quedó en el control de volante y pedales. Según Nvidia, Alpamayo razona sobre la acción que va a ejecutar, no solo responde de forma reactiva a los sensores.

En concreto, el sistema puede comunicar qué acción va a tomar, por qué la toma y cuál será la trayectoria resultante. Si el coche frena, no es un “freno porque sí”, sino un “freno porque el vehículo de la derecha inicia una incorporación y el peatón invade el paso”.

Ahora bien, conviene no exagerar: en IA, “explicar” puede significar muchas cosas, desde una justificación realmente útil hasta una racionalización elegante a posteriori. Aun así, es un avance relevante para validación, auditoría y análisis de incidentes, especialmente cuando surge la pregunta incómoda de “¿por qué el coche hizo esto?”.

Nvidia afirma que el código base de Alpamayo 1 está disponible en Hugging Face, lo que marca una diferencia importante frente a anuncios puramente teóricos. Los desarrolladores pueden acceder al modelo, adaptarlo y afinarlo dentro de sus propios flujos de trabajo.

La compañía también plantea la posibilidad de derivar versiones más pequeñas y rápidas, pensadas para entornos con restricciones de latencia y hardware embarcado, donde 10.000 millones de parámetros pueden resultar excesivos.

Además, Alpamayo puede funcionar como una especie de modelo “profesor”, ayudando a entrenar sistemas de conducción más simples y compactos. Nvidia menciona casos como herramientas de autoetiquetado que generan anotaciones de vídeo de forma automática, reduciendo drásticamente el trabajo manual.

A esto se suman evaluadores construidos sobre Alpamayo para comprobar si una decisión tomada por el vehículo fue razonable o segura. Todo apunta al verdadero cuello de botella del sector: no solo entrenar, sino validar en condiciones que se parezcan al mundo real.

El ecosistema se completa con Cosmos, la marca de Nvidia para sus modelos generativos de mundo. Se trata de sistemas capaces de representar entornos físicos, predecir qué puede ocurrir en ellos y generar datos sintéticos para entrenamiento y pruebas.

Según Ali Kani, Cosmos permite combinar datos reales y sintéticos para entrenar y evaluar aplicaciones de conducción autónoma basadas en Alpamayo. Eso sí, el valor del dato sintético depende de una condición clave: que sea lo suficientemente realista y que cubra escenarios raros, no solo los fáciles.

En paralelo, Nvidia publica un conjunto de datos abierto con más de 1.700 horas de conducción real en distintas geografías y condiciones. Material pensado no solo para entrenar, sino sobre todo para estresar los modelos con escenas complejas.

A ello se suma AlpaSim, un marco de simulación open source que recrea condiciones reales de conducción, incluyendo sensores, tráfico y comportamientos impredecibles. La promesa es clara: probar a escala sin arriesgar coches, carreteras ni personas.

Eso sí, el sector ya ha visto simulaciones muy vistosas que se rompen en cuanto llueve, hay obras o aparece el conductor que improvisa. Precisamente por eso Alpamayo resulta interesante: no se vende como un piloto automático perfecto, sino como una capa de razonamiento para navegar el caos.

Habrá que esperar para ver cuánto de todo esto llega a producción y cuánto se queda en demo de feria, pero la dirección es evidente: el futuro del coche autónomo no va de ver mejor, va de entender mejor.

Me dedico al SEO y la monetización con proyectos propios desde 2019. Un friki de las nuevas tecnologías desde que tengo uso de razón.

Estoy loco por la Inteligencia Artificial y la automatización.