GPT-5.1-Codex-MAX apunta a dar un salto en cómo programas con un asistente de código. La idea es clara: ayudarte en proyectos grandes, mantener el contexto durante horas y no perder el hilo entre archivos. Con todo, lo más interesante está en cómo piensa resolver lo que hoy frena a muchos modelos cuando el repositorio se hace enorme.

Vas a ver qué promete este modelo, por qué puede cambiar tu flujo de trabajo y qué señales indican que el lanzamiento podría estar muy cerca. Te explicamos qué significa trabajar a nivel de proyecto con GPT-5.1-Codex-MAX y qué mejoras puedes esperar en velocidad, memoria y estabilidad de tareas.

La referencia a GPT-5.1-Codex-MAX describe un modelo de codificación más inteligente y rápido, pensado para cargas de trabajo a nivel de proyecto. No se queda en archivos sueltos, sino que busca seguir tareas largas, en varios pasos, dentro de un repositorio real. No hablamos de magia, sino de un enfoque técnico muy concreto que te va a permitir trabajar con más estabilidad.

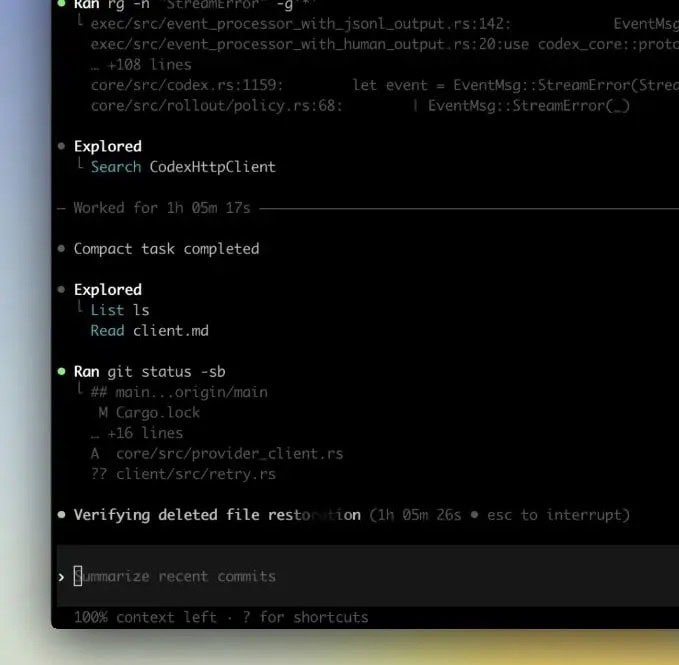

Si te cuesta que un asistente mantenga la coherencia entre módulos, tests y scripts, GPT-5.1-Codex-MAX intenta sostener ese hilo. La meta es que puedas alternar entre refactors, documentación y pipelines sin que el modelo “olvide” decisiones previas. Con esto vas a poder avanzar sprint a sprint con menos reinicios de contexto y menos pegoteo de fragmentos de código.

El gran bloqueo hoy es la ventana de contexto: cuando el código no cabe, el modelo vuelve a escanear y reconstituir lo que entiende del repo. GPT-5.1-Codex-MAX apunta a reducir ese bucle repetitivo con un mecanismo interno que retiene o reconstruye conocimiento a nivel de repositorio. No hay confirmación de una ventana de contexto gigante.

El objetivo es limitar la ingestión completa del árbol de código en cada paso. Con una mejor memoria estructurada o una indexación más fina, vas a poder pedir cambios amplios sin reinyectar el repositorio entero. Esto es clave en monorepos y servicios con microfrontends, donde cada “recordatorio” consume tiempo y rompe el ritmo de desarrollo.

¿Cómo puede GPT-5.1-Codex-MAX “recordar” sin leerlo todo otra vez? La pista sugiere un mecanismo de recuperación distinto, capaz de reconstruir contexto útil bajo demanda. Con todo, el detalle exacto no es público. Lo relevante para ti es que vas a poder pedir cambios multiarchivo con menos fricción y más continuidad en decisiones técnicas.

Los sistemas de agente suelen fallar si no mantienen una memoria clara entre pasos. Aquí, la combinación de índices, resúmenes por paquete y referencias cruzadas puede ser la clave. Tendrás que seguir marcando contratos de código nítidos para que el modelo acierte al saltar entre capas y no se pierda en dependencias.

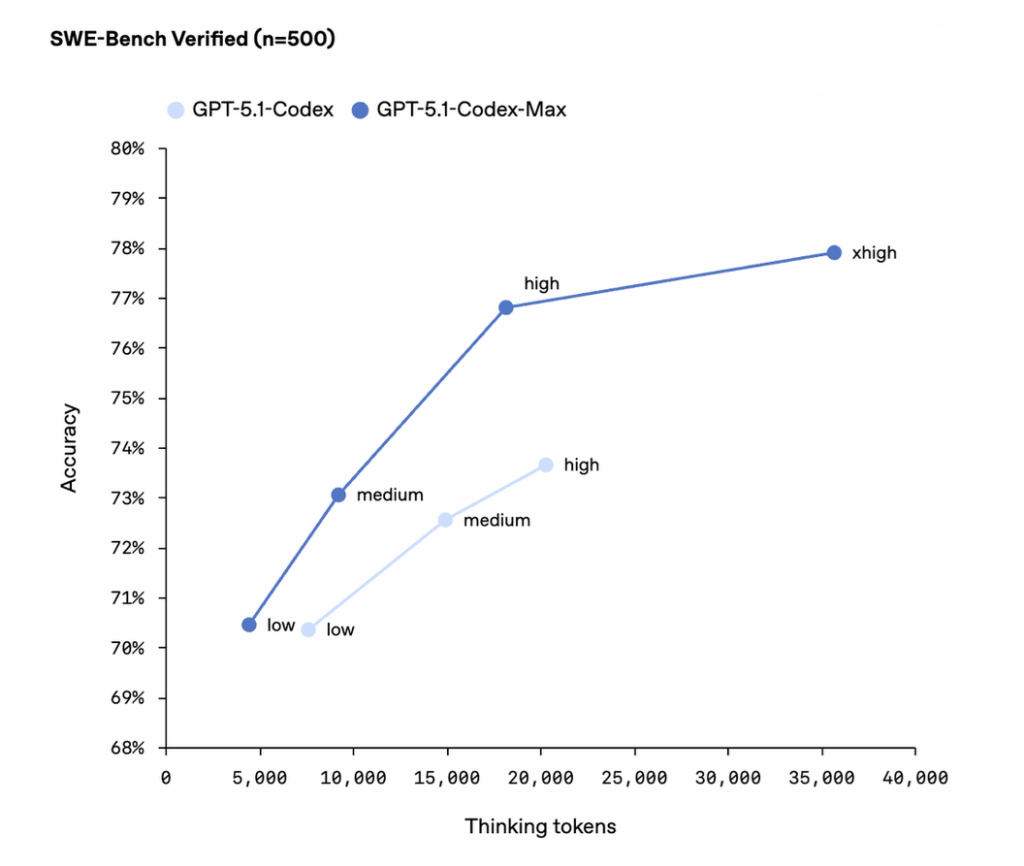

Anthropic empuja con Claude MAX y su ventana de 500.000 tokens en uso empresarial, lo que ya te permite meter bastante código de golpe. GPT-5.1-Codex-MAX no confirma esa cifra, y las señales apuntan a otra vía: computación más rápida y arquitectura distinta para navegar repos sin inflar solo los tokens. La comparación es inevitable.

La diferencia práctica para ti puede estar en el equilibrio entre tamaño de contexto y velocidad de recuperación. Si GPT-5.1-Codex-MAX acelera la búsqueda selectiva de piezas relevantes, el tiempo de respuesta baja y el ciclo de prueba y error se hace más fluido. En cualquier caso, ambos caminos atacan la misma barrera: trabajar más allá del límite de contexto.

Característica | GPT-5.1-Codex-MAX | Claude MAX |

|---|---|---|

Ventana de contexto | No confirmada, posible enfoque híbrido | Hasta ~500k tokens (empresa) |

Estrategia principal | Recuperación distinta y cómputo rápido para repos grandes | Contexto amplio con indexación auxiliar |

Tipo de tareas | Multiarchivo, largo recorrido, estable | Ingesta masiva y operaciones extensas |

La promesa de GPT-5.1-Codex-MAX es mantener tareas de codificación estables en varios archivos y durante más tiempo. Piensa en refactors que se extienden por semanas, migraciones de frameworks, revisiones de seguridad o alineamiento de estilos entre paquetes. Seguirá necesitando instrucciones claras y un control de versiones limpio.

Si lo comparamos con la app móvil de un asistente clásico, aquí vas a poder orquestar cambios amplios sin perder decisiones intermedias. Con GPT-5.1-Codex-MAX vas a poder sincronizar cambios en contratos, tests y documentación y mantener la coherencia con pipelines y despliegues. Este enfoque minimiza idas y vueltas por falta de memoria.

La referencia a GPT-5.1-Codex-MAX aparece en una base de código reciente, lo que sugiere un lanzamiento cercano. No hay fecha oficial. Las pistas encajan con un anuncio en días, alineado con ciclos habituales cuando una función filtrada se integra ya en herramientas internas.

Si gestionas un equipo, conviene ir preparando entornos de prueba y criterios de evaluación. Así vas a poder medir mejoras en tiempo de respuesta, estabilidad entre sesiones y calidad de cambios multiarchivo. Con todo, mantén margen para ajustes porque las primeras versiones suelen afinar semana a semana.

La llegada de GPT-5.1-Codex-MAX encaja con la presión competitiva que marca el lanzamiento de Gemini 3 en el segmento de código. Cuando varios actores empujan a la vez, las expectativas suben y tú esperas menos fricción y más continuidad en tareas largas. Aquí es donde un modelo estable y rápido puede marcar diferencia.

Si esta apuesta cuaja, vas a poder planificar épicas enteras con el asistente como compañero estable y no como “ayudante puntual”. Seguirá importando tu criterio técnico, tu control de calidad y tu atención a los detalles. El valor está en combinar GPT-5.1-Codex-MAX con buenas prácticas, no en sustituirlas.

Todo apunta a que GPT-5.1-Codex-MAX quiere cubrir el hueco que queda entre tareas pequeñas y proyectos de verdad: repositorios grandes, ventana de contexto limitada y necesidad de retención a nivel de repositorio. Si suma cómputo rápido y un mecanismo de recuperación más fino, vas a poder encadenar refactors, migraciones y mejoras de seguridad con menos interrupciones, incluso con la presión de alternativas como Claude MAX y Gemini 3 en el horizonte.

Me dedico al SEO y la monetización con proyectos propios desde 2019. Un friki de las nuevas tecnologías desde que tengo uso de razón.

Estoy loco por la Inteligencia Artificial y la automatización.