OpenAI acaba de poner una pica muy seria en el sector sanitario con OpenAI for Healthcare, y lo más llamativo no es solo el producto, sino cómo dice que valida la IA cuando hay vidas, diagnósticos y burocracia clínica en juego. Según la propia compañía, su programa de evaluación está liderado por clínicos e involucra a más de 260 médicos con licencia en 60 países, que han revisado más de 600.000 salidas del modelo.

La oferta arranca con ChatGPT for Healthcare, ya en despliegue en nombres de peso como AdventHealth, Baylor Scott & White Health, Boston Children’s Hospital, Cedars-Sinai, HCA Healthcare, Memorial Sloan Kettering, Stanford Medicine Children’s Health y UCSF. Pero aquí no hablamos de “poner un chatbot en el hospital y listo”: esto va de IA en entornos con cumplimiento tipo HIPAA, auditorías, identidades corporativas y flujos clínicos que no perdonan errores.

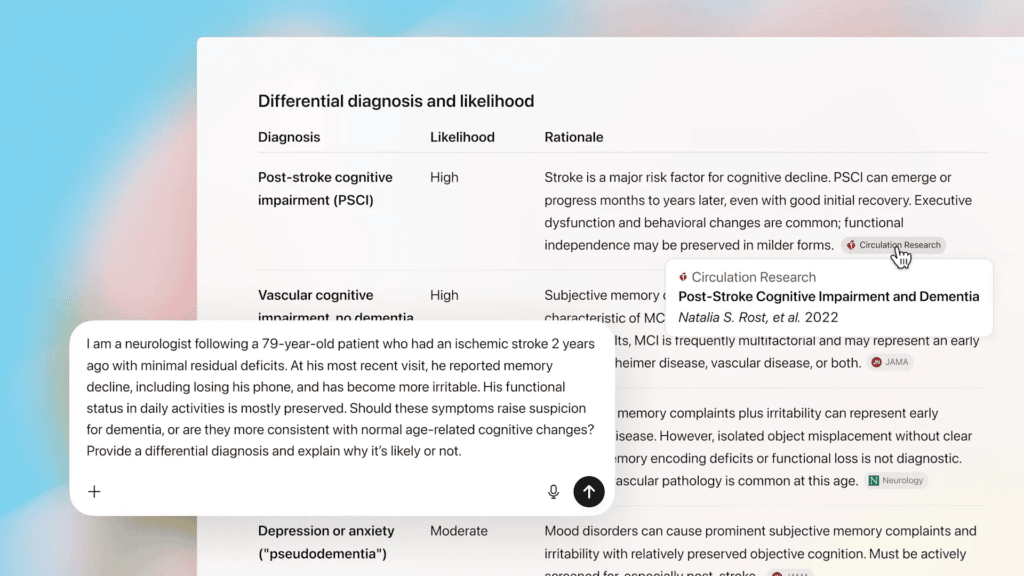

OpenAI insiste en que su producto está diseñado alrededor de flujos de trabajo clínicos y operativos reales. Incluye modelos GPT-5 ajustados específicamente para tareas sanitarias, lo que marca una diferencia importante: no es “el mismo GPT para todo”, sino un ajuste orientado a patrones de la sanidad, como documentación clínica, coordinación entre equipos, preguntas médicas y resúmenes de diagnóstico en contexto.

A esto se le suma un punto crítico para cualquiera que haya visto a un modelo “alucinar” una referencia: recuperación de evidencia basada en literatura médica y guías clínicas, con citas transparentes. Citar no convierte una respuesta en verdad absoluta, pero cambia el uso práctico: permite comprobar rápido de dónde sale una recomendación antes de fiarte.

El hospital real, además, no vive en PDFs bonitos. Vive en políticas internas, protocolos locales y rutas asistenciales que cambian por servicio y por centro. Por eso OpenAI habla de integraciones para incorporar políticas internas y vías asistenciales de la institución, incluyendo repositorios empresariales como SharePoint.

Básicamente, el modelo no solo sabe medicina; también puede operar dentro del “así lo hacemos aquí”, que es lo que suele separar un piloto vistoso de una herramienta que el personal adopta de verdad.

La IA en sanidad suele romperse por donde más duele: identidad, permisos, trazabilidad y responsabilidad. En ese terreno, ChatGPT for Healthcare incluye gobernanza centralizada con SAML SSO, SCIM y controles de acceso basados en roles. Lo básico —pero imprescindible— para cualquier TI hospitalaria: inicio de sesión corporativo, aprovisionamiento de usuarios y permisos granulares, porque no debería ver lo mismo un administrativo que un intensivista.

A esto se suma un paquete de cumplimiento que apunta directamente al checklist: registros de auditoría, claves de cifrado gestionadas por el cliente y opciones de residencia de datos. Y aparece la frase que siempre centra el debate: OpenAI afirma que el contenido de los clientes no se utiliza para entrenar los modelos. No elimina todas las preguntas posibles, pero es una línea roja clave para que un sistema de salud se plantee escalar.

También destaca la firma de un Business Associate Agreement (BAA), la pieza contractual típica cuando entras en territorio HIPAA y necesitas atar obligaciones claras de privacidad y seguridad.

Si alguien espera “IA que diagnostica”, probablemente se frustre. Lo que más devora tiempo en sanidad es la documentación. Aquí OpenAI menciona plantillas reutilizables para informes de alta, cartas de derivación y autorizaciones previas, ese trabajo invisible que nadie quiere hacer pero que decide si un paciente sale con el informe correcto o si un tratamiento se aprueba a tiempo.

Estas plantillas solo funcionan si están alineadas con el estilo del centro, su codificación y sus circuitos internos. Por eso vuelve a ser clave la promesa de integrar políticas internas y rutas asistenciales: si se implementa bien, la diferencia es enorme entre “me hace un borrador genérico” y “me deja algo casi listo para firmar”.

Aquí está el dato que define el enfoque: 260 médicos, más de 600.000 salidas revisadas y 30 áreas de enfoque clínico. OpenAI asegura que esta validación incluye red-teaming realizado por médicos, no solo probar “casos bonitos”, sino intentar romper el sistema con situaciones límite, ambigüedades clínicas y escenarios donde los modelos tienden a inventar o a sonar demasiado seguros.

A esto se suma el uso de benchmarks como HealthBench y GDPval. Ningún benchmark sustituye la realidad de un hospital, pero aporta disciplina: medir, iterar y volver a medir con criterios consistentes.

Muchos sistemas de salud van a querer construir soluciones propias encima. Aquí OpenAI posiciona su API como capa de plataforma sanitaria, con acceso a modelos actuales como GPT-5.2. Eso abre la puerta a desarrollar herramientas de resumen de historiales, coordinación asistencial, flujos de alta, documentación ambiental o programación de citas.

Si quieres jugar en serio en sanidad, necesitas cumplimiento, y OpenAI ofrece un camino para obtener un BAA para clientes elegibles que construyan sobre su API. Estratégicamente, es una jugada clara: si consiguen ser el “AWS de la IA clínica”, se quedan en el centro del pipeline durante años.

Con estas cifras de evaluación y el foco en gobernanza, OpenAI está vendiendo una idea muy concreta: la IA en hospitales no va de demos, va de control, evidencia y responsabilidad. La gran incógnita es la de siempre: cuánto de esto se traducirá en menos clics, menos retrasos y menos burnout para el personal sanitario.

Y, además, está la presión competitiva: si este enfoque cuaja en grandes redes hospitalarias, habrá que ver quién responde con el mismo nivel de seguridad, contratos y validación clínica. Porque cuando la IA deja de ser hype y pasa a ser infraestructura, la confianza ya no es un extra: es el producto.

Me dedico al SEO y la monetización con proyectos propios desde 2019. Un friki de las nuevas tecnologías desde que tengo uso de razón.

Estoy loco por la Inteligencia Artificial y la automatización.