OpenAI ha sorprendido al ecosistema tecnológico con el lanzamiento de gpt-oss-120b y gpt-oss-20b, dos modelos de razonamiento de código abierto que marcan un cambio notable en la estrategia de la compañía. Se trata de los primeros modelos con pesos abiertos que lanza desde GPT-2 en 2019.

La decisión llega en un momento de fuerte presión internacional, especialmente por parte de laboratorios de IA en China como DeepSeek, Alibaba (con su modelo Qwen) y Moonshot AI, que han ganado terreno con potentes modelos abiertos.

La noticia, oficializada el martes, incluye la publicación gratuita de ambos modelos en Hugging Face, una plataforma clave para desarrolladores de IA. Según OpenAI, los modelos son “punta de lanza” en cuanto a capacidades dentro del espacio abierto y están pensados para facilitar tanto tareas locales como conexiones con modelos cerrados más avanzados a través de la nube.

Aunque en sus primeros años OpenAI promovió la filosofía del código abierto, rápidamente adoptó un modelo cerrado y comercial, vendiendo acceso a sus modelos vía API. Esa estrategia le permitió crecer como empresa, pero también la alejó de su objetivo fundacional: desarrollar una IA general (AGI) que beneficie a toda la humanidad.

En enero de este año, su CEO Sam Altman admitía públicamente que OpenAI había estado "en el lado equivocado de la historia" en relación con el código abierto. Este nuevo paso con GPT-OSS parece buscar no solo reconciliarse con los desarrolladores, sino también responder al llamado del gobierno de EE. UU., que ha instado a abrir más tecnologías de IA para preservar valores democráticos frente al ascenso de la competencia china.

El modelo gpt-oss-120b, más potente, puede ejecutarse en una única GPU de Nvidia, mientras que el gpt-oss-20b está optimizado para laptops de consumo con 16 GB de RAM. Esta accesibilidad técnica lo hace especialmente atractivo para desarrolladores independientes o startups con recursos limitados.

Ambos modelos usan una arquitectura Mixture-of-Experts (MoE) que activa solo una fracción de sus parámetros para cada pregunta (5.1 mil millones en el caso de gpt-oss-120b, que tiene un total de 117 mil millones). Esto permite un rendimiento eficiente y menor consumo de cómputo.

Sin embargo, hay limitaciones claras: los modelos son solo de texto, sin capacidad para procesar imágenes ni audio, algo que ya es estándar en otras versiones propietarias como GPT-4o.

Además, presentan una tasa de alucinaciones considerablemente mayor que los modelos cerrados más avanzados. En las pruebas internas, gpt-oss-120b alucinó en el 49% de los casos evaluados por el benchmark PersonQA, y su versión ligera, en un preocupante 53%. Esto contrasta con el modelo o1 (16%) y o4-mini (36%).

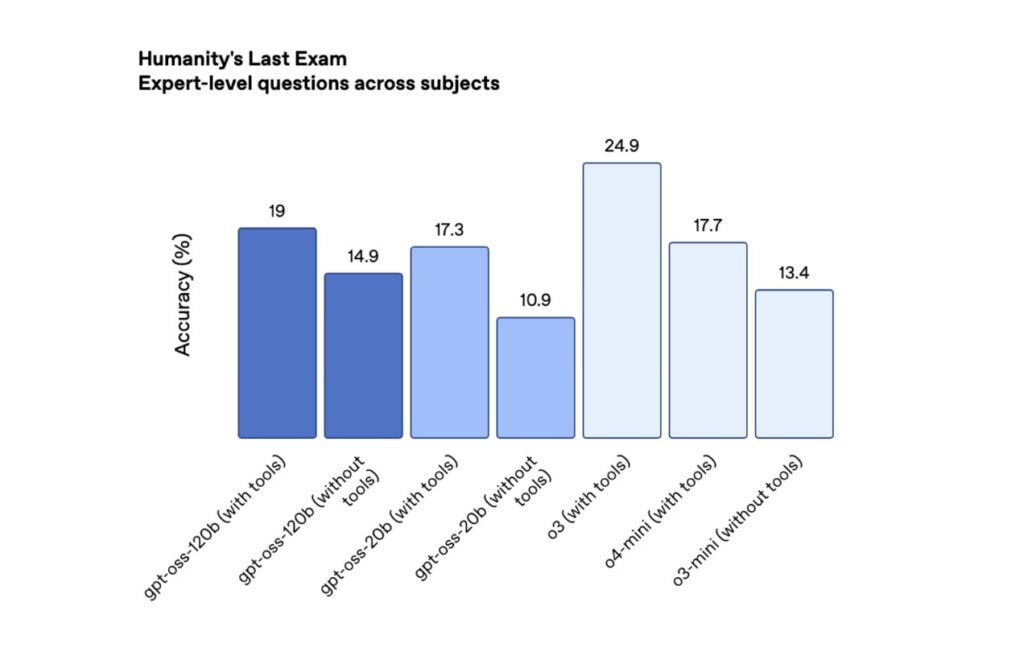

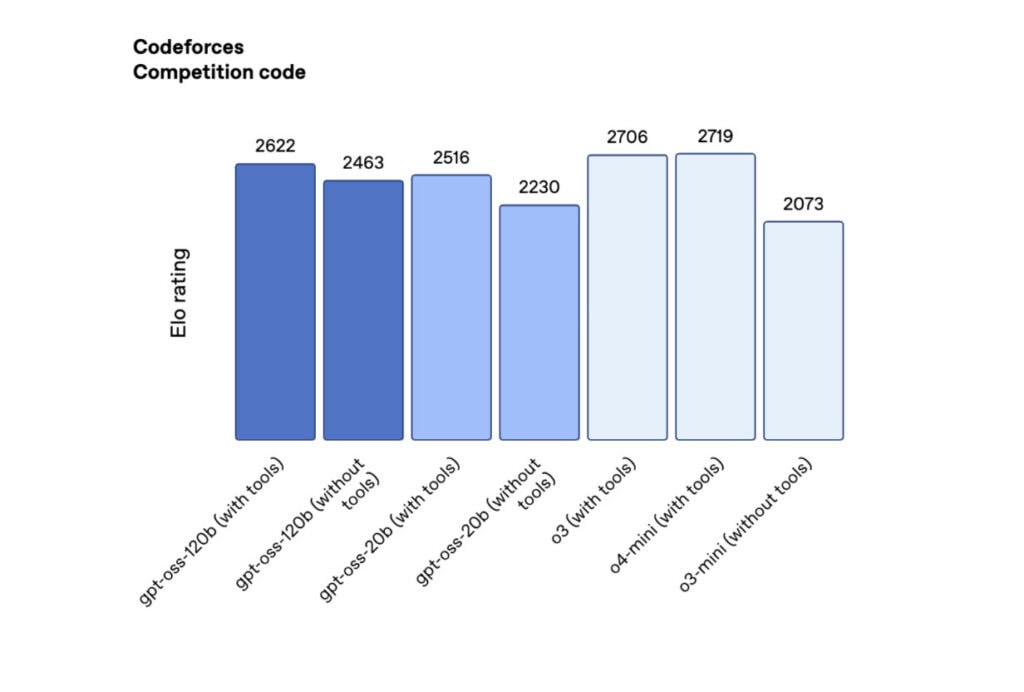

En pruebas de razonamiento como Codeforces, gpt-oss-120b obtuvo 2622 puntos y gpt-oss-20b alcanzó 2516, superando a DeepSeek R1 pero quedando por detrás de modelos cerrados como o3 y o4-mini. En el test Humanity’s Last Exam (HLE), sus resultados también superaron a DeepSeek y Qwen, pero sin alcanzar los niveles de los modelos de referencia de OpenAI.

Esto demuestra que, si bien los modelos abiertos han progresado, todavía hay una brecha significativa en precisión, profundidad de conocimiento y reducción de errores en comparación con los modelos más avanzados y cerrados.

OpenAI entrenó estos modelos utilizando refuerzo con alto cómputo (RL), el mismo método aplicado a su serie o. Esta técnica permite que el modelo desarrolle una cadena de razonamiento más coherente y lógica para llegar a sus respuestas. Además, pueden llamar herramientas como búsqueda web o ejecución de código Python, lo que los hace útiles para construir agentes de IA interactivos.

No obstante, los modelos se entrenaron sin divulgar los datos usados, a diferencia de laboratorios como AI2. Esto se explica en parte por las múltiples demandas judiciales que enfrentan empresas como OpenAI por el uso indebido de obras con derechos de autor.

En cuanto a la seguridad, OpenAI realizó evaluaciones internas y externas sobre los posibles usos maliciosos de gpt-oss. Si bien se detectó un leve incremento en las capacidades biológicas, no se alcanzó el umbral considerado de alto riesgo.

Los modelos se publican bajo licencia Apache 2.0, lo que permite su uso comercial sin necesidad de pagar regalías ni pedir autorización. Esto representa una apertura significativa respecto a los modelos cerrados anteriores de OpenAI, y una apuesta por atraer a más empresas y desarrolladores.

Sin embargo, este paso aún no puede equipararse con un verdadero código abierto según los estándares más exigentes, ya que OpenAI no compartirá los datos de entrenamiento, limitando así la capacidad de auditar o replicar el modelo de manera completamente transparente.

El lanzamiento de GPT-OSS parece ser, más allá de lo técnico, un movimiento estratégico con múltiples objetivos: responder al ascenso de la IA china, reconectar con la comunidad open source que una vez lo admiró, y alinearse con las demandas del gobierno estadounidense en la carrera geopolítica por la inteligencia artificial.

Con esta jugada, OpenAI busca recuperar legitimidad como líder ético en IA, sin renunciar a su modelo de negocio basado en APIs propietarias. Pero el terreno está lejos de ser estable: mientras sus modelos abiertos generan expectativa, los desarrolladores están atentos al inminente lanzamiento del DeepSeek R2 y al nuevo modelo abierto que prepara Meta desde su Superintelligence Lab.

La guerra por el control moral y técnico de la IA está lejos de terminar. Y aunque OpenAI ha dado un paso importante, aún le queda camino por recorrer para reconciliar su misión fundacional con las demandas del mercado, la política internacional y la comunidad tecnológica.

Me dedico al SEO y la monetización con proyectos propios desde 2019. Un friki de las nuevas tecnologías desde que tengo uso de razón.

Estoy loco por la Inteligencia Artificial y la automatización.