Imagínate ponerte unas gafas que parecen de sol, conectar un pequeño cable a un módulo en el bolsillo y, de repente, ver un escritorio virtual gigante flotando delante de ti. Con las gafas XR Project Aura Google y Xreal quieren justo eso: que no cargues con un casco enorme, pero sí tengas una experiencia muy cercana a un headset completo.

Con estas gafas XR con cable vas a poder abrir varias apps a la vez, jugar en 3D y hablar con Gemini casi como si fuese una persona más en la habitación. Lo realmente interesante no es solo el efecto “wow” de la tecnología, sino cómo Android XR intenta resolver los grandes problemas del sector: falta de apps, ecosistemas cerrados y miedo a la privacidad. Vamos a ver cómo lo están planteando sin destripar todavía todas las sorpresas.

Lo primero que llama la atención de las gafas XR Project Aura es su aspecto: por fuera se parecen bastante a unas gafas de sol gruesas, algo voluminosas pero aún aceptables para la calle. En el lateral izquierdo llevan un cable que baja hasta un paquete de batería, que guardas en el bolsillo o en el cinturón, y que también funciona como trackpad táctil para manejar la interfaz sin levantar las manos.

Google no las vende como unas simples “gafas inteligentes”, sino como un headset disfrazado de gafas. La idea es que tengas muchas de las funciones de un casco tipo Galaxy XR o Vision Pro, pero en un formato más ligero y menos intimidante. El campo de visión llega hasta unos 70 grados, así que no tienes solo una ventanita pequeña delante de los ojos, sino una zona bastante amplia donde ver ventanas, vídeos y juegos flotando.

Una de las funciones que más marca la diferencia es el escritorio virtual. Con las gafas XR Project Aura puedes conectarte de forma inalámbrica a tu portátil y hacer que la pantalla se convierta en varias pantallas flotando en el aire. Es como tener un monitor ultrapanorámico, pero en cualquier sitio: en el sofá, en el tren o en una cafetería pequeña.

En las demos se ve, por ejemplo, cómo abres Adobe Lightroom en una ventana para editar fotos mientras mantienes YouTube en otra pantalla al lado. Vas a poder organizar ese escritorio virtual como te apetezca, moviendo cada ventana y ajustando el tamaño. Aunque la experiencia es muy inmersiva, sigues viendo tu entorno real alrededor, lo que ayuda a no perderte si alguien se acerca o si tienes que mirar el teclado físico.

También te puede interesar:Vuelven las gafas inteligentes de Google con Android XR: ¿segunda oportunidad o repetición del fracaso?Además del trabajo y la productividad, las gafas XR Project Aura están pensadas para ocio. En una demostración se muestra un juego de mesa 3D que aparece sobre una superficie real. Con gestos de pellizcar y estirar puedes hacer zoom sobre el tablero, acercarte a una pieza concreta o volver a ver todo el conjunto con un movimiento suave de los dedos.

En ese mismo entorno virtual también vas a poder ver vídeos 3D de YouTube integrados en la interfaz de las gafas. Esto convierte las Project Aura en una especie de “cine personal” donde el contenido tiene profundidad y se ve directamente frente a ti, algo muy atractivo para series, conciertos o contenido educativo en 3D.

Si te preguntas si estas gafas XR Project Aura son de “realidad aumentada pura”, la respuesta es matizada. La experiencia se parece más a usar un casco como el Galaxy XR de Samsung que a una gafa AR que coloca objetos perfectamente pegados en el mundo real. Lo que ves son aplicaciones flotando delante de ti y tu entorno, sin buscar una alineación superprecisa con cada centímetro del espacio físico.

Hay funciones que sí juegan con el mundo real. Un ejemplo llamativo es el uso de Circle to Search y Gemini cuando miras un cuadro colgado en la pared: miras, marcas, pides información y el sistema identifica la obra y el artista. No se trata tanto de decorar toda la habitación con capas digitales, sino de usar lo que tienes alrededor como disparador para consultas y acciones rápidas.

El detalle clave de las gafas XR Project Aura no está tanto en el hardware como en el software. Todo lo que se probó en este dispositivo viene directamente del trabajo hecho para el casco Galaxy XR de Samsung. Las aplicaciones, interfaces y experiencias no se han rehecho desde cero para el nuevo formato de gafas, se han reutilizado tal cual.

Esta capacidad de reutilizar software XR se presenta como un triunfo importante para Android XR. Mientras otros productos llegan al mercado con un catálogo mínimo, aquí se parte ya de un conjunto de apps preparadas para un headset y que ahora funcionan también en estas gafas con cable. Eso reduce tiempo, costes y frustración tanto para Google como para los estudios que crean contenido.

Una de las grandes quejas de usuarios y creadores es que el sector XR está muy verde en cuanto a catálogo de aplicaciones. Casos recientes como las Meta Ray-Ban Display o el Apple Vision Pro muestran un patrón parecido: el hardware llama la atención, pero luego hay pocas apps de terceros que justifiquen un uso diario continuo, más allá de las funciones básicas.

Cuando hay tan pocas herramientas y juegos interesantes, el incentivo para que tú te pongas las gafas XR Project Aura todos los días baja mucho. Al mismo tiempo, los desarrolladores tienen que elegir a qué plataforma apostar: ¿Meta, Apple, Samsung, otra marca? Para los equipos pequeños, mantener varias versiones XR puede ser inviable, y eso frena la llegada de ideas creativas.

Aquí es donde Android XR intenta cambiar las reglas. Con esta plataforma, fabricantes más pequeños como Xreal pueden apoyarse en las apps ya creadas para el casco de Samsung y no empezar de cero. Las futuras gafas de IA de Warby Parker y Gentle Monster, que llegarán el año que viene, también podrán ejecutar esas mismas aplicaciones de Android sin desarrollos específicos para cada modelo.

Chi Xu, CEO de Xreal, resume esta ventaja diciendo que Android XR ayuda a evitar la fragmentación entre dispositivos XR. Su apuesta es que cada vez más gafas y cascos converjan en un mismo ecosistema, justo lo que persigue esta plataforma de Google. Xu reconoce que Xreal podrá ir haciendo las gafas cada vez más pequeñas y cómodas, pero también admite que no tienen un ecosistema propio y que solo empresas como Google o Apple pueden sostener uno de verdad.

En su opinión, Apple no va a colaborar con terceros en este terreno, así que, para compañías como Xreal, Google es la única opción realista si quieren lanzar gafas XR atractivas con apps de calidad. De esta forma, las gafas XR Project Aura se convierten en un punto medio entre muchas piezas: hardware de socios, software compartido y una base Android que ya conocen millones de desarrolladores.

Para que veas qué significa en la práctica esa compatibilidad, Google ha enseñado varias demos muy claras. Todas giran en torno a una idea: las gafas XR Project Aura se aprovechan de las apps que ya tienes instaladas en tu móvil Android, sin obligar a las empresas a hacer versiones XR especiales solo para este dispositivo.

En teoría, con solo emparejar las gafas con tu teléfono vas a poder empezar a usar apps Android existentes como si fuesen widgets flotando delante de tus ojos. Esto no implica que todo esté optimizado de forma perfecta desde el primer día, pero abre la puerta a una biblioteca muy amplia desde el minuto uno, algo crítico para cualquier gafas XR que quieran triunfar.

Una de las demos más concretas se hace en un escenario típico: el aeropuerto JFK. Pides un Uber desde tu teléfono, como siempre, pero en las gafas XR Project Aura aparece un widget flotante de Uber con toda la información clave. Ves el tiempo estimado de recogida, la matrícula del coche y el modelo, sin tener que sacar el móvil del bolsillo cada dos minutos.

Si bajas la mirada, las gafas muestran un mapa del aeropuerto con indicaciones en tiempo real hasta la zona de recogida. Es decir, vas andando por las terminales y la interfaz te guía paso a paso, ayudándote a no perderte cuando estás cansado o con prisa. Lo interesante es que toda esta experiencia se genera usando directamente la app Android de Uber, sin que Uber tenga que crear una app específica de Android XR para las gafas.

En otra demostración se combina Gemini con YouTube Music. Le pides a Gemini que ponga música, por ejemplo “pon jazz suave para trabajar”, y en tu campo de visión aparece un widget de YouTube Music con el título de una lista de jazz y los controles de reproducción básicos: play, pausa, siguiente, anterior.

Lo curioso es que esta experiencia de música sigue dependiendo de la app de YouTube Music instalada en el teléfono Android que has emparejado con las gafas XR Project Aura. No hay una app específica para el visor, simplemente la interfaz se adapta para mostrarse en ese “espacio flotante” delante de ti. Así, cualquier ajuste o lista que ya tengas en el móvil se refleja al instante en las gafas.

Otro punto fuerte de Project Aura es cómo las gafas XR se conectan con los relojes inteligentes Wear OS. En las pruebas, el usuario hace una foto con las gafas controlando todo por voz a través de Gemini. La imagen aparece en la pantalla de las gafas como previsualización y, al mismo tiempo, se ve también en un Pixel Watch emparejado en la muñeca.

Esta integración abre opciones curiosas: por ejemplo, unas futuras gafas de solo audio con cámara podrían delegar toda la parte visual en el reloj. Harías la foto con la voz, la revisarías en la muñeca y la gestionarías sin necesidad de una pantalla grande en las lentes, lo que permitiría modelos más discretos y ligeros para el día a día.

Google aclara que esta visualización de fotos tomadas desde las gafas XR Project Aura en la muñeca no será exclusiva del Pixel Watch. Cualquier reloj compatible con Wear OS va a poder mostrar esas imágenes, lo que amplía bastante las combinaciones posibles entre gafas y relojes de distintas marcas.

Más allá de las apps clásicas, las gafas XR Project Aura también ofrecen funciones centradas en la inteligencia artificial y la comunicación. En las pruebas de Google se ve cómo las gafas son capaces de hacer traducciones en vivo, detectando automáticamente el idioma que se está hablando a tu alrededor y mostrando una versión traducida para que puedas seguir la conversación.

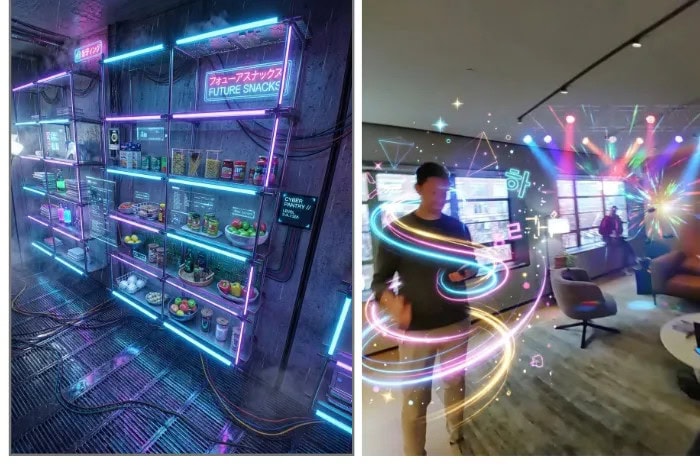

También se permite hacer videollamadas de Google Meet directamente desde las gafas, con lo que vas a poder ver a la otra persona flotando en tu campo de visión mientras sigues moviéndote por casa o la oficina. Para la parte más creativa, aparece una demo donde una herramienta llamada Nano Banana Pro añade elementos de K-pop a una foto tuya, combinando edición de imagen y cultura pop de forma bastante llamativa.

Dentro de las demostraciones, el periodista también prueba un segundo prototipo de gafas XR con pantalla en ambas lentes, pensado para ampliar todavía más el campo de visión. Google aclara que este modelo no llegará al mercado el año que viene, pero sirve para mostrar hacia dónde podrían ir las futuras versiones de Project Aura.

En paralelo, los ingenieros están explorando varios formatos: modelos de solo audio, versiones con pantalla solo en una lente y configuraciones con pantallas en las dos. La idea es no cerrarse a un único diseño y adaptar las gafas XR a distintos casos de uso, desde algo casi invisible para la calle hasta un dispositivo más grande para casa o la oficina.

Dentro de todo este sistema, Google repite una idea una y otra vez: Gemini es la “killer app” de las gafas XR Project Aura. No es solo un asistente que responde preguntas, sino la pieza que conecta cámara, pantalla flotante, móvil y reloj para crear experiencias nuevas.

Cuando miras un cuadro y llamas a Circle to Search, es Gemini el que reconoce la obra y el artista. Cuando pides música, es Gemini quien coordina con YouTube Music para mostrar el widget en el aire. Cuando haces fotos por voz o necesitas una traducción en vivo, vuelves a hablar con Gemini. Google quiere que tú percibas que comprando unas gafas XR compras, sobre todo, una experiencia de IA multimodal que entiende imagen, audio, texto y contexto al mismo tiempo.

Una sorpresa importante es que las gafas XR basadas en Android, incluidas estas Project Aura, no van a ser exclusivas de Android. Google quiere que las gafas Android XR del año que viene sean también compatibles con iOS, algo bastante poco habitual en un mundo donde cada marca intenta atrapar al usuario en su ecosistema.

Según Juston Payne, director de gestión de producto de XR en Google, el objetivo es llevar la experiencia de Gemini multimodal al mayor número de personas posible. Si usas iPhone y tienes instalada la app de Gemini, vas a poder disfrutar de la misma experiencia completa de Gemini en las gafas XR Project Aura, sin quedarte con una versión recortada desde el principio.

Payne añade que esta compatibilidad con iOS se extenderá de forma general a varias apps de Google, como Google Maps o YouTube Music. En la práctica, eso significa que un usuario de iPhone podrá ver mapas, escuchar listas de música o usar Gemini en las gafas XR Project Aura sin cambiar de teléfono.

Las principales limitaciones para iOS vendrán por el lado de las apps de terceros, ya que el control de Apple sobre su plataforma es más estricto y puede poner trabas a ciertas integraciones avanzadas. El equipo de Android XR afirma que está explorando distintas soluciones para mitigar estas barreras, pero no todo dependerá de ellos.

En un contexto donde el “lock-in” de los wearables está más fuerte que nunca, esta apuesta por la interoperabilidad entre Android XR e iOS se percibe como un movimiento fresco. Google intenta diferenciarse de Meta, que lidera hoy en hardware XR pero solo hace poco ha abierto la API de sus gafas inteligentes a desarrolladores, y también de Apple, que va más retrasada tanto en IA como en gafas inteligentes.

La estrategia de las gafas XR Project Aura no se entiende sin mirar la carrera entre grandes tecnológicas. Google está aprovechando todo su ecosistema Android para dar ventaja a Android XR frente a Meta. Aunque Meta va por delante en hardware XR, la apertura de su API para gafas inteligentes ha llegado más tarde, y su modelo se centra mucho en su propio entorno cerrado.

El movimiento de Google coloca presión adicional sobre Apple, que hoy va por detrás en inteligencia artificial aplicada al día a día y tampoco tiene aún unas gafas inteligentes de uso masivo. Para un dispositivo intermedio como Project Aura, que no es ni un simple accesorio ni un casco gigante, la interoperabilidad entre formatos de dispositivo (móviles, relojes, gafas) se presenta casi como condición imprescindible para tener alguna opción de éxito.

Chi Xu recuerda que Xreal puede ir haciendo el hardware cada vez más compacto, pero deja claro que ellos no cuentan con un ecosistema propio. Su postura es que solo Apple y Google tienen tamaño suficiente para sostener esa capa de software y servicios, y que Apple no va a colaborar con terceros, por lo que colaborar con Google resulta casi obligatorio para empresas como Xreal.

Desde el lado de Google, la lección de Google Glass parece muy presente. Esta vez la compañía evita hacerlo todo sola y apuesta por asociarse con fabricantes como Xreal. También intenta alejarse del diseño llamativo y polémico de las Glass originales, reduciendo la sensación de gadget raro y buscando un aspecto más cercano a unas gafas normales, aunque sean algo más voluminosas.

Otro cambio importante es que Google se está preocupando por tener apps listas antes del lanzamiento comercial de las gafas XR Project Aura. No quiere repetir errores pasados de salir al mercado con poca utilidad real. Los prototipos exploran formatos variados (solo audio, una lente o dos lentes), y la compañía se centra en llegar con una oferta de experiencias que vaya más allá de las cuatro funciones básicas.

El tema social y de privacidad pesa mucho cuando hablamos de gafas con cámara. Google sabe que no quiere repetir la fama negativa de los “glassholes”, esos usuarios de Google Glass vistos como invasivos o maleducados. Por eso, con las gafas XR Project Aura se han anunciado varias medidas pensadas para dejar claro cuándo se está grabando o capturando algo.

En primer lugar, las gafas tendrán una luz brillante y pulsante siempre que se esté grabando o se vaya a guardar contenido. Esto incluye también las consultas a Gemini que hagan uso de la cámara, por ejemplo, cuando apuntas a un cartel o a un cuadro. Así, la gente de tu alrededor sabrá si la cámara está activa y no tendrá que fiarse solo de tu palabra.

Para dar aún más transparencia, las gafas XR Project Aura contarán con interruptores físicos de encendido y apagado de los sensores, como la cámara. Estos interruptores llevarán marcas claras en rojo y verde, de forma que puedas demostrar de manera visible que las gafas no están grabando nada si alguien te lo pregunta en un espacio sensible.

Además, Google ha indicado que aplicará a las gafas los mismos marcos de permisos, políticas de privacidad, cifrado, retención de datos y garantías de seguridad que ya usa en Android y en Gemini. Esto incluye un proceso específico para conceder acceso a determinados sensores, con el objetivo de evitar usos indebidos de la cámara por parte de apps externas.

La postura de la empresa será conservadora a la hora de dar acceso a las cámaras de las gafas XR Project Aura a desarrolladores externos. No todas las apps podrán usar la cámara como quieran, y se priorizará que las funciones sensibles pasen por canales controlados. Sobre el papel, estas decisiones abordan varios de los grandes retos actuales de las gafas inteligentes, en especial el miedo a ser grabado sin consentimiento.

En conjunto, las gafas XR Project Aura apuntan a un producto que mezcla escritorio virtual, juegos 3D, apps Android sin cambios y una integración profunda con Gemini, móviles y relojes. Google ha aprendido de fracasos anteriores, ha buscado socios como Xreal y ha trabajado en la privacidad desde el diseño.

Falta tiempo hasta su lanzamiento en 2026 y muchas piezas pueden cambiar, así que la gran incógnita es si esta apuesta por Android XR, la compatibilidad con iOS y un ecosistema común bastarán para que tú veas estas gafas XR como algo útil en tu día a día y no solo como otro experimento llamativo de la tecnología.

Me dedico al SEO y la monetización con proyectos propios desde 2019. Un friki de las nuevas tecnologías desde que tengo uso de razón.

Estoy loco por la Inteligencia Artificial y la automatización.