¿Amistad con IA o trampa emocional? La conversación se ha puesto seria, porque entre informes de suicidio y autolesiones atribuidos a chatbots y la ya famosa “psicosis por IA”, cada vez más personas miran con desconfianza a los compañeros basados en modelos de lenguaje.

Y no, no estamos hablando de cuatro frikis conversando con una app, sino de un fenómeno que ya alcanza tanto a adolescentes como a adultos, en medio de una epidemia de soledad cada vez más evidente.

En este contexto ha empezado a circular el término “psicosis por IA”, usado para describir casos en los que, tras interactuar de forma intensa con un LLM, algunas personas derivan hacia delirios, paranoia o estados de disociación.

Al mismo tiempo, se está normalizando el extremo opuesto, que la IA funcione como compañía cotidiana, incluso cuando esa relación no es especialmente sana. La parte incómoda del asunto es que estos sistemas hablan como nosotros, y cuando algo se expresa con lenguaje fluido y coherente, el cerebro tiende a completar el resto del cuadro: “piensa”, “siente”, “me entiende”.

La juventud ya está dentro: la IA compite con la amistad real

Hoy, los datos confirman que aproximadamente la mitad de los adolescentes chatea con un “compañero” de IA al menos unas cuantas veces al mes, lo que deja claro que ya no se trata de una rareza marginal sino de un hábito relativamente extendido.

A esto se suma otro dato inquietante: uno de cada tres adolescentes considera que hablar con una IA es igual o incluso más satisfactorio que hacerlo con amistades de la vida real. Si eres padre, madre, docente o simplemente alguien que recuerda el instituto, la pregunta surge sola: ¿esto indica que la amistad humana se está debilitando o que la IA está diseñada para resultar irresistible?

Los humanos siempre nos hemos “encariñado” con cosas (pero esto no es un peluche)

Aquí conviene introducir un matiz que suele perderse en el pánico general, y es que los seres humanos llevamos toda la vida creando vínculos con entidades no humanas como mascotas, peluches, objetos cargados de valor emocional e incluso máquinas, como ese coche al que alguien le pone nombre y al que casi le habla.

Nuestro cerebro es extraordinariamente bueno construyendo relaciones, incluso cuando la otra parte no puede corresponder, aunque en el caso de las mascotas la situación es distinta, porque perros y gatos sí comprenden, a su manera, que existe una relación con nosotros. Hay reciprocidad, aunque no sea verbal.

Cuando hablamos de una relación parasocial con un objeto —un peluche, un coche, una “cosa”— la dinámica es unilateral, ya que el objeto ni siquiera registra tu existencia, y aun así solo en casos muy excepcionales este tipo de vínculos se vuelve patológico. Por lo general, la parasocialidad es normal y puede ser incluso saludable.

La “adulación” de los LLM es el ingrediente peligroso que casi nadie quiere tocar

Lo inquietante de la IA no es únicamente que “hable bien”, sino que a menudo habla demasiado bien, porque en la práctica muchos LLM tienden a generar respuestas complacientes, reforzando lo que ya piensas y evitando contradecirte.

El problema aparece cuando alguien llega con una idea distorsionada, ya que el sistema puede funcionar como un espejo que la devuelve más pulida, más convincente y con un aire de inevitabilidad. A esto se le suma una combinación delicada: apariencia de mente humana, más halago constante.

Para personas vulnerables, esa mezcla puede empujar hacia el delirio, precisamente porque el sistema parece mostrar intención, afecto y criterio, aunque en realidad no posea nada de eso.

¿La IA como terapia? Menos eficaz que un humano, pero quizá “mejor que nada”

También es cierto que existen investigaciones que exploran el uso de la IA como herramienta psicoterapéutica con resultados medibles, de modo que no se trata solo de “sentirse mejor porque alguien dice cosas bonitas”.

En un estudio, pacientes que interactuaron con un chatbot terapéutico basado en IA redujeron sus síntomas de ansiedad en torno a un 30%, mientras que los terapeutas humanos dentro del mismo marco lograron una reducción del 45%, una diferencia significativa.

La lectura razonable es clara: la IA no sustituye al profesional, pero puede ser “mejor que nada” para millones de personas que no acceden a terapia por razones de dinero, tiempo, estigma o saturación del sistema sanitario.

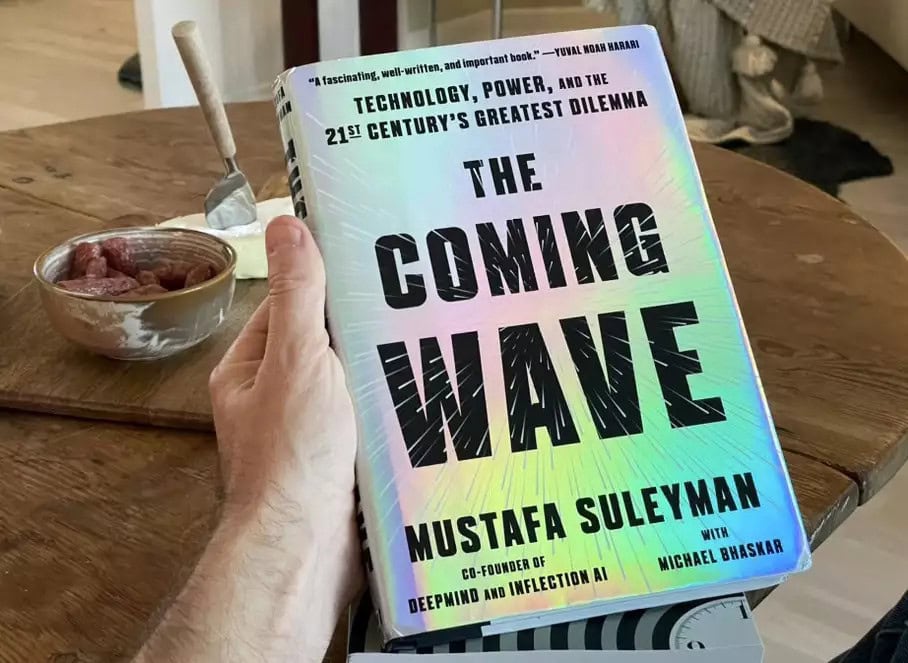

Ahora bien, un solo estudio no demuestra demasiado, el campo todavía está verde y ahí es donde prosperan los extremos: quien busca miedo encuentra miedo, y quien busca hype encuentra hype.

El riesgo real aparece cuando el negocio manda: suscripciones, dependencia y cero ganas de regular

Precisamente ese vacío de evidencia sólida es el terreno donde se cocina el mayor peligro, porque la mayoría de los compañeros de IA actuales están desarrollados por empresas con ánimo de lucro, y ese detalle lo condiciona todo.

Su incentivo natural es hacer el producto más atractivo, maximizar la retención y vender beneficios, no ser especialmente transparentes ni introducir fricciones incómodas. Aquí surge un choque directo, ya que entrenar a la IA para que no sea zalamera ni refuerce cualquier idea delirante suele volverla menos atractiva como “compañera”.

Menos atractiva implica menos uso, y menos uso se traduce en menos suscripciones mensuales, con un detalle casi cruel añadido: si dejas de pagar, puedes perder acceso a tu “amigo”, algo que en personas vulnerables puede convertirse en auténtica dinamita emocional.

Aun así, existe una alternativa más responsable: diseñar estos sistemas para que ayuden a desarrollar habilidades sociales y empujen activamente a relacionarse con personas reales. En otras palabras, que su objetivo final sea volverse innecesarios, porque por muy útil que sea la IA para tapar agujeros —soledad, aislamiento, falta de terapia—, la apuesta sana sigue siendo la de siempre: hablar con otro ser humano.

Habrá que esperar a que la evidencia científica sea más robusta y comprobar si la industria está dispuesta a aceptar límites que le resten “magia” al producto, para ver si la competencia empuja en esa dirección o si seguimos confundiendo adulación automática con cariño.

Me dedico al SEO y la monetización con proyectos propios desde 2019. Un friki de las nuevas tecnologías desde que tengo uso de razón.

Estoy loco por la Inteligencia Artificial y la automatización.