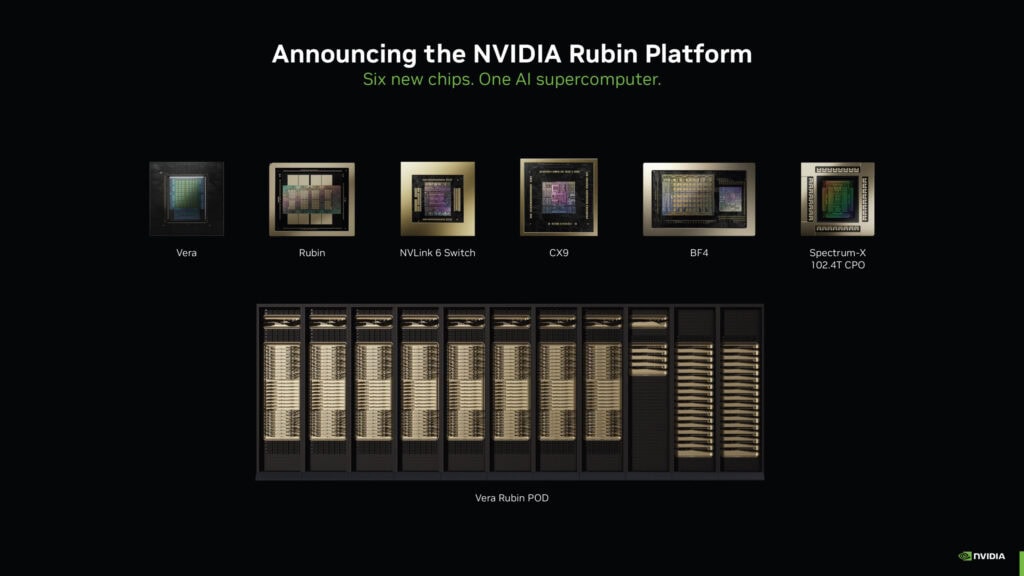

Runway acaba de mover ficha a lo grande: ha desplegado su modelo de vídeo Gen-4.5 y la nueva familia de “modelos de mundo” GWM-1 sobre la plataforma NVIDIA Vera Rubin NVL72. No va solo de hacer clips bonitos ni de subir una demo más al escaparate, sino de demostrar vídeo de alto rendimiento y contexto largo corriendo sobre la infraestructura más reciente de NVIDIA.

En la práctica, esto coloca a Runway entre las primeras compañías que enseñan músculo de verdad en Rubin con generación de vídeo profesional, no experimental. Y aquí la pregunta importante no es si el modelo puede generar vídeo —eso ya lo hacen muchos—, sino si puede generar vídeo largo, coherente y realista sin colapsar en latencia.

Uno de los detalles más reveladores es que Gen-4.5 se migró desde NVIDIA Hopper a Rubin en un solo día. Eso no es marketing ligero: migrar modelos punteros entre generaciones de hardware rara vez es un proceso trivial. Aquí no hablamos de “ya lo portaremos cuando tengamos tiempo”, sino de compatibilidad directa y de un stack preparado para cargas de trabajo de producción a gran escala.

La lectura importante no es la velocidad en sí, sino lo que implica. Si el salto a Rubin es rápido, el cuello de botella deja de ser técnico y pasa a ser económico y operativo: cuánto cuesta correrlo y para cuántos usuarios puedes servirlo a la vez. Y ahí es donde se nota que NVIDIA ya no vende solo GPUs, sino una autopista completa para IA. Quien llegue primero con software capaz de exprimirla de verdad se queda con ventaja estructural.

Runway describe Gen-4.5 como su modelo diseñado específicamente para generación de vídeo en tiempo real con alta fidelidad, y aquí aparece el número que levanta cejas: 50 petaflops de computación de inferencia por GPU. Es potencia bruta pensada para empujar millones de operaciones mientras el modelo “imagina” el siguiente fotograma sin que el usuario sienta que el sistema se arrastra.

Ahora bien, los petaflops por sí solos no garantizan nada. El vídeo generativo se rompe no en el primer frame, sino cuando intentas sostener una escena durante segundos o minutos. Lo que Runway sugiere es que, con ese nivel de inferencia, pueden atacar el gran talón de Aquiles del sector: coherencia temporal, continuidad de sujetos y consistencia de escena en secuencias largas.

También te puede interesar:Runway Gen-4.5: Crea Videos a Partir de Textos con una IA de Precisión Sin PrecedentesMás allá del vídeo, GWM-1 introduce simulaciones en tiempo real con conciencia de la física. No se limita a generar píxeles plausibles, sino que intenta comportarse como un mundo donde las cosas pesan, chocan, caen y se mueven con reglas. Esto conecta con un giro cada vez más claro en la industria: pasar de modelos que describen el mundo a modelos que lo simulan.

Runway apunta directamente a la robótica, y tiene sentido. Entrenar robots en el mundo real es caro, lento y propenso a errores físicos muy costosos. Simular antes de tocar hardware reduce riesgos, pero también sube el listón: si la simulación miente, el robot aprende mal y el golpe llega después.

A esto se suman entornos virtuales explorables y avatares interactivos, es decir, mundos que no solo se miran, sino que responden a acciones. NPCs que, por fin, no suenan a software de hace veinte años.

Todo esto corre sobre NVIDIA Vera Rubin NVL72, una plataforma pensada para escalar, no para lucirse en una slide. El mensaje implícito es claro: no se trata de enseñar una demo bonita, sino de mostrar cómo se despliega globalmente para industrias enteras. En el caso del vídeo generativo en tiempo real, la infraestructura es la diferencia entre una promesa y un producto viable.

Aquí Rubin aparece como el terreno donde se decide quién puede ofrecer generación de vídeo y simulación de mundos a gran escala, especialmente cuando hablamos de latencia baja y uso continuo. Se mencionan despliegues globales para entretenimiento, robótica y realidad virtual, pero el subtexto es más amplio: el futuro inmediato de la IA no va a ser solo conversar, sino generar escenas, simular entornos y reaccionar a acciones humanas en tiempo real.

Tanto Gen-4.5 como GWM-1 ya están disponibles para socios empresariales y de investigación. Eso suele significar una fase de uso controlado: clientes con casos exigentes, presupuesto y tolerancia a los bordes afilados de una tecnología avanzada. No es todavía consumo masivo, pero tampoco es laboratorio cerrado.

También es una señal de madurez. Poner estas herramientas en manos de empresas e investigadores implica confianza en el pipeline, aunque todavía se estén afinando costes, límites y estabilidad. La colaboración “estrecha” entre Runway y NVIDIA suena exactamente a lo que es: una alianza estratégica para empujar los límites de lo posible, con la infraestructura como condición no negociable.

Porque la generación de vídeo y la simulación de mundos no perdonan: o tienes cómputo, o tienes excusas. Y lo interesante viene después. Si Gen-4.5 cumple de verdad en vídeo largo en tiempo real, y si GWM-1 logra simulaciones útiles para robótica y entornos interactivos, veremos una oleada de productos que hoy todavía suenan a ciencia ficción.

La competencia reaccionará, seguro. Pero una cosa ya queda clara: esto ya no va de generar “un clip”. Va de generar realidad operativa, y eso cambia las reglas del juego.

Me dedico al SEO y la monetización con proyectos propios desde 2019. Un friki de las nuevas tecnologías desde que tengo uso de razón.

Estoy loco por la Inteligencia Artificial y la automatización.