xAI está dejando entrever que Grok Build no quiere limitarse a ser “un asistente que te sugiere código”, sino algo mucho más ambicioso: un IDE completo en el navegador, con una propuesta tan atractiva como arriesgada: ocho agentes de IA programando al mismo tiempo.

Lo que en enero sonaba a simple vibe coding simpático, ahora empieza a tomar forma de plataforma seria. La interfaz se renueva, aparecen sesiones dedicadas y hasta un modo oculto que permitiría hacer competir a los agentes entre sí. Ya no parece una demo llamativa, sino un producto con ambición estructural.

Además del agente local por CLI que ya se conocía, todo apunta a que una versión remota está avanzando en paralelo con intención de convertirse en un producto completo. Y cuando xAI mueve ficha, rara vez se conforma con lanzar un “copilot” más; su patrón es claro: construir sistemas con personalidad, velocidad y, si es posible, un componente de espectáculo tecnológico.

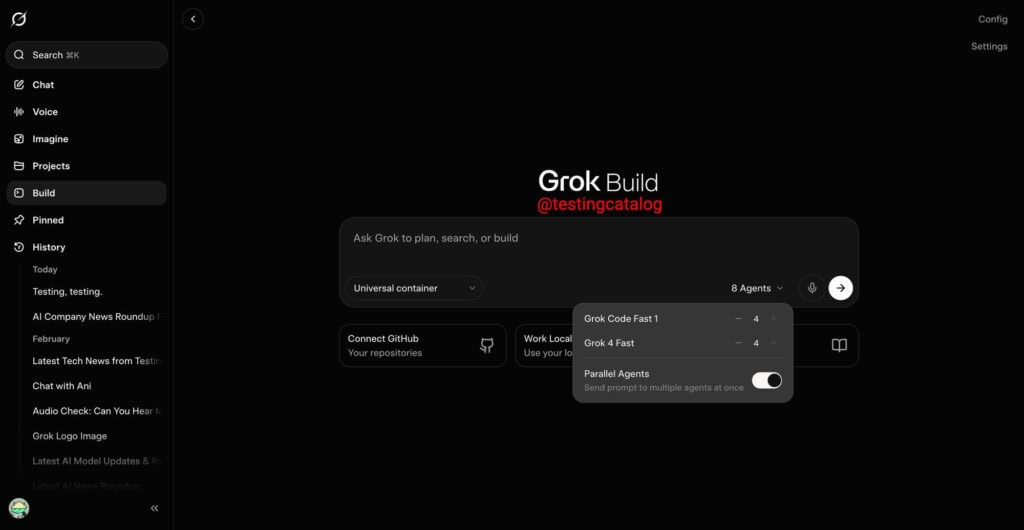

La novedad más llamativa se llama Parallel Agents. La idea es simple pero potente: envías un único prompt y varios agentes lo reciben simultáneamente.

En lugar de esperar una respuesta para luego pedir “otra opción”, el sistema genera múltiples propuestas al mismo tiempo, presentadas lado a lado para que puedas compararlas, combinarlas o elegir la que mejor encaje. Es un cambio de dinámica importante: pasas de iterar en línea recta a pensar en paralelo.

La interfaz actualmente expone dos modelos: Grok Code 1 Fast y Grok 4 Fast. El detalle clave es que se permiten hasta cuatro agentes por modelo, lo que significa que puedes lanzar hasta ocho agentes en paralelo dentro del mismo flujo de trabajo. No se trata de “más tokens por postureo”, sino de una apuesta clara por el enfoque multiagente como interfaz productiva: varias mentes, distintas estrategias y menos bloqueo creativo.

También te puede interesar:Grok estrena visión y nuevas funciones inteligentesAl activar Parallel Agents se abre una sesión de programación dedicada donde las respuestas aparecen simultáneamente, organizadas en paralelo. A esto se suma un rastreador de uso de contexto que actúa como un velocímetro del consumo, permitiéndote ver cuánto espacio estás ocupando durante la interacción. Es un detalle importante, porque evita el clásico momento en que el modelo empieza a degradarse y uno no entiende por qué; muchas veces, simplemente se ha quedado sin contexto útil.

Ahora bien, la vista paralela por sí sola no resuelve el problema central. Cuando tienes ocho respuestas distintas, sigues siendo tú quien compara, edita y decide cuál implementar. El sistema multiplica opciones, pero la carga cognitiva continúa recayendo en el usuario.

En el código hay indicios de un “arena mode” oculto, separado de Parallel Agents, y aquí es donde la propuesta cambia de escala. Mientras la vista paralela se basa en comparación manual, el modo arena parece diseñado para que los agentes colaboren o compitan con un objetivo claro: producir la mejor respuesta posible.

La hipótesis es que este “arena mode” permitiría puntuar y clasificar automáticamente las salidas, convirtiendo el proceso en una especie de mini benchmark en tiempo real aplicado a tu propio prompt. Ya no solo verías ocho propuestas distintas; el sistema intentaría decidir cuál gana y por qué.

Este enfoque recuerda a marcos tipo torneo utilizados en entornos enterprise, donde un agente “juez” organiza y ordena ideas mediante competición estructurada. Sin embargo, si xAI logra implementarlo de forma fluida dentro de la experiencia de desarrollo, la diferencia sería enorme. Pasaríamos de un modelo de “multi-salida” a un sistema multiagente con capa de evaluación integrada.

Y esa capa es, probablemente, donde se juega el verdadero valor de producto. Porque lo que realmente se reduce no es solo el tiempo de respuesta del modelo, sino la latencia mental del usuario. Menos comparar, más ejecutar.

La UI está experimentando una transformación notable y ya no se percibe como un simple chat con panel lateral. El soporte de dictado, por ejemplo, encaja perfectamente con la filosofía del “vibe coding”: hablar, iterar y dejar que el sistema traduzca intención en cambios concretos dentro del código.

También aparece un nuevo conjunto de pestañas —Edits, Files, Plans, Search y Web Page— que amplían el alcance del entorno. Esto ya no es un esquema de pregunta-respuesta, sino una navegación estructurada por base de código, planificación de tareas, búsqueda contextual y hasta previsualización en vivo mientras se realizan modificaciones. La experiencia se acerca más a un IDE tradicional que a un chatbot vitaminado.

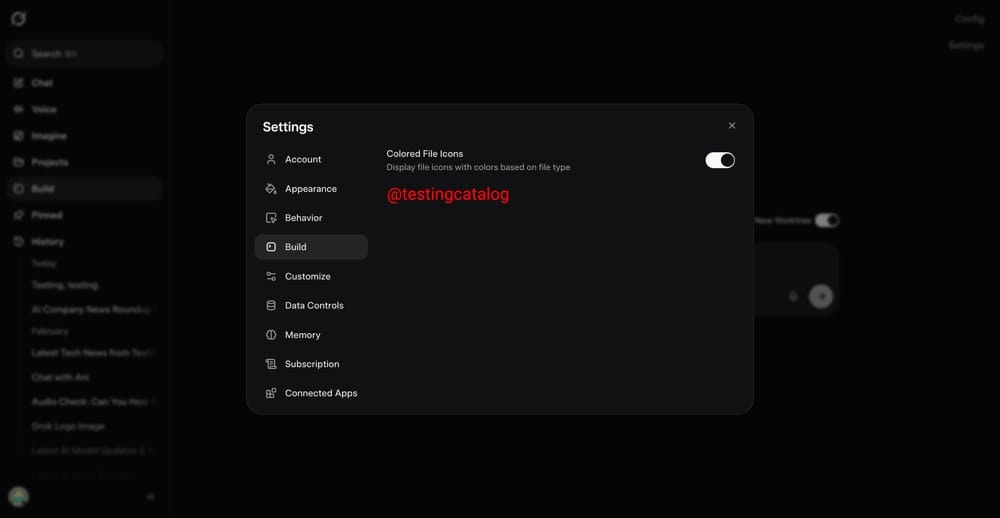

A esto se suman funciones como Share y Comments, orientadas a reforzar la colaboración. Sin embargo, la colaboración sin control de versiones ni integración real con repositorios queda incompleta. Por eso resulta especialmente interesante que en los ajustes ya aparezca una integración con una app de GitHub, aunque todavía no esté operativa.

El hecho de que esa conexión esté presente —aunque “apagada”— sugiere una intención clara: cerrar el ciclo completo, del agente al repositorio, del repositorio al pull request y del pull request a producción. En ese punto, estas herramientas dejan de ser curiosidades técnicas y empiezan a competir directamente en el flujo profesional de desarrollo.

Todo este planteamiento encaja con la visión que ha expresado Elon Musk: Grok generando “cientos de agentes de programación especializados trabajando juntos”. La idea no es un modelo monolítico que lo haga todo, sino un enjambre coordinado donde cada agente asume un rol específico: uno planifica, otro implementa, otro revisa, otro testea y otro documenta.

También se ha detectado una página interna oculta llamada “Vibe”, utilizada como herramienta de sobrescritura de modelo para el personal de xAI. Que exista tooling interno de este tipo suele ser buena señal, porque indica que el equipo está probando configuraciones y afinando el pipeline antes de abrirlo al público; en otras palabras, están “comiendo su propia comida”.

Sin embargo, el calendario no es del todo claro. El entrenamiento de Grok 4.20 se habría retrasado hasta mediados de febrero por problemas de infraestructura, y si la base de modelos o el hardware se demoran, el despliegue de estas funciones también puede verse afectado. La dirección técnica parece definida, pero la estabilidad y los tiempos aún están en construcción.

Si Grok Build termina consolidándose como un IDE multiagente con modo arena y evaluación automática, la comparación dejará de ser “¿es tan bueno como Copilot?” y pasará a una pregunta más incómoda para el mercado: “¿cuánto tardará el resto en replicar este formato?”.

Por ahora, toca esperar para ver si xAI logra aterrizar la propuesta con estabilidad, evaluación automática sólida e integración real con GitHub. Porque ocho agentes trabajando en paralelo suenan a exageración… hasta que lo pruebas y descubres que volver a un único hilo de trabajo se siente, de repente, demasiado lento.

Me dedico al SEO y la monetización con proyectos propios desde 2019. Un friki de las nuevas tecnologías desde que tengo uso de razón.

Estoy loco por la Inteligencia Artificial y la automatización.