Apple acaba de darle una vuelta seria a su IDE con Xcode 26.3, integrando de forma profunda el agentic coding con Claude Agent (Anthropic) y Codex (OpenAI), lo que permite programar en lenguaje natural sin salir del editor y sin depender de herramientas externas.

Esto ya no va de “sugiere una línea” o “explícame este error”, sino de agentes capaces de intervenir directamente en el proyecto, ejecutar tareas reales y devolver cambios con trazabilidad clara, algo que marca un salto cualitativo frente a los asistentes tradicionales.

En concreto, la Release Candidate de Xcode 26.3 ya está disponible desde hoy en la web para Apple Developers y, más adelante, llegará también a la App Store. Aun así, Apple no aterriza aquí de la nada: Xcode 26 ya había incorporado soporte para ChatGPT y Claude el año pasado, aunque en ese momento el enfoque era claramente el de un asistente conversacional más que el de un agente autónomo.

La palabra clave aquí es “agéntico”. El modelo no se limita a responder prompts, sino que utiliza herramientas internas de Xcode para avanzar dentro de un flujo real de desarrollo, como lo haría una persona sentada frente al proyecto.

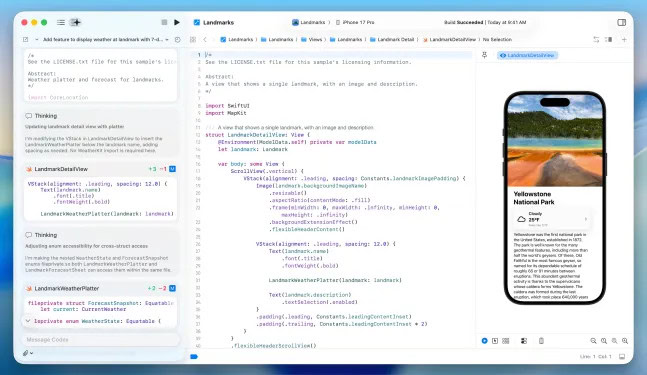

Desde el lanzamiento, estos agentes pueden explorar el proyecto, comprender su estructura y metadatos, compilarlo, ejecutar tests, detectar errores y corregirlos, encadenando acciones de forma coherente. En la práctica, lo que normalmente implica decenas de clics y varios minutos de prueba y error se convierte en una secuencia de pasos automatizados que el agente ejecuta sin que tengas que cambiar de ventana.

A esto se suma un detalle más importante de lo que parece: los modelos tienen acceso a la documentación actual de Apple, lo que les permite usar APIs recientes y seguir las buenas prácticas recomendadas por la propia plataforma. Justo ahí es donde muchos copilotos fallan, generando código que “parece Swift” pero no es idiomático, utiliza APIs obsoletas o ignora por completo el framework que querías emplear.

Apple ha elegido MCP (Model Context Protocol) para exponer las capacidades de Xcode a los agentes, una decisión que dice mucho sobre la dirección del producto.

Gracias a MCP, Xcode puede trabajar con cualquier agente externo compatible para tareas como descubrimiento del proyecto, modificación de archivos, gestión de recursos, previsualizaciones, snippets y acceso a documentación reciente. No se trata de que “Xcode solo hable con Claude y Codex”, sino de que Xcode abre sus mandos a quien implemente correctamente el protocolo.

Esto también funciona como una forma elegante de evitar un encierro total: hoy puedes empezar con Claude Agent o Codex, y mañana podría ser otro proveedor si se integra bien con MCP. Aun así, la parte práctica pesa, y Apple afirma haber trabajado estrechamente con Anthropic y OpenAI para diseñar la experiencia, asegurando que desde el primer día haya dos pesos pesados plenamente funcionales.

Apple también asegura haber optimizado el uso de tokens y llamadas a herramientas (tool calling) para que el agente funcione de manera fluida dentro de Xcode.

En términos prácticos, esto debería traducirse en menos latencia innecesaria, menos idas y vueltas y menos respuestas del tipo “necesito más contexto”, cuando ese contexto ya está presente en el workspace. El agente no se limita a generar texto, sino que decide qué herramienta usar, en qué orden y con cuánta información, evitando quemar tokens de forma absurda.

Apple no ha escondido esta funcionalidad detrás de menús enrevesados. Para probar el agentic coding basta con descargar, desde los ajustes de Xcode, los agentes que quieras utilizar y vincular tus cuentas con los proveedores de IA, ya sea iniciando sesión o añadiendo tu clave de API.

El gesto que lo deja todo claro es el menú desplegable para elegir la versión del modelo, con ejemplos como GPT-5.2-Codex frente a GPT-5.1 mini. Apple asume abiertamente que el desarrollador tomará decisiones de calidad, coste y velocidad, del mismo modo que ya ocurre en cualquier stack moderno de modelos.

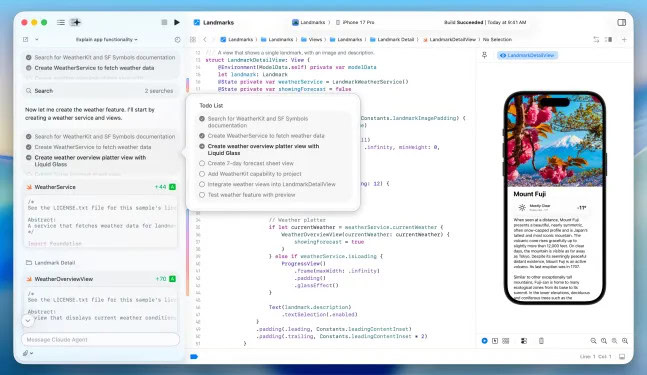

La interfaz acompaña esa idea: una caja de prompt en el lado izquierdo desde la que puedes pedirle al agente que cree o modifique funcionalidades en lenguaje natural. Incluso puedes describir cómo debe verse y comportarse una feature usando frameworks de Apple, casi como si estuvieras explicándola en una reunión de producto.

Uno de los aciertos más claros del planteamiento es que el agente descompone las tareas en pasos pequeños mientras trabaja, lo que reduce la sensación de pérdida de control.

Antes de empezar a programar, el agente busca la documentación que necesita y los cambios se resaltan visualmente dentro del editor, de modo que no estás frente a una caja negra que “te suelta un commit”. Ves qué toca, por qué lo toca y qué ha cambiado exactamente. Además, hay un transcript lateral que permite seguir todo lo que ocurre under the hood, algo especialmente útil para quienes están aprendiendo.

La confianza, sin embargo, se gana con pruebas y con marcha atrás. Al final del proceso, el agente verifica que el código funciona, ejecutando tests e iterando si hace falta para corregir errores. Si el resultado no te convence, puedes revertir en cualquier momento, ya que Xcode crea milestones cada vez que el agente realiza un cambio. Ese “undo con esteroides” es lo que hace viable trabajar con agentes sin el miedo constante a que te arruinen el proyecto.

Apple también lanza una recomendación muy realista: pedirle al agente que planifique antes de escribir código suele mejorar los resultados. Obligar al modelo a estructurar la solución reduce el riesgo de parches rápidos que luego chocan con la arquitectura, los tests o el naming del proyecto.

A esto se suma un movimiento de comunidad: Apple organizará un taller code-along en su web de desarrolladores para mostrar estas herramientas en acción. La gran pregunta es si esto convierte a Xcode en el IDE más cómodo para construir con IA o si llega tarde a una fiesta donde otros ya llevan meses afinando agentes.

Lo que sí es evidente es que, al integrar estas capacidades en su suite oficial, Apple eleva la presión competitiva para todo el ecosistema. Cuando el IDE “de fábrica” tiene agentes que compilan, testean y corrigen, el listón sube para todos. Si la ejecución está a la altura de lo prometido, desarrollar apps para iPhone, iPad, Mac o Apple Watch podría empezar a sentirse menos como una pelea con archivos y más como dirigir un pipeline inteligente. Ahora queda ver si el producto final cumple con el hype.

Me dedico al SEO y la monetización con proyectos propios desde 2019. Un friki de las nuevas tecnologías desde que tengo uso de razón.

Estoy loco por la Inteligencia Artificial y la automatización.